ms55

Banni-

Compteur de contenus

310 -

Inscription

-

Dernière visite

-

Jours gagnés

7

Type de contenu

Profils

Forums

Téléchargements

Blogs

Boutique

Calendrier

Noctua

Tout ce qui a été posté par ms55

-

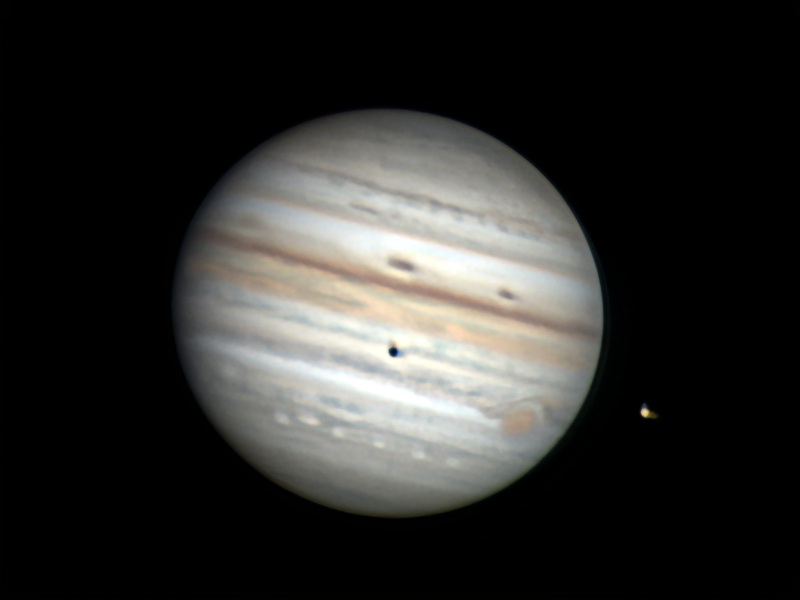

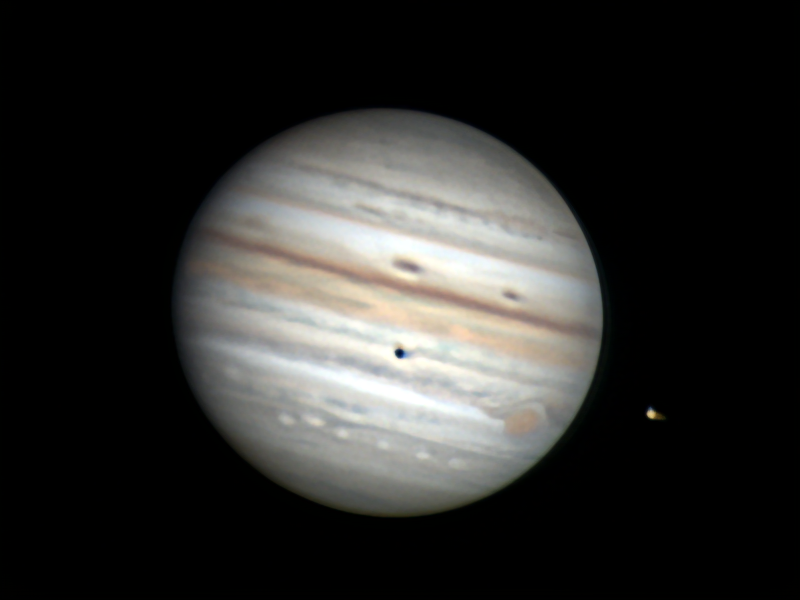

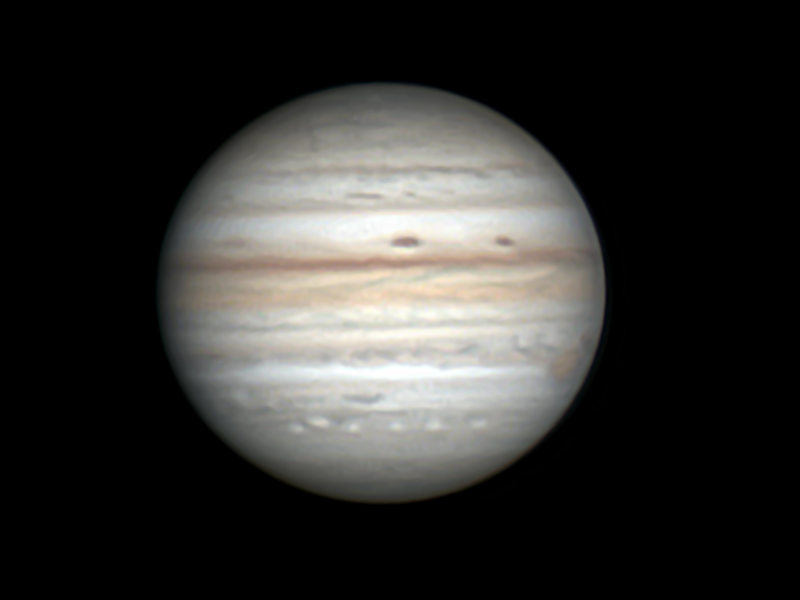

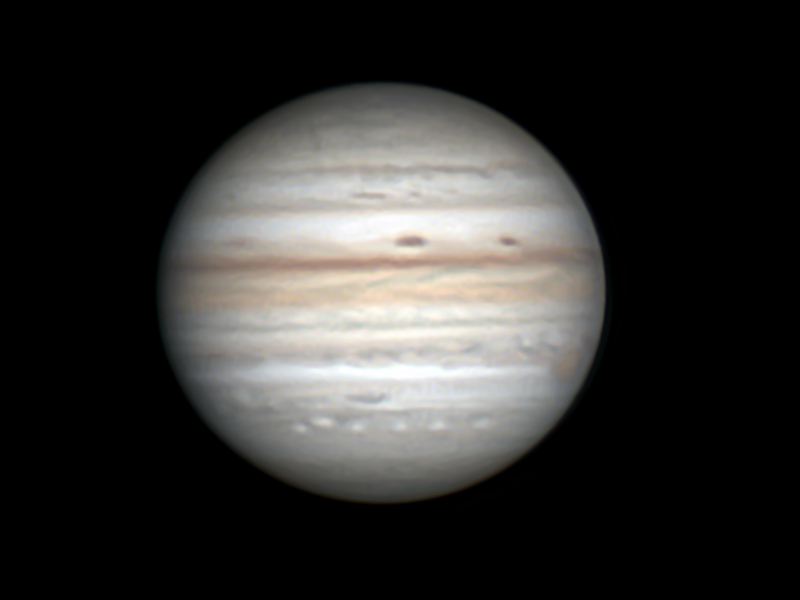

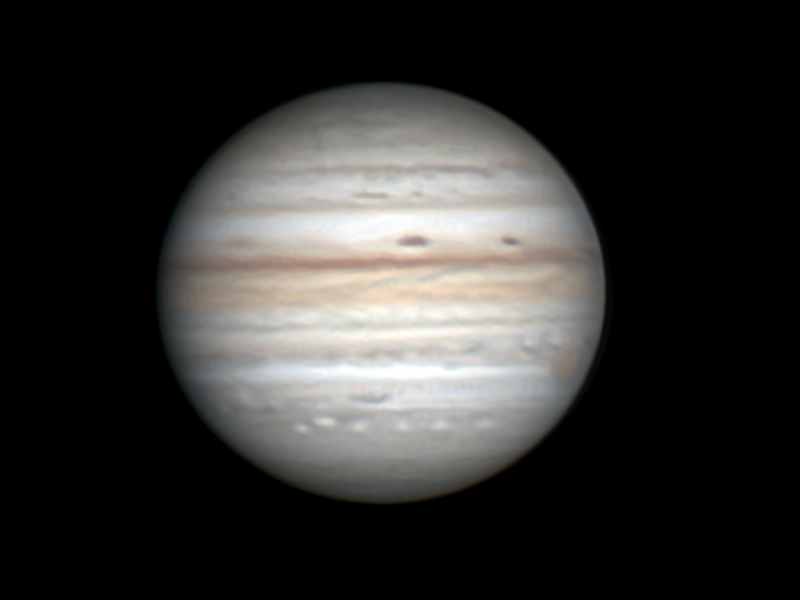

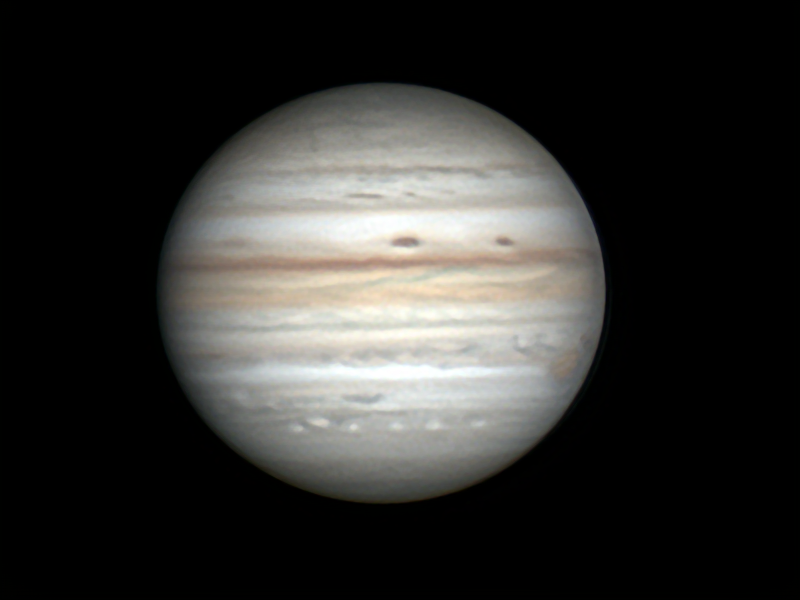

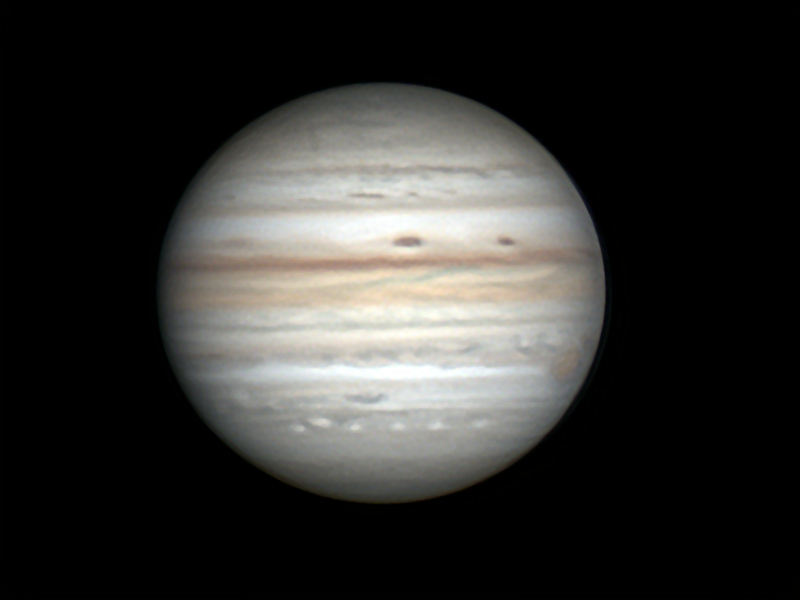

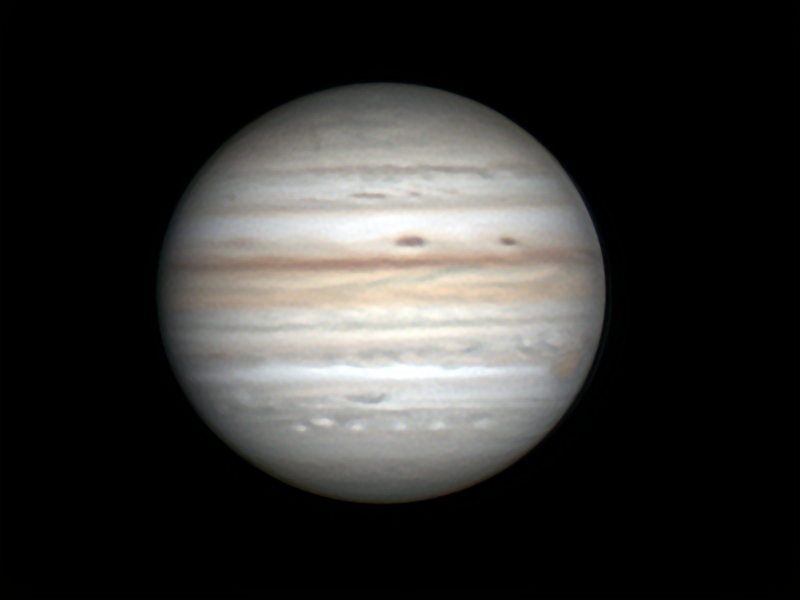

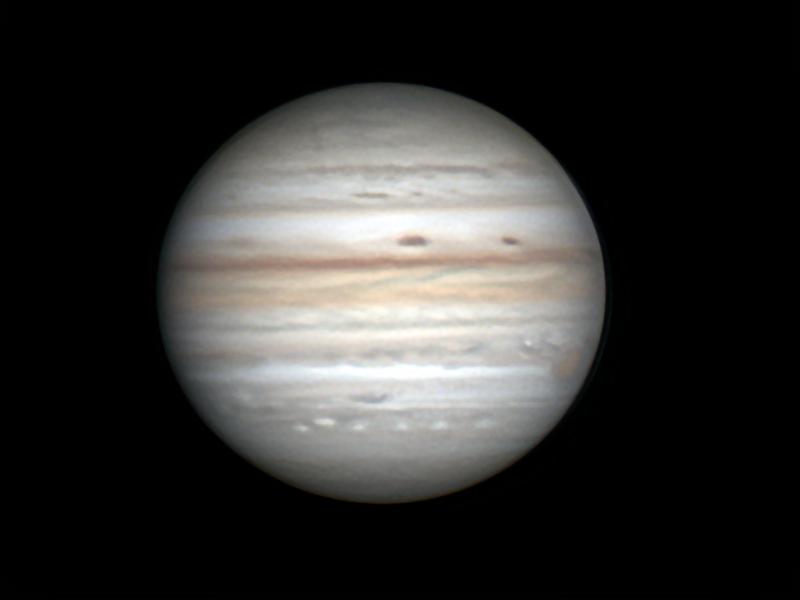

Jupiter le 30 septembre entre 22h30 et minuit TL

ms55 a répondu à un sujet de ms55 dans Astrophotographie

-

Jupiter le 30 septembre entre 22h30 et minuit TL

ms55 a répondu à un sujet de ms55 dans Astrophotographie

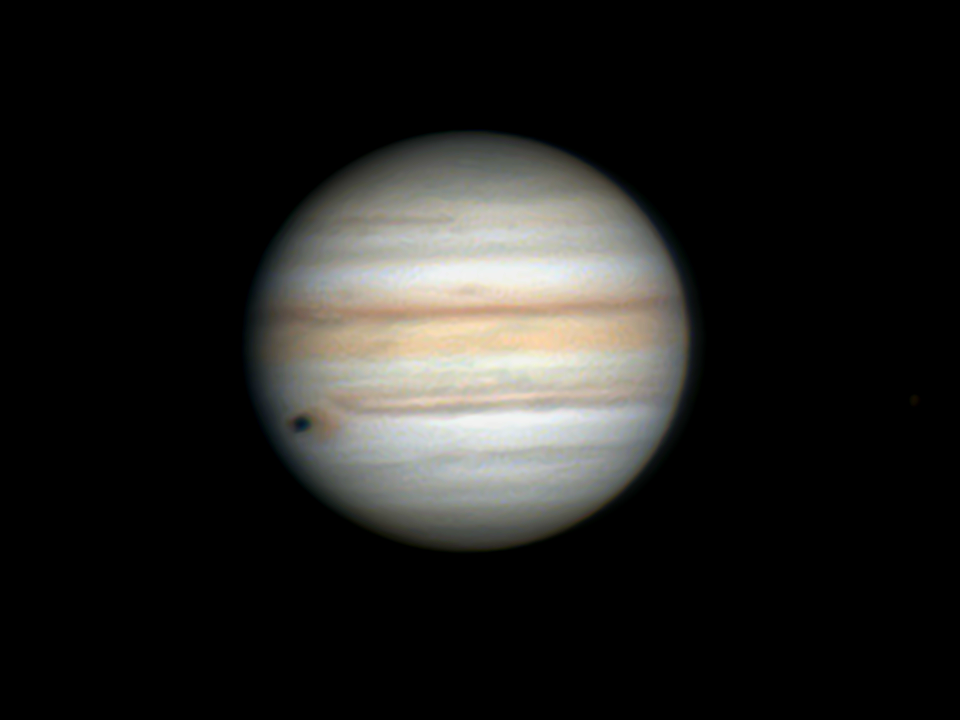

Pour vous rendre compte de ces voiles nuageux que l'on distingue mieux de jour. Le ciel se dégrade et il faudra apprendre à faire avec à l'avenir. Le satellite c'est Europe et cette traînée est peut-être due au voile nuageux car je ne l'ai jamais quand le ciel est transparent. Pour reconnaître les satellites, j'utilise SkyMap Pro. -

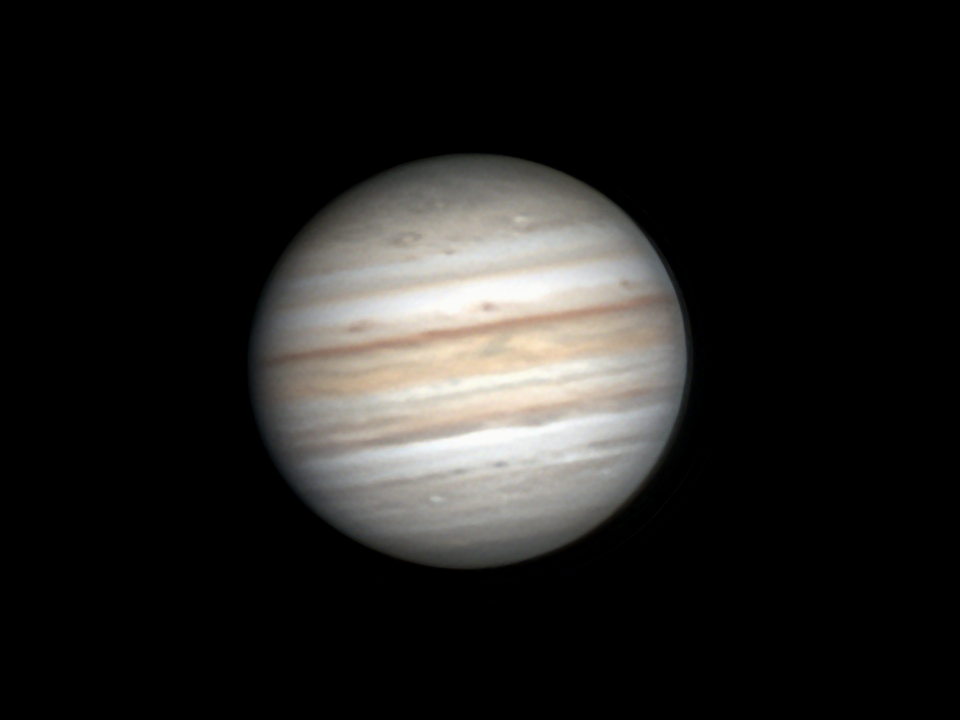

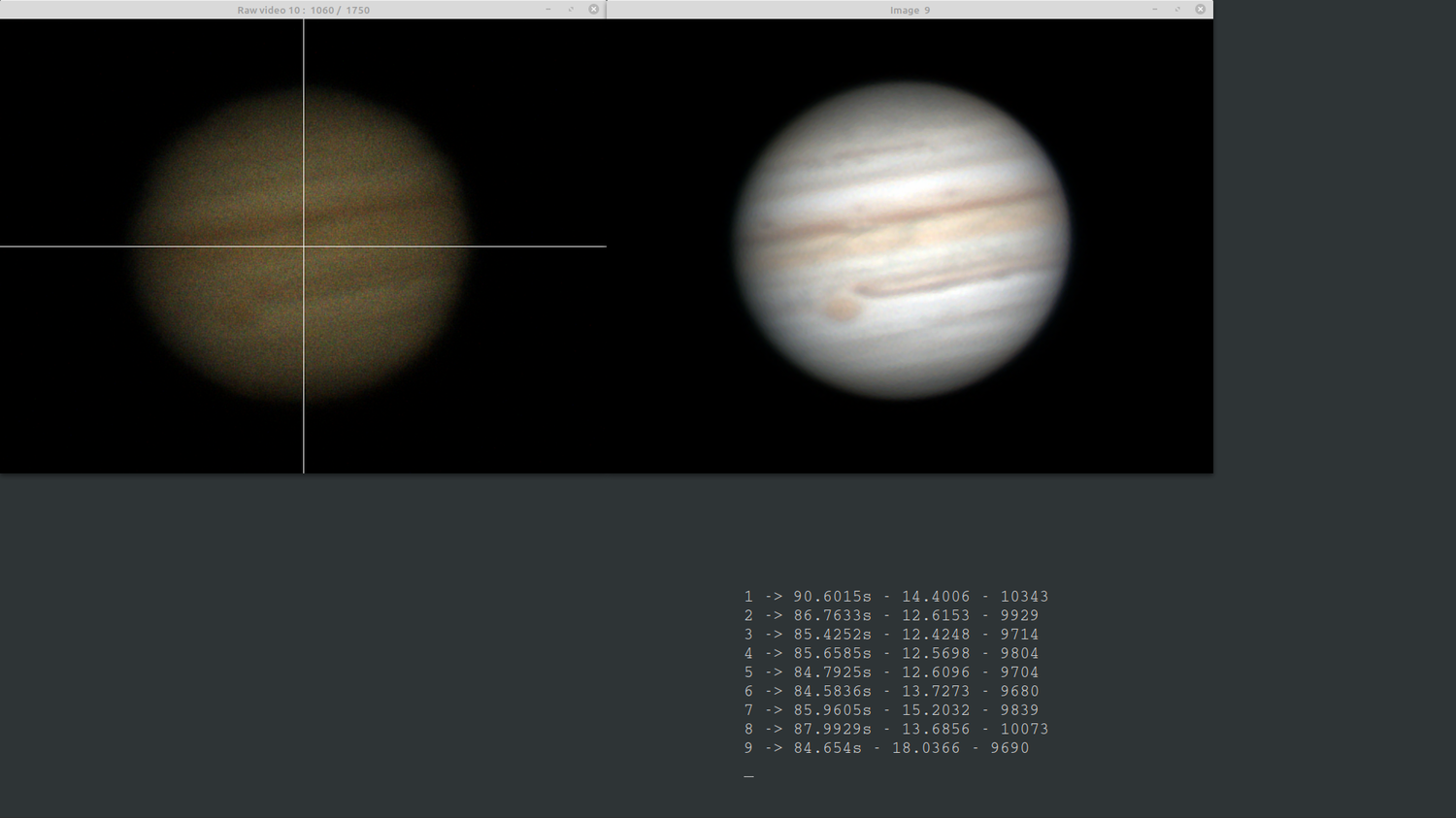

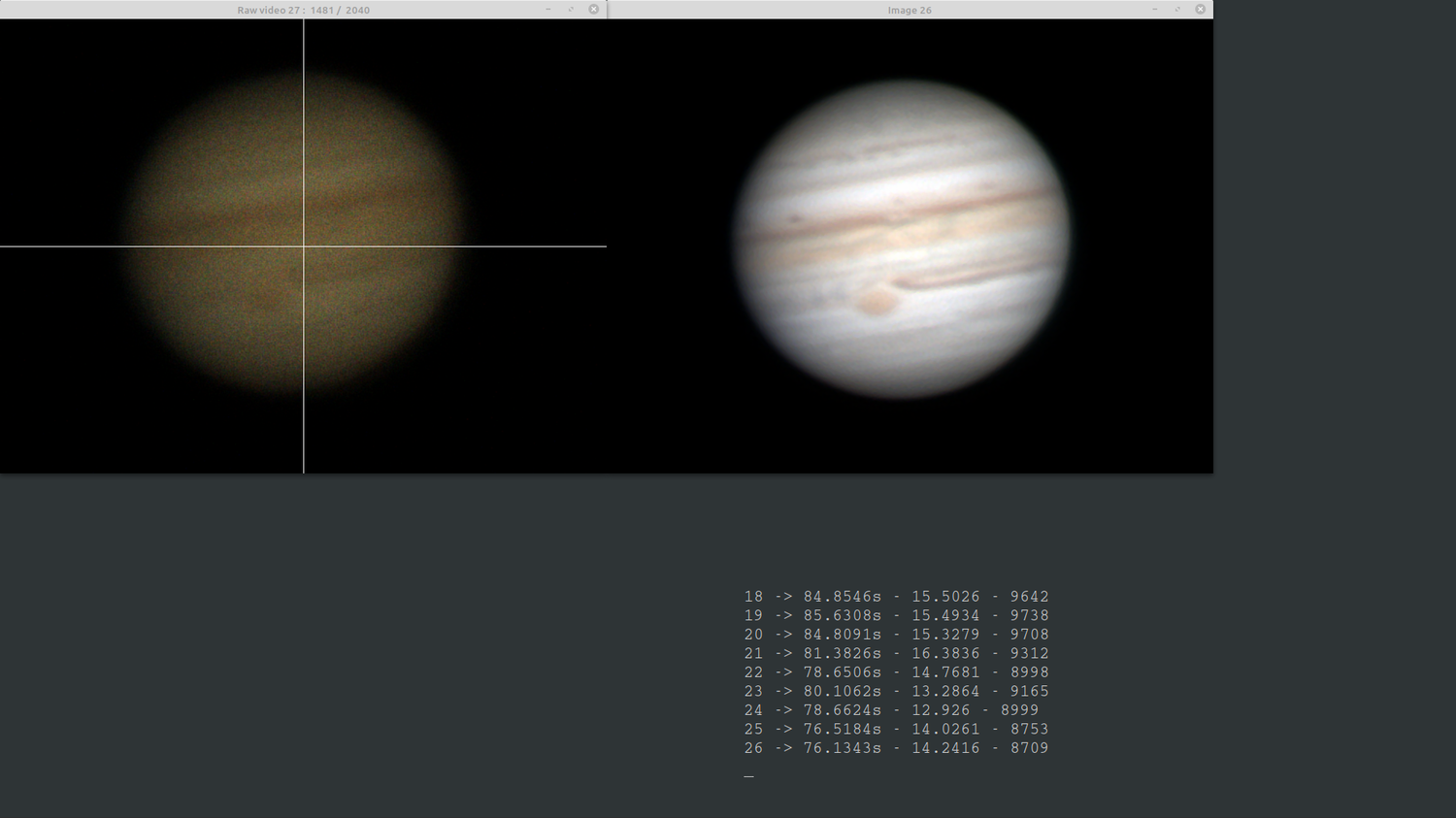

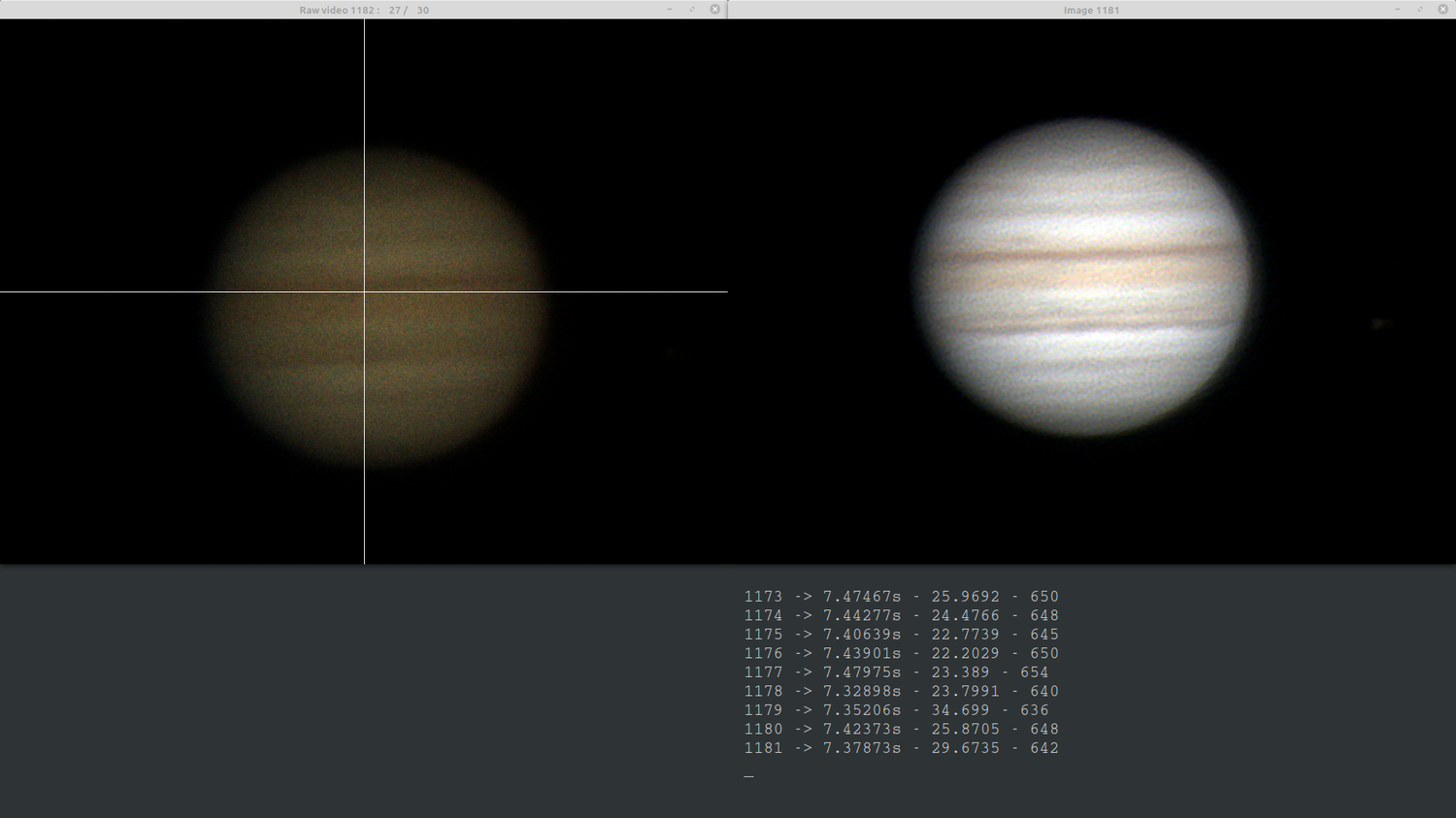

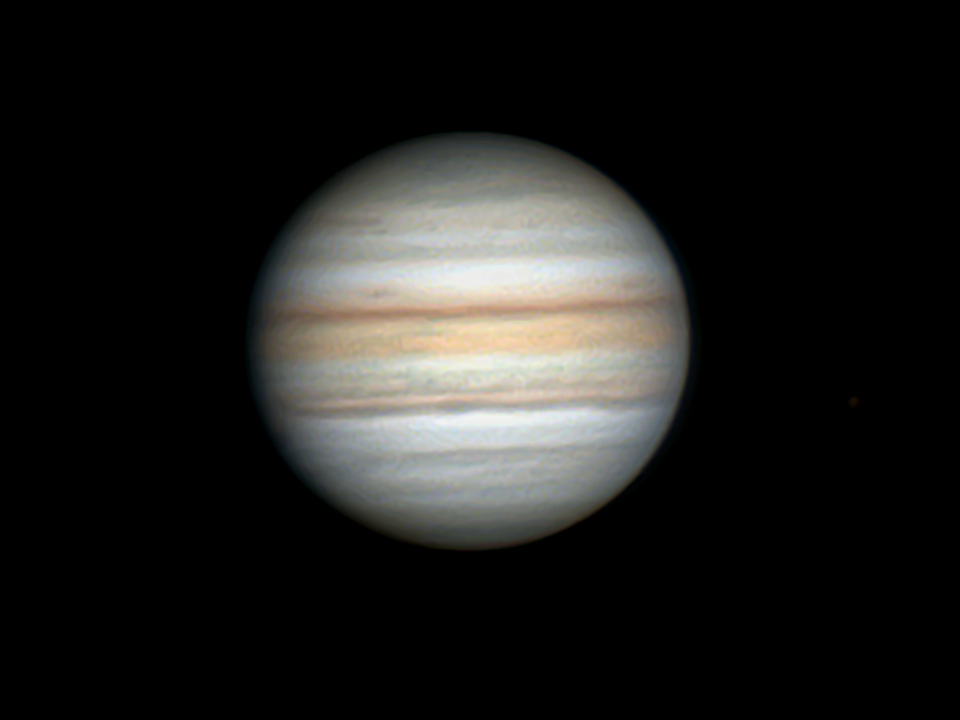

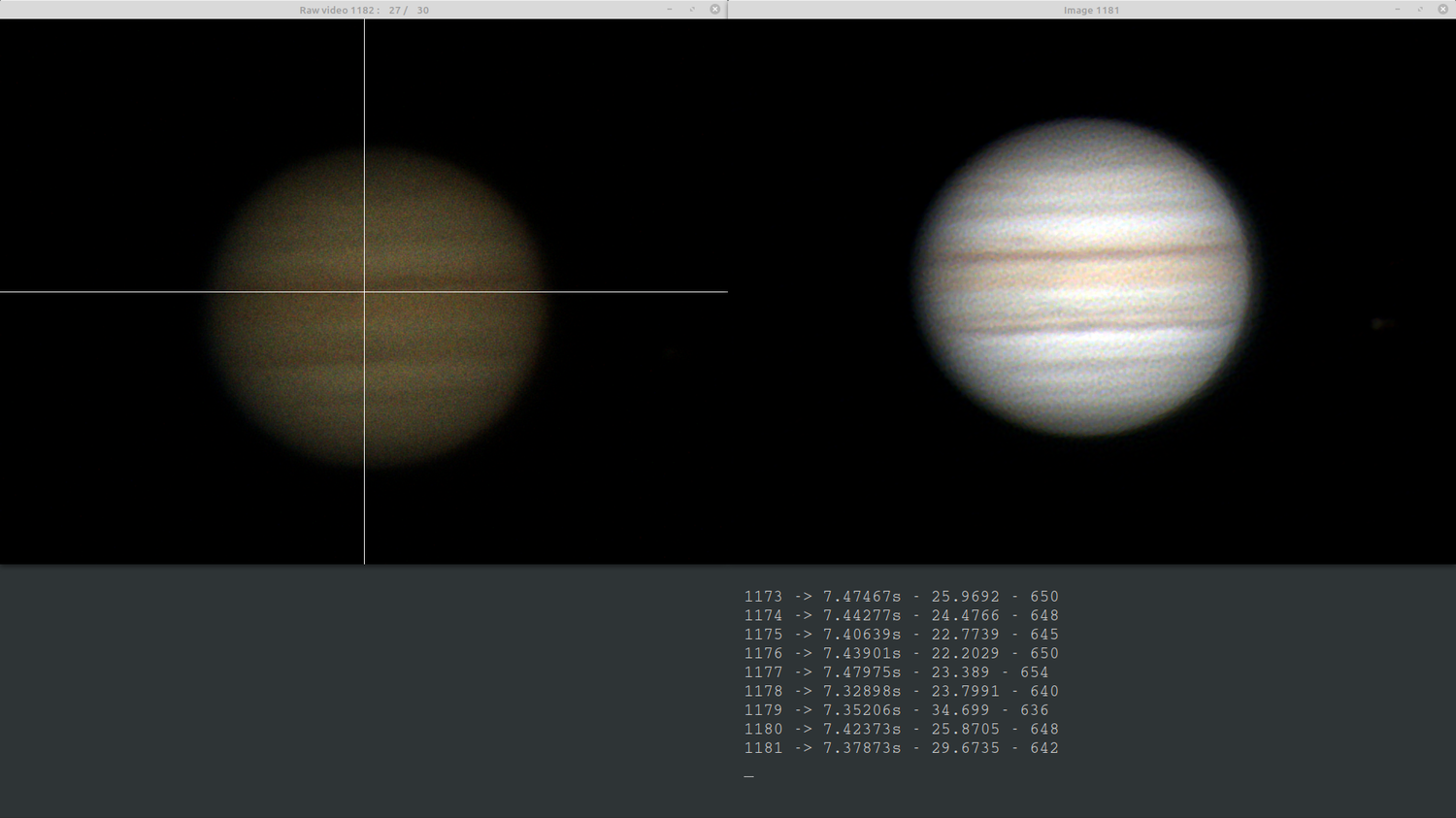

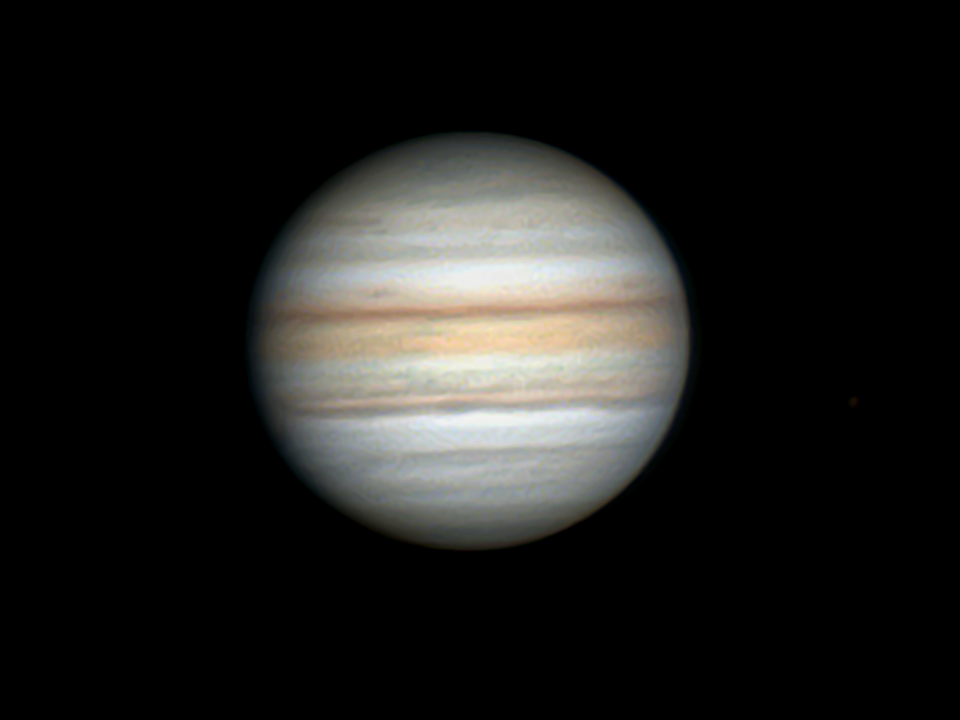

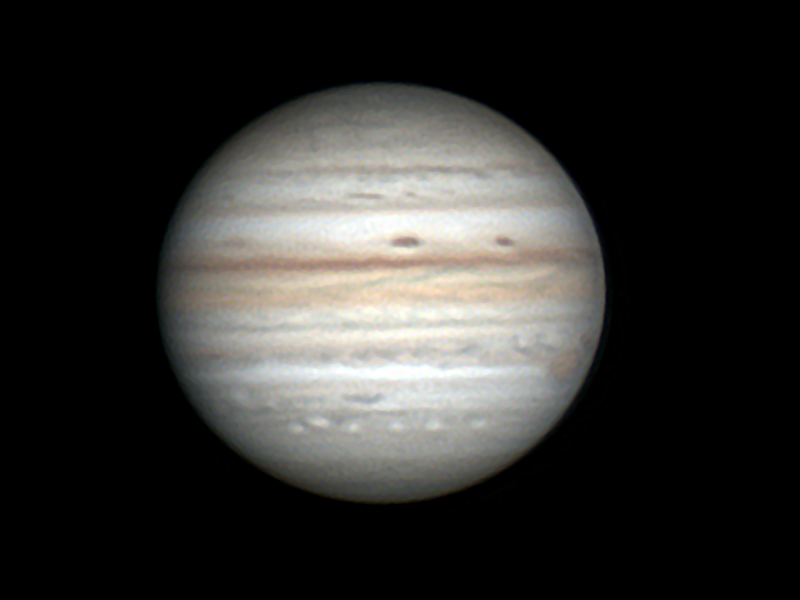

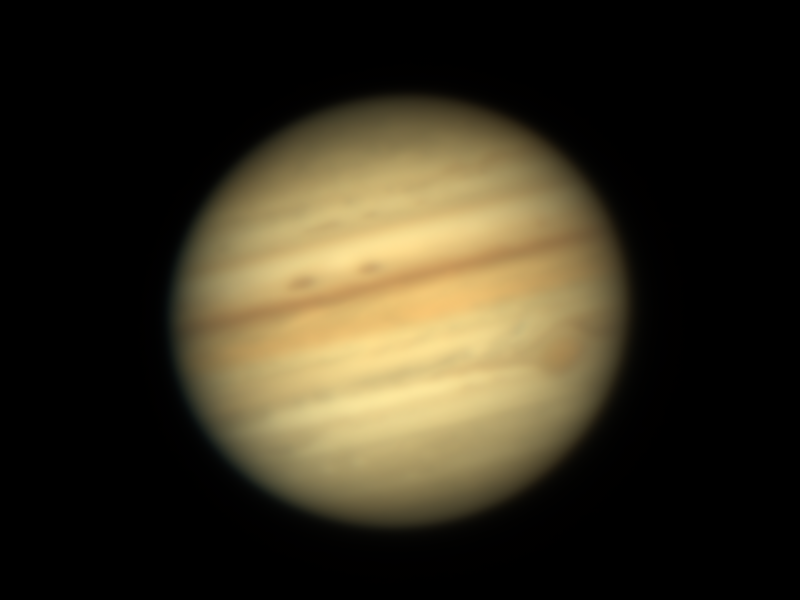

J'ai testé ce soir le contrôle automatique de l'exposition à chaque passage nuageux. Toujours la même configuration : C11@f/20 + ASI 462MC + EQ6-R Pro. Des passages nuageux permanents qui affaiblissaient la luminosité de la planète. Par contre un peu moins de turbulence que d'habitude. Les meilleures images de la vidéo (34, 39 et 40) : Une petite animation de 90 minutes :

-

Jupiter le 30 septembre entre 22h30 et minuit TL

un sujet a posté ms55 dans Observation en Visuel Assisté

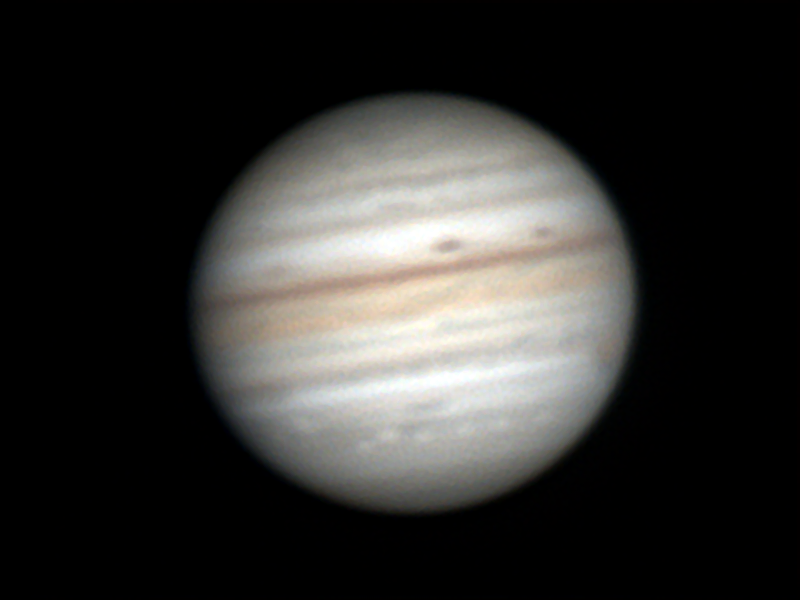

J'ai testé ce soir le contrôle automatique de l'exposition à chaque passage nuageux. Toujours la même configuration : C11@f/20 + ASI 462MC + EQ6-R Pro. Des passages nuageux permanents qui affaiblissaient la luminosité de la planète. Par contre un peu moins de turbulence que d'habitude. Quelques bonnes images (32, 34, 35, 39, 40, 41, 45, 46 et 47) : J'attends toujours d'avoir de bonnes conditions (moins de turbu et pas de nuages) ... ce sera peut-être pour la prochaine saison avec des planètes un peu plus hautes dans le ciel. Qui veut traiter cette image (n°40) de 23h23 TL pour comparer les traitements ? -

Une petite animation du 24 septembre entre 21h et 2h TL

ms55 a répondu à un sujet de ms55 dans Astrophotographie

En fait le ciel était dégagé en apparence sur Jupiter parce que la Lune apparaissait parfois légèrement voilée. Il y a pas mal de voiles nuageux ces derniers temps dans l'Est. 🤔 -

Une petite animation du 24 septembre entre 21h et 2h TL

un sujet a posté ms55 dans Astrophotographie

Le ciel était dégagé mais la turbu bien présente comme indiqué par Meteoblue, j'ai laissé tourner durant 5h : C11@f/20 + ASI 462MC + EQ6-R Pro : Une des meilleures images de la vidéo : -

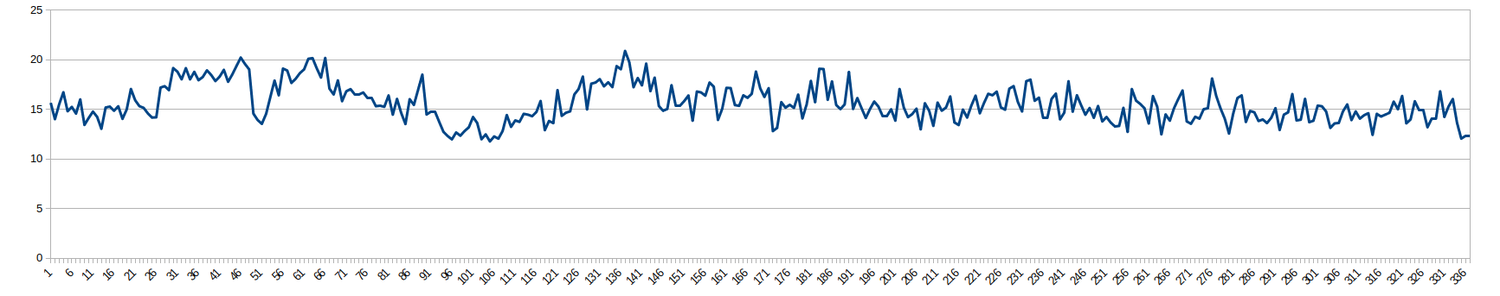

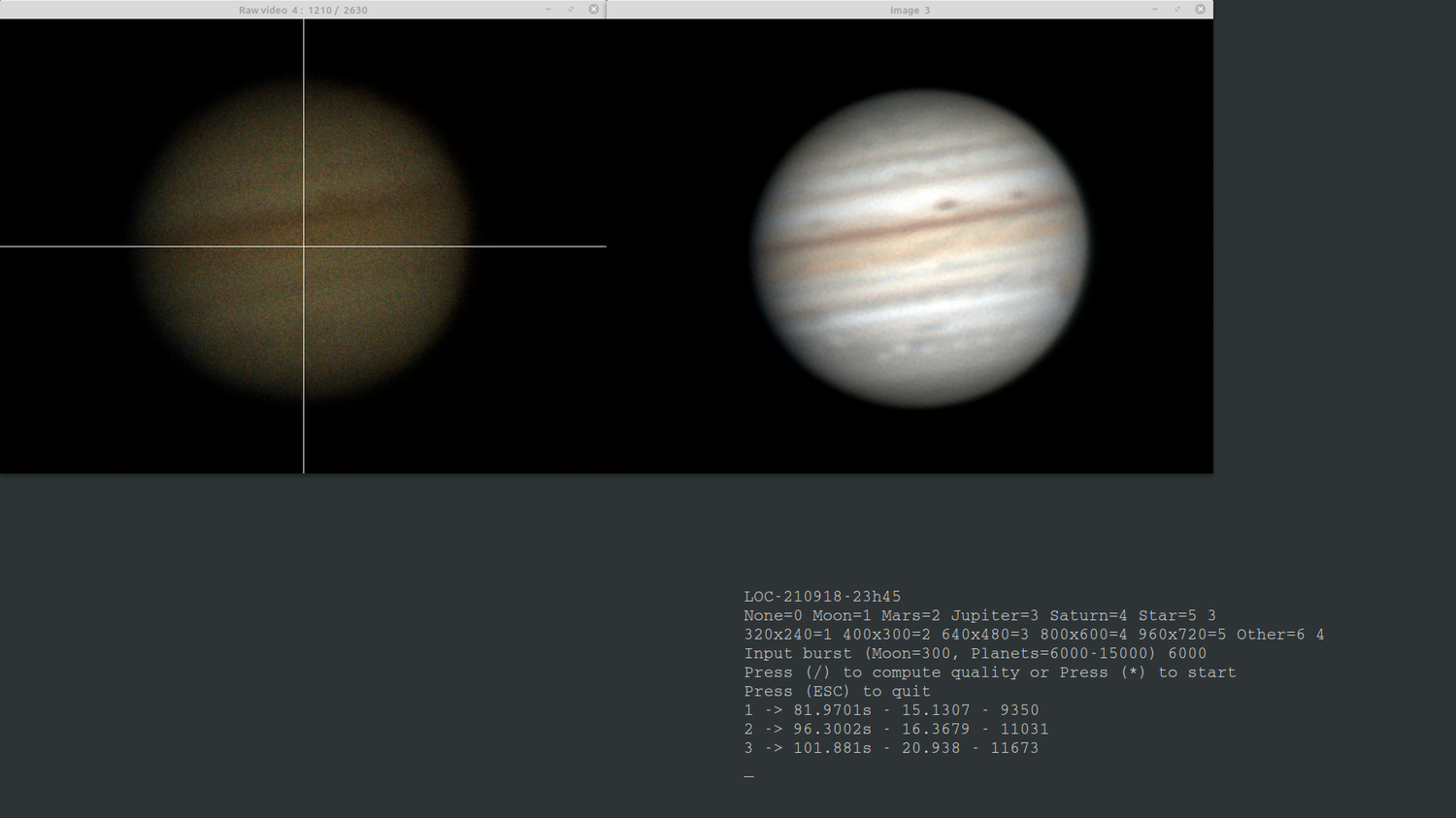

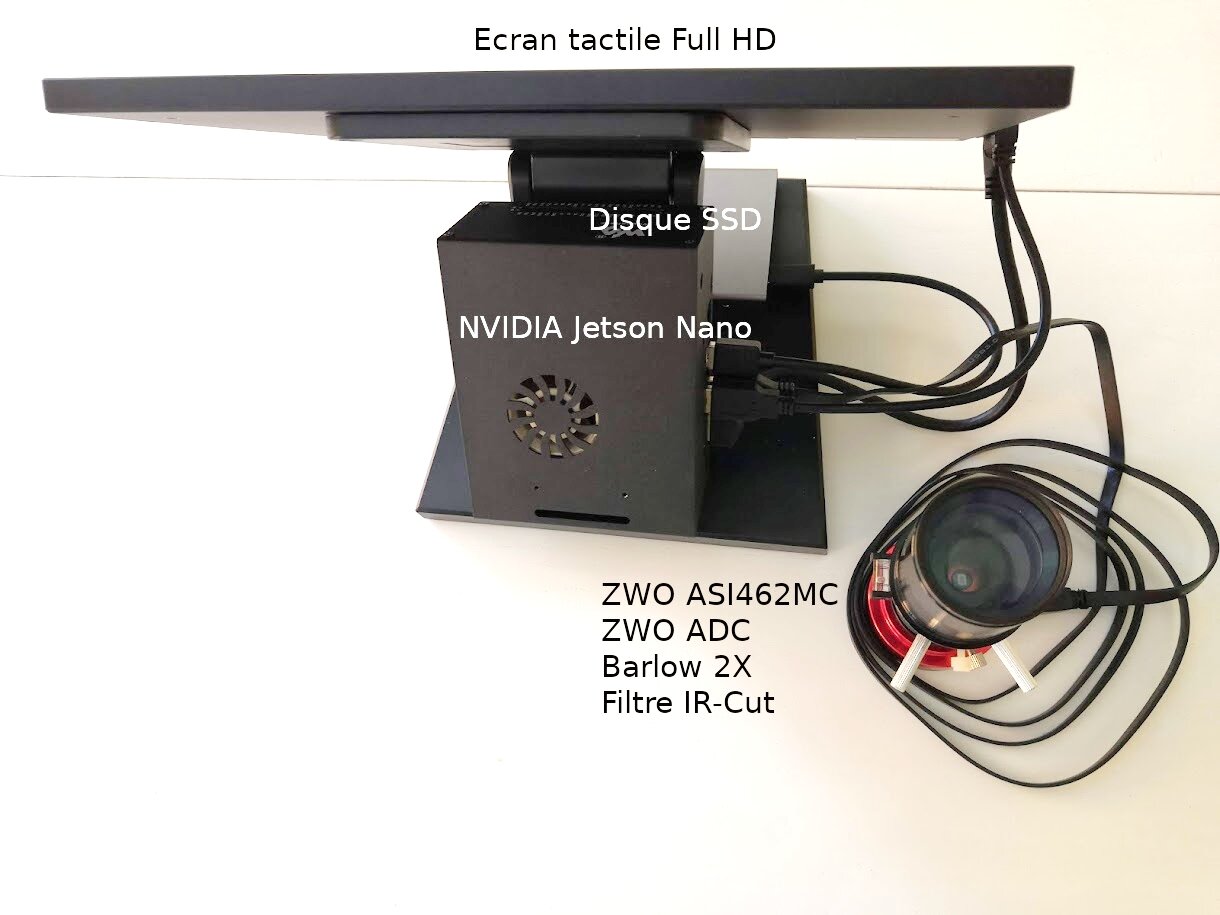

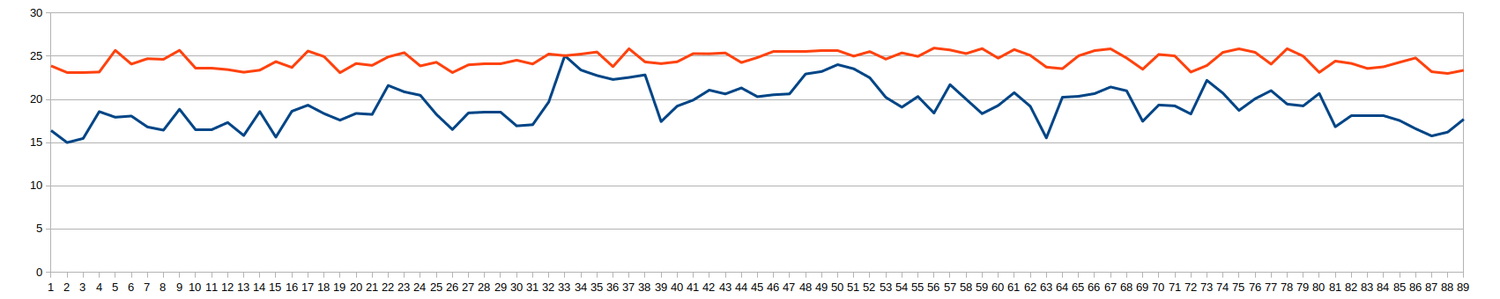

Un petit test de 5h avec des conditions médiocres (une moyenne de 15 correspond à une soirée médiocre, une soirée normale c'est supérieur à 20) mais assez homogènes : Le choix de l'affichage (1 à 9) est laissé à l'opérateur : Le traitement retenu pour l'ensemble des images : Des images brutes 960x720 acquises à 120fps.

-

Nouvelle expérience : Saturne et ses satellites.

ms55 a répondu à un sujet de Great gig in the sky dans Astrophotographie

J'aime bien cette technique qui consiste à garder la même image. Avec une ZWO ASI, il est facile de faire varier l'exposition à gain constant. Comme les détails bougent peu sur cette planète, il est possible de faire 2 minutes pour le globe (exposition1) et 1 minute pour les satellites (exposition2) puis fusionner les 2. Cela devrait permettre de voir le déplacement des satellites sur une vidéo. Je fais cette manip avec Jupiter quand un voile nuageux passe devant la planète. Autre possibilité que l'on peut tester sous Gimp, faire une différence gaussienne pour faire ressortir les satellites. -

C'est déjà du domaine de GPU d'entrée de gamme (en gros la puissance de calcul d'une carte GTX 1050 Ti) avec des algorithmes qui ne font pas appel à l'IA. Deux secteurs boostent le marché : les ordinateurs de jeux pour le matériel et ton smartphone pour le traitement du bruit d'images réelles. Il y a un exemple sur la toile où l'équipe de recherche a modélisé les différents bruits que l'on essaye de gommer en astro, c'est appliqué à des capteurs de smartphones. L'IA peut apporter un plus dans le traitement de rafales d'images brutes bruitées, floutées et déformées, autrement dit à la source de l'acquisition (à voir prochainement).

-

Bonjour A tous je me lance en va et souhaites avoir qlq conseils et avis éclairés

ms55 a répondu à un sujet de micmac74 dans Observation en Visuel Assisté

A partir d'une image brute ou d'un nombre limité d'images brutes, il devient aujourd'hui possible de modéliser les différentes sortes de bruits qui entachent l'image réelle, c'est un progrès majeur pour l'imagerie par GPU du ciel profond. Il y aura toujours des gens pour couper les cheveux en quatre, c'est dans la nature humaine, c'est une question de culture, il faut apprendre à faire avec. 😉 -

Visuel Assisté ça fait prothèse oculaire mais c'est une expression qui parle à chaque astram, l'expression vision en quasi temps-réel ou vision par GPU, me semble plus adaptée aux moyens matériel et logiciel d'aujourd'hui. Le fossés entre l'astrophoto et la vision par GPU se réduit au point qu'il fera complètement disparaître dans quelques années les post-traitements liés à l'astrophoto. Pour encore beaucoup d'astrams c'est une activité à part entière de remplir de gros disques SSD d'images brutes pour en jeter une grande partie à la poubelle, cette démarche consomme de l'énergie à la fois lors de l'acquisition et lors des traitements ultérieurs, c'est pas très cool pour la planète. 😉

-

Avec un voile nuageux permanent que je distinguais grâce à la lune qui l'éclairait par l'arrière. L'avantage de ce système c'est d'être rapidement fixé sur la qualité du ciel et surtout de ne pas avoir à traiter des tonnes d'images puisque 100% du traitement est fait lors de l'acquisition. Le but de ces quelques soirées est de préparer la prochaine saison avec des planètes en position plus favorable. Dans l'attente, reste à terminer le même travail sur le ciel profond.

-

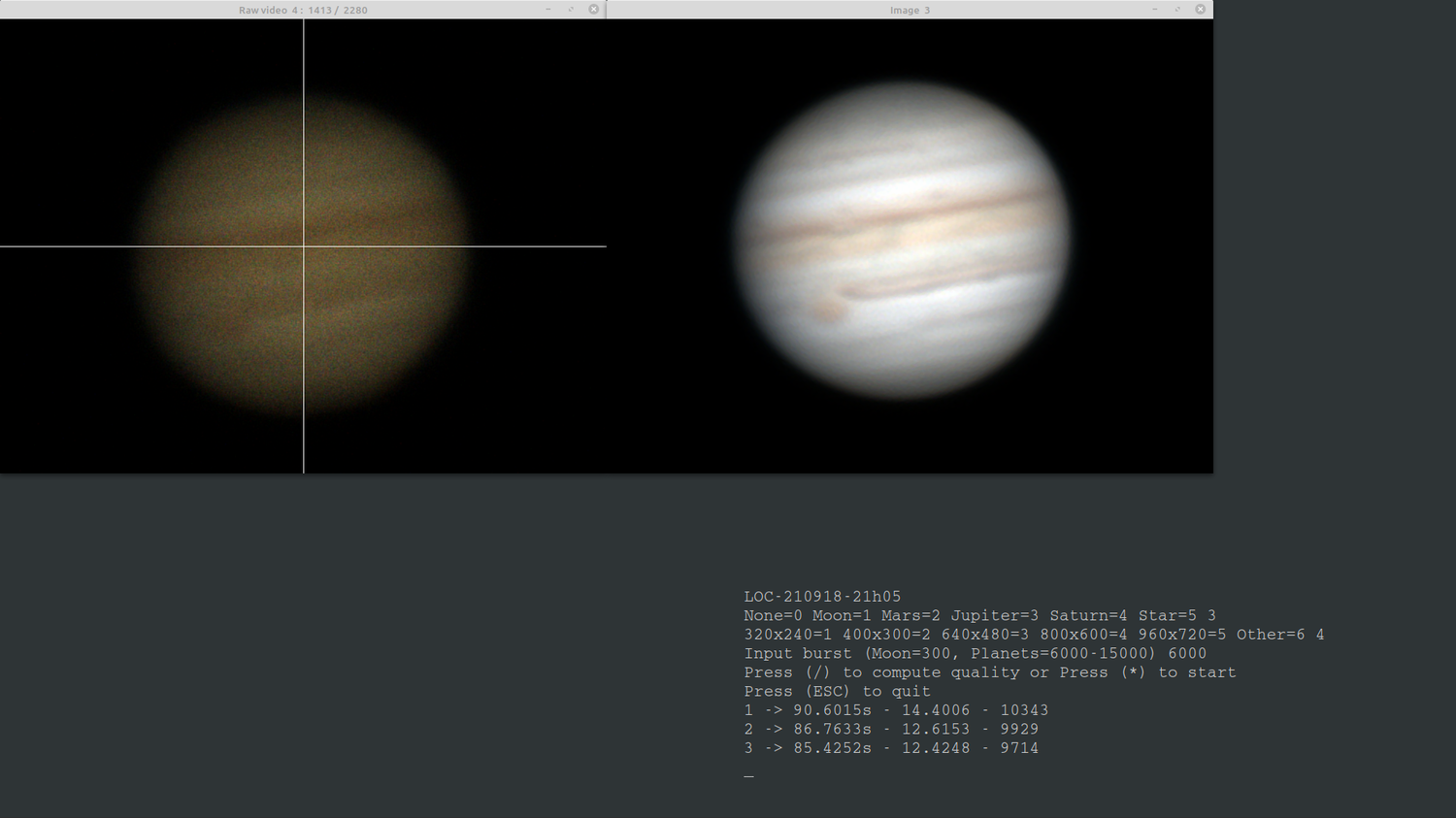

Deuxième série à 23h45 : Là c'était carrément sous un voile nuageux permanent mais à l'écran on continuait à distinguer les principaux détails comme sur l'image n°3 suivante alors qu'à l'oculaire c'était complètement bouché.

-

A la 36ième minute les nuages sont arrivés d'où la vidéo un peu réduite : 😉 Pas terrible la météo en ce moment en Alsace mais ça fait un entraînement pour la prochaine saison. 😀

-

-

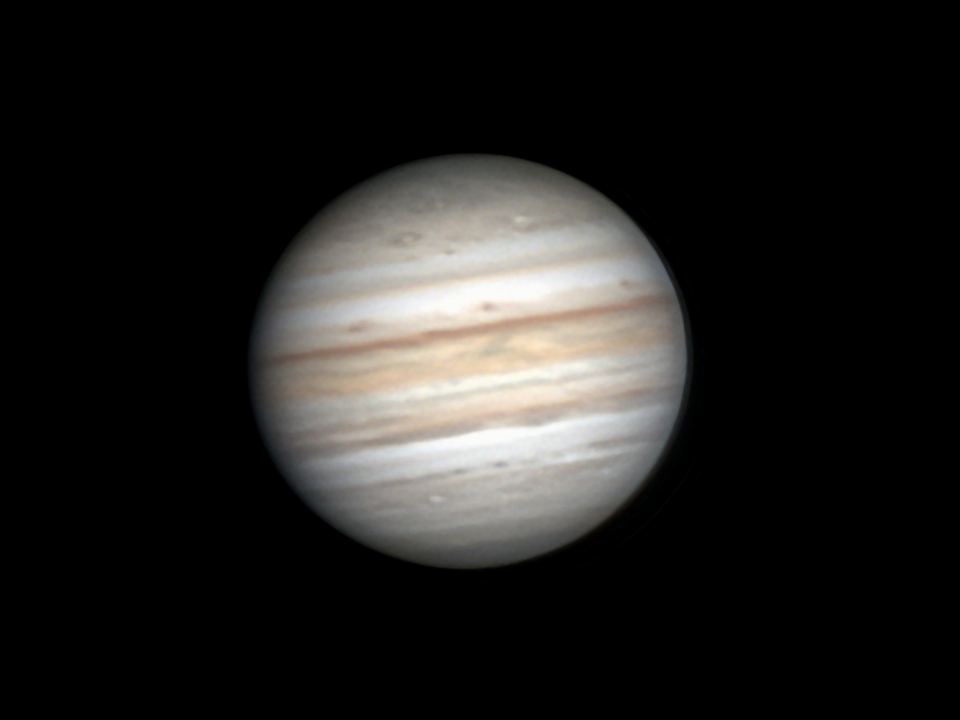

Vidéo assistée et astrophoto le 17 septembre entre 10h et 1h TL

ms55 a répondu à un sujet de ms55 dans Observation en Visuel Assisté

L'intérêt c'est de pouvoir traiter avec une même config, la lune, les planètes et les objets brillants du ciel profond (nébuleuses planétaires et amas globulaires). Puis en changeant la config, d'autres objets du ciel profond (nébuleuses gazeuses, galaxies, comètes). A l'oculaire c'est impossible d'observer les couleurs du ciel profond ou de voir quelques détails sur Jupiter dans des conditions médiocres comme hier soir sur l'image n°143 par exemple (à l'oculaire, je distinguais même pas la GTR) : Quand les conditions sont moyennes comme dans la vidéo suivante, les images sont stackées toutes les minutes pour Jupiter : -

Vidéo assistée et astrophoto le 17 septembre entre 10h et 1h TL

un sujet a posté ms55 dans Observation en Visuel Assisté

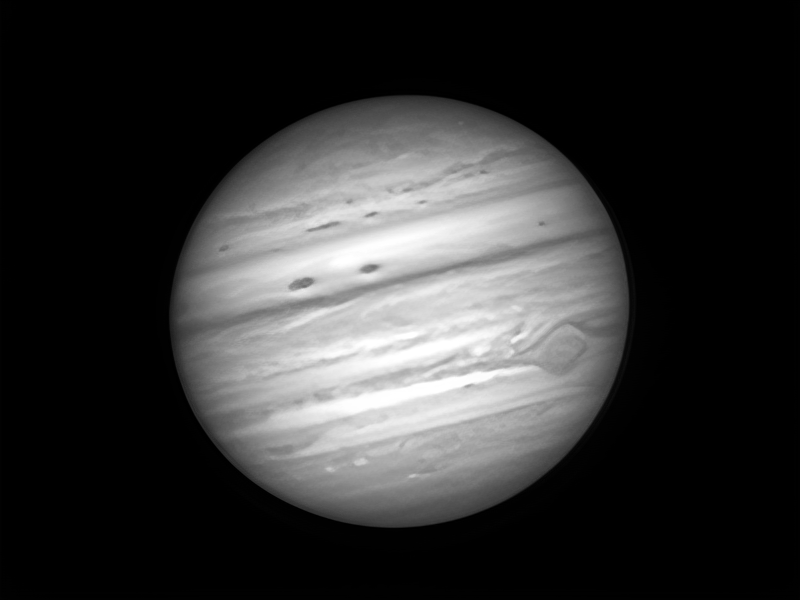

Le 17 septembre, j'ai pu faire une vidéo de 21h49 à 1h04 TL (3h15) entre 2 passages nuageux. A l'écran, une image 960x720 s'affiche à droite toutes les 7s, elle correspond au cumul de 600 trames brutes : Le lien avec l'astrophoto c'est que toutes les minutes, je peux obtenir une image dérotée comme l'image n°114 suivante correspondant aux images n°1131 à n°1180 de la vidéo assistée obtenues elles toutes les 7s : Bon, la qualité du ciel était médiocre mais c'est pour expliquer le lien entre la vidéo assistée et l'astrophoto. Toutes les minutes, je peux aussi obtenir à l'écran la dernière image HR dérotée sur 5 minutes en appuyant sur la touche 'D' sinon toutes les 7s, j'obtiens une image de la vidéo assistée. Ce processus a permis de générer 1500 images de vidéo assistée et 146 images HR obtenues par dérotation sur 5 minutes (fenêtre glissante de 50 images toutes les 1 minute) : [1..50] -> n°1 [11,60] -> n°2 ... [1131,1180] -> n°114 ... [1451,1500] -> n°146 -

Jupiter le 16 septembre entre 22h02 et 22h10 TL

ms55 a répondu à un sujet de ms55 dans Astrophotographie

Merci, c'est réparé, j'avais une nuit d'avance. 😉 Le 17 septembre, j'ai pu faire une vidéo de 21h49 à 1h04 TL (3h15) entre 2 passages nuageux. A l'écran, une image 960x720 s'affiche à droite toutes les 7s, elle correspond au cumul de 600 trames brutes : Et l'image n°114 dérotée à partir des images 1131 à 1180 (obtenue sur l'écran précédent en appuyant sur la touche 'D'), je mixe ainsi la vidéo assistée avec une image toutes les 6s et l'astrophoto avec une image HR toutes les minutes : Bon, les conditions étaient médiocres hier soir mais le ciel est resté à peu près dégagé 3 heures entre deux passages nuageux. Quand les conditions sont meilleures, je fais une acquision de 6000 images brutes en 1 minute environ sinon c'est une acquisition de 600 images brutes en 6s environ puis dérotation sur 5 minutes. Reste à tester la dérotation de 5 images obtenues à partir de 6000 images brutes. -

Jupiter le 16 septembre entre 22h02 et 22h10 TL

ms55 a répondu à un sujet de ms55 dans Astrophotographie

-

Un petit test de 8 minutes entre les nuages avec turbu bien présente. C11@f/20 + ASI462MC + EQ6-R Une acquisition toute les 6s (600 images brutes) + dé-rotation sur 5 minutes (50 images). Images 1 à 50 : Images 51 à 60 : Images 61 à 70 : Images 71 à 80 : Il y a eu juste une percée de 10 minutes à partir de 10h00 TU, j'espère que demain les conditions seront meilleures. 😉 Cette dernière technique de visuel assisté semble donner des images plus homogènes, à confirmer par une vidéo de quelques heures dans les prochains jours si le temps le permet. Pas de trace de l'impact :

-

Au départ, il y a une image brute qui va servir à sélectionner et aligner 6000 images brutes (dans le cas présent cette image montre que les conditions n'étaient pas terribles) : Après avoir aligné les 6000 bonnes images brutes (critère de qualité p/r à l'image initiale) en utilisant le "lucky imaging" pour 'image 65 : On applique le traitement du post précédent pour obtenir l'image RGB n°65 : Utilisation de l'algorithme BSRGAN ou Real-ESRGAN pour générer la couche de luminance à partir de l'image RGB précédente : L'image LRGB ressemble à cela : Pour plus de détails sur les algorithmes BSRGAN et Real-ESRGAN : https://arxiv.org/pdf/2103.14006.pdf https://arxiv.org/pdf/2107.10833.pdf Personnellement l'image RGB de la vidéo assistée me convient. Reste à embarquer tout cela sur une carte Jetson Nano à laquelle est attachée un disque SSD et un écran tactile (pas de clavier et pas de souris) :

-

En réduisant d'avantage l'écart c'est un poil plus contrasté : Le fichier ZIP correspondant à la vidéo ci-dessus : res2.zip Et pour finir ne petite touche de deep learning :

-

Théoriquement, il doit être possible d'obtenir une qualité constante égale à 25 comme le montre l'exemple suivant qui s'en rapproche : Le fichier ZIP correspondant : res2.zip

-

Il faut limiter dans la mesure du possible l'écart de qualité entre 2 images consécutives sans toutefois exagérer le traitement appliqué. Dans l'animation suivante : - la première courbe correspond à un même traitement appliqué à toutes les images, - la deuxième courbe correspond à un traitement adaptée à chaque image. Le système est encore perfectible mais si l'écart entre 2 images consécutives ne dépasse pas 8 (comme dans l'exemple ci-dessus) alors l’œil lisse les petites différences. 😉

-