-

Compteur de contenus

17 -

Inscription

-

Dernière visite

Type de contenu

Profils

Forums

Téléchargements

Blogs

Boutique

Calendrier

Noctua

Messages posté(e)s par Psynergie

-

-

Il y a 15 heures, Malik a dit :

pas la peine de te justifier

t’achète tes trucs ou tu veux ☺️

et d’autant plus en suisse... vu que t’es suisseassez agaçant, au passage, la morale du bon et du mauvais acheteur...

En fait, j'adhère à l'idée d'acheter local... Les circuits courts. D'où probablement ma remarque sur le fait que je n'ai pas cherché plus loin, qui reflète un peu de culpabilité à me jeter dans les bras des GAFAM... Mais vu que de toute façon, je ne peux plus écrire un mail sans passer par eux (professionnellement, les entreprises sont tout de même beaucoup sur Windows... En tout cas mon employeur, c'est tout sur MS et AZURE), c'est correct. En plus, les serveurs AZURE semblent être en Hollande... Le Google natif me parle en néerlandais... Et maintenant que tous les GAFAM's du monde vont payer 15% de taxes ça fait un dilemme éthique de moins à gérer.

Par contre, le tarif de OVH pourrait être pas mal plus intéressant. Donc, à explorer tout de même... J'attends leur retour pour faire des tests.

Mais au final, c'est bien souvent le tarif qui fait la différence. J'ai pas acheté des caméras suisses... Elles sont chinoises. Et je ne suis pas sûr que quelqu'un d'autre à ce jour sache produire des circuits de ce niveau en Europe. Donc, on est pris avec la mondialisation. Sans faire de la morale, je trouve néanmoins assez sain que nous nous posions la question. Je crois que c'est sur AstroBin que j'ai lu un sujet autour de l'éthique consistant à mettre en ligne des images traitées en IA. Je ne sais pas ce qui est juste ou faux, mais vu le bordel ambiant, j'aime mieux que l'on se pose trop de questions que pas assez. Merci de vos commentaires et bon dimanche. Je vais faire mes tests WBPP sur le serveur...

-

il y a 47 minutes, Alhajoth a dit :

Manifestement, tu n'as pas connaissance d'OVH Cloud, pourtant français.

Bon. Le tarif horaire à l'air vraiment modeste. Mais a part un 2-cores et 16GB de RAM, pour l'instant, pas de quota suffisants. J'ai demandé. On va voir la suite.

-

il y a 8 minutes, Alhajoth a dit :

Manifestement, tu n'as pas connaissance d'OVH Cloud, pourtant français.

En effet... J'avoue n'avoir cherché que des providers en Suisse. Mais il y a une semaine, je ne savais même pas que ça existe... Donc, je progresse ;-).

Je vais aller voir OVH par curiosité. Merci de l'info. Cordialement. Christian

-

Voici le bilan de mon test sur Virtual Machine.

210703 - Evaluation finale - Virtual Machines WorkStations.pdf

-

Le 01/07/2021 à 17:53, olivdeso a dit :

ça se loue ? ça pourrait peut être...

Oui. Le bureau à distance windows dégrade nettement moins à condition d'utiliser exactement les mêmes paramètres de résolution d'écran, couleur, etc.

Mais je pense que la solution est de faire le prétraitement sur la machine distante et de rapatrier l'image sur le PC local pour le traitement

c'est normal que ça rame : outre les 16Go de ram qui sont une limitation, le processeur 7600U est une version low power avec seulement 2 cores physiques. Tu prends n'importe quel Ryzen à 8 coeurs, ça ira 4 fois plus vite au moins. Tu passe à 32Go de ram, là c'est plutôt un facteur x10 à mon avis si tu as 20Mpixels environ

Oui, c'est mon hypothèse. Mais je vais d'abord tester la version en cloud. J'ai pris du temps aujourd'hui. J'ai été capable de créer une machin virtuelle 8 coeurs 64GB sur Azure de Microsoft. Ca divise le temps par 2-3x... J'attends de pouvoir augmenter les quotas pour tester une machine 64 proc 512GB RAM + SSD rapide pour les Swap. Si ça fonctionne, ce serait une excellente pratique au moins pour le pré-tt... Ensuite, pour le post, on verra si c'est pertinent.

Il y a 15 heures, Malik a dit :c'etait en quelle année ?

En tout cas aujourd'hui SGP marche vraiment tres bien, et pour un prix vraiment raisonnable comparé a ce qui peut etre proposé par ailleurs

Décembre 2020... J'ai juste conservé deux ou trois notes, mais par ex. "Format des noms pas enregistrés dans Sequence Generator Options. %t\%dt\%t_%ft_%cg_%co_%fe_%03_%dt_%tm"... Et surtout, des caméras pas reconnues...

-

Le 30/06/2021 à 16:56, CCD1024 a dit :

Il y a quand-même l'embarras du choix sur les logiciels d'acquisition :

APT, SGP, N.I.N.A., PRISM, MaximDL, TheSkyX, Firecapture, Sharpcap, SPIPS, Nebulosity, Voyager....

Oui c'est sur, mais n'arrive pas encore à la cheville de AstroPixel Processor sur ce type de possibilités.

Oui, je pensais ça aussi. Et peut-être que mon choix de caméras chinoises QHY en est la cause. Mais j'avais plusieurs problèmes avec le Stellarmate. Je trouvais que Jasem ne mettait pas beaucoup d'enthousiasme à répondre. J'avais tort. Le SM marche super-bien comparativement aux autres solutions sur PC. J'ai essayé différentes applis. Toujours des problèmes de drivers ASCOM pas compatibles (genre il ne voit pas la roue à filtres ou il perd la config ou etc...), ou des séquences beaucoup moins évoluées que sur SM (sur SM, tu programmes ta séquence et tous les fichiers sont automatiquement renommés et stockés au bon endroit), etc. Le plus abouti en terme de fonctionnement me semblait SGP, mais avec plein de problèmes de jeunesse... Finalement, je suis revenu - penaud - au SM. Mais j'ai encore des problèmes avec certains drivers INDI.

-

il y a 22 minutes, CCD1024 a dit :

Oui mais on s'aperçoit dans les benchtest que le Ryzen TR ne tire pas partie de toute sa puissance et du nombre de coeurs. Un Core i9 extreme va être plus rapide par coeur (mais si le ryzen en a 2x plus, il ne sera pas 2x plus rapide)

Je regarde un peu les post de ceux qui ont "convertis" Starnet++ en version GPU. Il y en a pas mal qui se plaignent "ouiiiiiinnnnn c'est pas compatible avec ma carte"

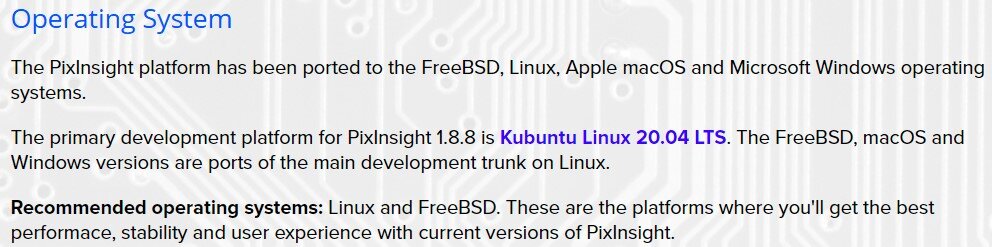

Pix s'est étoffé au fil des années (je l'utilise depuis la version 1.0 LE), lentement mais surement. Juan a pas mal discuté sur le CPU et c'est en cours. C'est déjà d'ailleurs intégré à strict minima dans la 1.8.8.8 mais ce sera surement la 1.9 qui commencera vraiment à l'exploiter :

PixInsight, as a software development project, is much more than a program to process astrophotos. PixInsight is a comprehensive and powerful software development platform specialized in astronomy and astrophotography. This includes instrumentation control (such as our Indigo integration project), astrometry, photometry, solar system ephemerides, image preprocessing and post-processing, and general image processing and analysis tools for a variety of technical applications, including applications beyond astronomy. Our interfaces are powerful, efficient and perfectly suited for all of these tasks and much more. In general we try to not write "toys", but serious and efficient implementations pursuing excellence.

We are always working actively on many projects that are not visible on the surface, but will yield their fruits during the coming months and years. A good example is GPU acceleration, which is being developed actively right now. Another example is a new astrometry-based mosaic generation tool, which will benefit from the excellent astrometry engine that we are building and is starting to be well visible in the new 1.8.8-8 version. I understand that sometimes our development decisions and new releases can be difficult to understand in the context of a typical image processing application, but PixInsight is not typical in any way and is much more than what most users see of it.APP commence sa conversion vers le GPU.

Native support for M1 Apple will come as soon as Java Oracle/OpenJDK/Graal is natively built on the M1 arm hardware. Sadly this is not the case yet, but indications are it will come soon.

Yes indeed, we plan to move to Vulcan and Metal for GPU accelerations cross-platform indepent of GPU hardware.

Startools a completement intégré le GPU et va continuer de plus fort dans sa version 1.8

Bien sur, je te comprends : on veut tout, et tout de suite. Donc oui, le GPU, c'est une urgence. (Bon de toute façon il y a pénurie de cartes graphiques haut de gamme style 3060 ou 3080 qui sont détournées pour faire de la recherche de bitcoin perdu))

Donc on critique que ça vienne pas assez vite 😀 c'est légitime. On gueule après la grosse feignasse de programmeur qui n'en branle pas une 😂

Et dire que j'en connais un qui veut même pas mettre le bayer-drizzle dans son soft !!! 'tain !!! 😘

oui, j'imagine que la programmation GPU n'est pas simple.

De plus, il me semble obligatoire qu'il soit compatible NVIDIA et AMD pour contenter tout le monde. Encore plus compliqué.

J'arrive en Astrophoto, mais je trouve que dans le pré-tt et post-tt, on est plutôt bien servi. Pour l'instrumentation, là, je trouve que c'est un peu galère... Difficile de trouver des applis qui fonctionnent de manière continue. Mais pour le traitement, les softs existent, sont assez peu coûteux (comparativement à des logiciels grand-public qui coutent des fortunes) et globalement, livrent la marchandise. Un script comme WBPP 2.0 sur PI, c'est génial. Tu peux séparer tes sessions, intégrer le tout en deux coups de cuuillères à pot, etc. Mais je t'accorde que ça demande de la puissance machine... D'où mon post...

-

Il y a 1 heure, fdudu a dit :

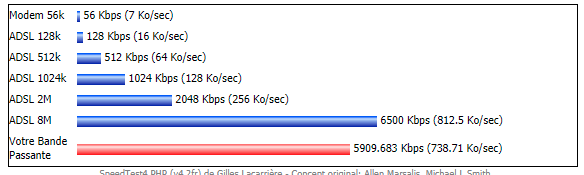

Oui, j'ai de la chance... On est bien connecté... Il est un peu court aujourd'hui...

-

il y a 16 minutes, Malik a dit :

Compris, du coup tu auras forcement la compression de l'image affichée via VNC

J'ai deja essayé entre deux machines connectées en resaux local... autant sur les images mono ca paaaassse encore, autant sur les image couleurs c'est beaucoup trop dégradé

Oui, c'est ça... Je ne mesure pas à quel point ça se dégrade... C'est aussi ce genre de trucs que j'aimerais tester... Pour l'instant, je ne travaille qu'en mono avec la 294M.

il y a 3 minutes, fdudu a dit :+1

En tout cas, à l'époque, je travaillais sur des terminaux Tektronix 4010 avec des Mainframes distants pour le développement de puces CMOS... Et la qualité de images étaient extraordinaires. Je ne peux pas croire qu'aujourd'hui, avec la bande passante que nous avons, nous ne sommes pas capables d'avoir un affichage déporté de bonne qualité. Pour ce qui est des traitements d'image, je ne mesure pas bien. Mais il est clair que les traitements avancés peuvent être massivement parallélisés sur des processeurs dédiés... Quand je vois ce que fais une déconvolution, un traitement sériel semble peu pertinent. Mais j'imagine que ce n'est déjà pas le cas.

-

Bonjour Malik,

Pour le comment ça se passe, c'est ce que je veux essayer. Actuellement, je gère mon Stellarmate depuis un vieux notebook Dell et VNC en Wifi. Ca marche parfaitement. Aussi pour l'affichage des images en temps réel. Donc, mon hypothèse est que ça se fait via une console genre VNC qui sert de terminal. Par contre, il faudra toujours télécharger les bruts sur la VM. Mais ça, je peux lancer un batch et revenir quand c'est prêt. J'ai une bonne connexion filaire.

Pour la taille, je suis passé d'un NIKON D610 de 24Mb à une QHY294M de 11Mb. Donc, c'est pas extraordinaire. Mais le pré-TT, p.ex. via WBPP, avec 5-6 sessions, des flats, des bruts (100-400 images), des darks, alouette... ça prend facilement 30-45 minutes. Donc, je ne peux pas tester un autre paramètre "pour voir ce que ça fait". Sinon, la plupart des traitements prennent entre 10 et 30 sec. minimum. Si avec une VM, tu lances, tu regardes, undo, tu changes, tu relances, undo, etc. en temps réel, c'est pas mal plus chouette. Je vise un budget d'environ 100 euros par mois.. Et si un jour j'ai un guidage assez précis pour utiliser un plus grand capteur, je ne serai pas dépendant d'un nouvel upgrade matériel. En tout cas, c'est là que j'en suis dans ma réflexion.

-

Wow! Que d'arguments... J'ai commencé à développer en 1978 et durant plus de 15 ans... Mais depuis 25 ans , je code pour le plaisir, mais ce n'est plus mon métier. Perso, je trouve tous ces programmes super-costauds. Leur utilisation me parait déjà un beau challenge... Je ne parle pas du développement. Anyway, grâce à tous vos apports, j'ai plusieurs plateformes identifiées pour des Virtual Machines (VM). Je vais faire quelques essais. Dans tous les cas, les caractéristiques matérielles proposées me semblent financièrement inaccessibles à l'achat. Par contre, je ne mesure pas encore comment ça marche "en vrai" avec PixInsight. Donc, je vais faire des tests et je vous partagerai mes conclusions. Cet échange m'oblige à clarifier mes besoins. Et mon principal besoin, c'est que tous les paramètres de PixInsight sont intriguant et demandent investigations... Mais si il faut 3 minutes de calcul entre chaque essai, j'avoue que je trouve ça "fatiguant". Donc, si l'utilisation d'une VM permet de faire plein d'essais en quelques secondes à chaque fois, j'aurai enfin l'opportunité de voir à quoi servent ces nombreux paramètres. C'est pas mal ça. Merci encore de vos apports. Et je ne sais pas pour vous, mais nous, en Suisse, on a pleins d'orages et pas un jour de ciel clair depuis plus d'un mois... Grrrr! Clear Sky 😉 (tu parles!)

-

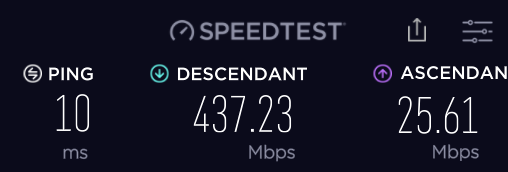

il y a 21 minutes, sixela a dit :

Oui. Merci. Je découvre grâce à vos réponses sur plusieurs sites que ces services existent chez Google, Amazon, Microsoft, etc. en facturation à l'heure... Je vais faire des tests... Car chez Google, ils parlent de 1$/h pour 16 processeurs et 64 GB... A ce prix, ça rentabilise clairement le travail. Une fois les bruts transmis (j'ai un 750Mb de vitesse de transfert), je pourrais alors jouer un peu plus... A voir. Je vous reviendrai avec mon expérience. Merci pour le lien.

il y a 6 minutes, krotdebouk a dit :Merci Krotdebouk. Est-ce à dire que les performances sont très différentes en natif Linux? Sur le Benchmark, ça ne me semblait pas évident... As-tu fait l'expérience? Si oui, ça disait quoi? C'est clair que Windows n'est pas frugal... Merci de ta proposition.

-

Il y a 4 heures, Franklin.jr a dit :

Salut,

un i7 sur portable c'est moins puissant qu'un i7 dans une tour. (nombre de coeurs physiques souvent divisé par deux, peut être aussi le cache moins élevé).

perso j'ai un Ryzen 4350 avec 16Gb de RAM et c'est loin de ramer.

pas sûr que louer du temps sur des serveurs de calcul soit plus "rentable" que de se monter un PC suffisant pour le traitement astrophoto, surtout pour comme tu le dis, un hobby.

Merci Franklin.jr de ton commentaire. En effet, c'est assez différent. En fait, dans le benchmark PixInsight https://pixinsight.com/benchmark/, le Intel(R) Core(TM) i7-7600U CPU @ 2.80GHz (2) [3115] 3 lignes avant la fin du 1.8.8.-8, c'est moi. Donc, je peux améliorer le truc avec un bonne WS (genre 11th Gen Intel(R) Core(TM) i7-11700K @ 3.60GHz (1) [15347]) on va 5x plus vite. C'est déjà très bien. Mais pour une bombe, genre AMD Ryzen Threadripper 3990X 64-Core Processor (11) [56905], on parle d'une WS à 8-10KEuros. En louant du temps CPU pour 100 euros par mois (pour les week-ends), ça représente environ 8 ans... La machine est obsolète. D'où ma question... Car dans PI, un traitement de 10 sec, ça change la vie avec 2'30''... ça donne envie d'essayer des trucs...

Il y a 3 heures, Titophe a dit :Avec SiriL, sur un vieux mac de 2012 boosté avec un SSD et 16Go de RAM, le temps de pré traitement reste très acceptable et j’ai cru comprendre que sur cette phase là Pix était nettement plus lent que SiriL. Mais c’est surtout les nombreux accès disque en lecture / écriture qui pèsent lourd sur le chrono.

Après pour le post-traitement final, j’utilise Lightroom et Photoshop et une fois de plus mon Mac n’est pas trop essoufflé, mais cela ne fait pas les mêmes traitements que Pix…

Ensuite louer du CPU de compétition nécessite aussi une solide connection internet ne serait que pour uploader les images brutes… cette opération risque même d’être plus longue que le pré-traitement / empilage de tes images en local.

Petite question, quelles sont les opérations que tu trouves trop lentes sur ton PC ?

est-ce que ces opérations profitent pleinement du calcul parallèle sur une puce multicoeur ou est ce que ce sont des opérations qui n’ont recours qu’à un seul cœur mais qui demandent beaucoup de puissance ? La machine optimum pour l’une ou l’autre des opérations n’est pas forcément la même.

Pour commencer, le Pré-tt avec WBPP2.1.1 peut prendre jusqu'à 30'-60'… Donc, difficile de jouer avec les paramètres… Tu le fais une fois et c'est tout… Et certaines commandes (p.ex. HDRMT ou Deconvolution ou Morpho Transform) demandent jusqu'à 1 minute… Donc, tu essaies, tu reviens, tu modifies un paramètre, tu ré-essaies… etc.. Difficile de faire ça avec beaucoup d'essais… Mais peut-être que je rêve… Je vais voir si je trouve quelque chose de pas trop coûteux. J'aimerais vraiment voir ce que ça donne. Pour les autres softs, bien sûr, il y a d'autres options. Mais la courbe d'apprentissage sur PI demande des dizaines d'heures d'expérience... Je ne crois pas que je vais refaire ça avec d'autres plateformes... Merci de tes commentaires.

-

Bonjour à toutes et tous,

J'ai passé plusieurs mois à renouveler mon setup. Aujourd'hui, ça fonctionne bien. Il me reste néanmoins à optimiser mes temps de calcul. J'utilise PixInsight sur mon NoteBook. Mais c'est lent… Même avec un i7, 16GB de RAM et 1TB de SSD. Acheter une workstation vraiment musclée me semble peu pertinent. C'est très coûteux et vite obsolète pour un usage de hobby. J'aimerais mieux louer du temps CPU sur des serveurs externes. Connaissez-vous des fournisseurs qui louent? Certains d'entre vous ont-ils trouvé une parade intéressante? Merci d'avance de vos commentaires.

Clear sky.

Christian

-

Bonjour Krotdebouk (!),

Merci pour cette réponse. Oui, le 200 - 800mm, c'est la focale.

Cordialement

Christian

-

Bonjour à toutes et tous,

Je fais face à un dilemme et je peine à trouver une réponse claire. Peut-être qu'elle n'existe pas. Je fais du ciel profond. Je m'intéresse aux gros objets (nébuleuses, galaxies, etc.). J'utilise du 200mm à 800mm. Jusqu'à présent, je fais du plein format avec un Nikon D610. Le but est de passer en caméra astro monochrome avec un budget de 2000 euros. La question: quels sont les avantages et inconvénients d'une caméra d'occasion plein format (p.ex. QHY 11) vs une caméra récente CMOS en plus petit format?

Merci d'avance de vos commentaires.

Christian

Acheter une puissante workstation ou louer du temps CPU à distance sur d'énormes serveurs?

dans Matériel astrophotographique

Posté

Rebonjour,

Afin de boucler la boucle, voici une synthèse finale de mes essais avec les machines virtuelles (VM) Azure.

Premièrement, je ne suis pas parvenu à configurer seul ma machine. Si l'on ne paie pas 30 euros par mois pour l'abonnement avec soutien technique 24/7, c'est compliqué. Or, je veux limiter mes frais fixes afin de ne payer que quand j'utilise la VM. Mais Microsoft nous propose d'utiliser UpWork pour engager des techniciens pigistes. J'ai donc fait ça et ça a très bien fonctionné.

Deuxièmement, ma configuration actuelle est une VM de 64 cœurs avec 512GB de RAM et 100GB de disque SSD partagé permanent. Depuis mon PC personnel, je transfert tranquillement mes bruts vers le disque partagé avant de faire le traitement sur la VM. Ma première utilisation a été le traitement dans PixInsight (WBPP 2.1) de mes près de 1000 fichiers (Flats, Darks, Lights, etc. récoltés sur 6 sessions distinctes) pour créer l'image qui se trouve ici: https://astrob.in/uzh5nk/F/ . La machine a mis environ 30 minutes pour le traitement complet. Ensuite, j'ai tranquillement récupéré mes Masters depuis mon disque partagé.

La seconde utilisation a été une utilisation intensive de la Déconvolution dans PixInsight. Je ne comprenais pas bien à quoi servent les nombreuses options. Or, en un peu plus de 2 heures, j'ai pu faire plein d'essais en augmentant les itérations au-delà de 100, en modifiant les paramètres divers, etc. J'utilise le screenshot de Windows pour documenter mes essais.

Pour terminer, le coût de location mensuel des 100GB de SDD permanents est de CHF 0.78.- (soit environ 25 euros/mois) + CHF 7.68.- par heure de VM. Vu que je ne l'utilise que pour des jobs très demandant en mémoire et CPU (le reste se fait sur mon portable personnel), ça reste financièrement très raisonnable.

Voilà. Je vais donc renoncer à acheter une grosse machine et faire mes intégrations et autres jobs complexes directement sur la VM de Azure. Merci de votre collaboration à la réflexion.

Bon ciel à toutes et tous.

Christian