ms55

Banni-

Compteur de contenus

310 -

Inscription

-

Dernière visite

-

Jours gagnés

7

Type de contenu

Profils

Forums

Téléchargements

Blogs

Boutique

Calendrier

Noctua

Tout ce qui a été posté par ms55

-

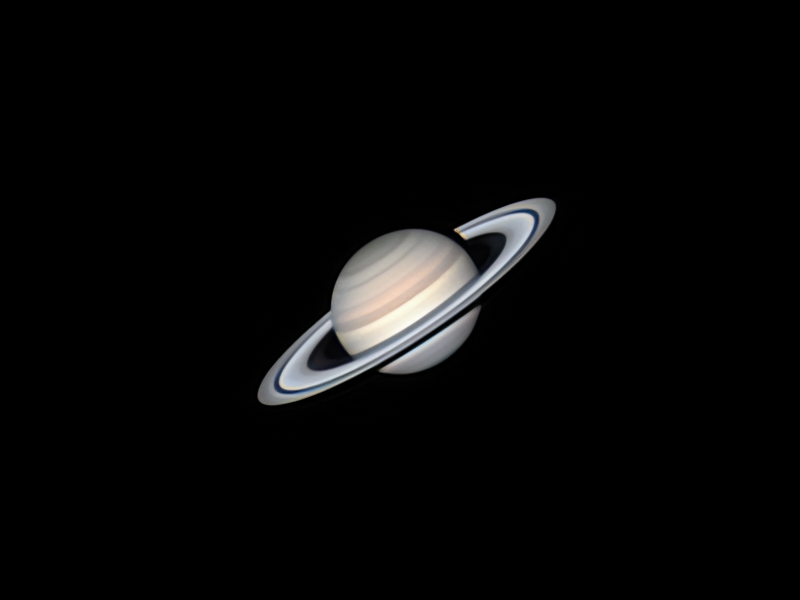

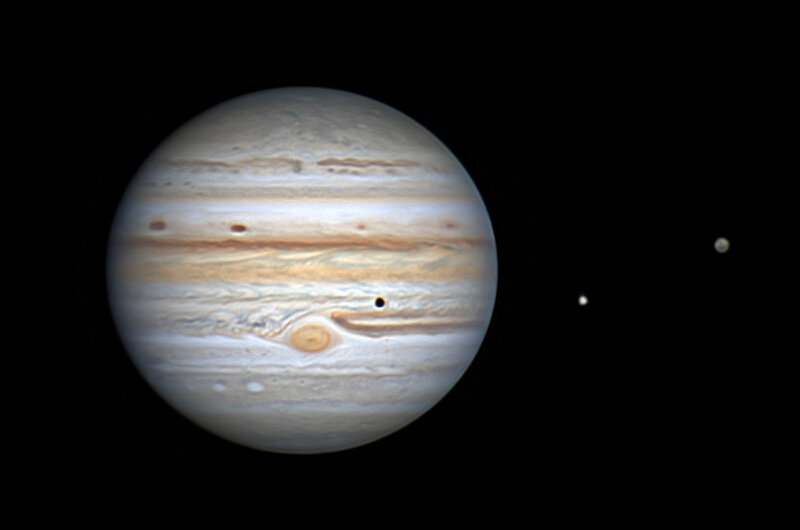

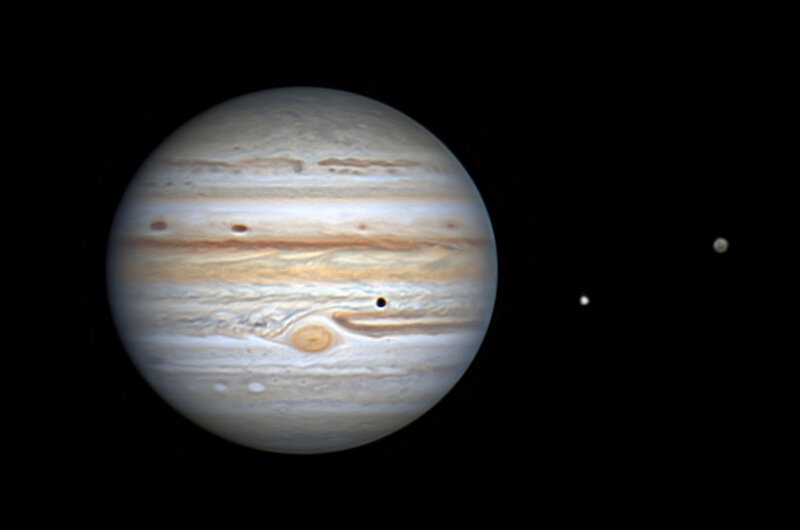

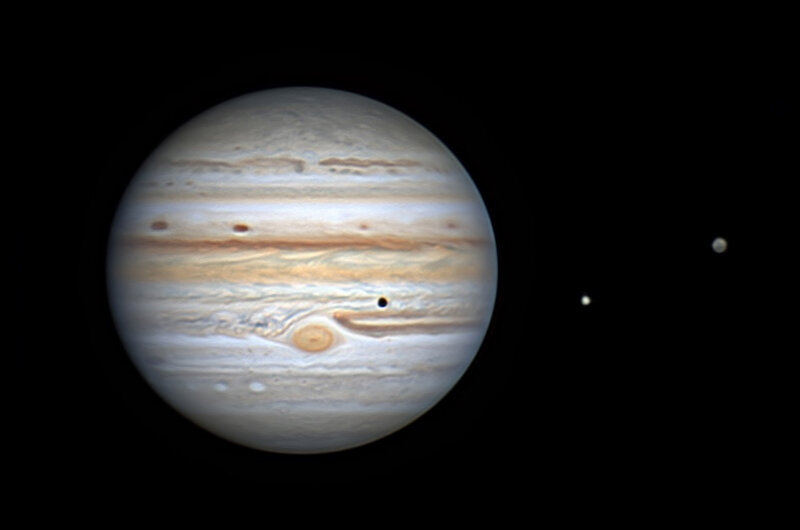

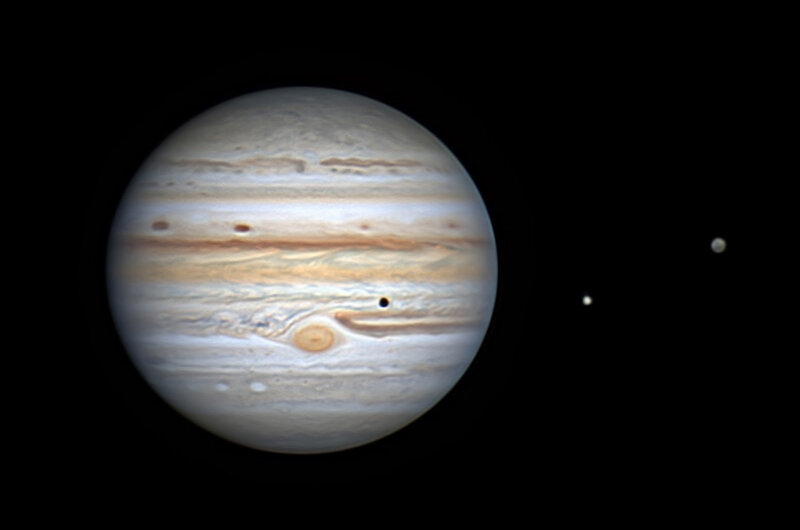

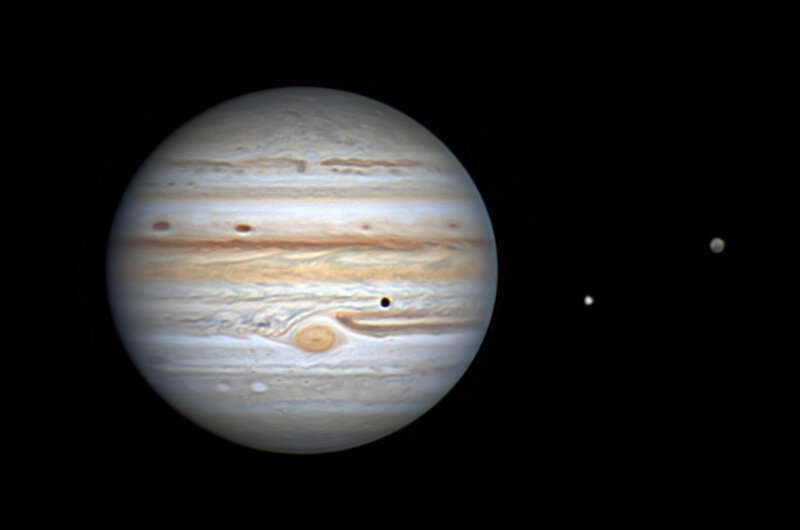

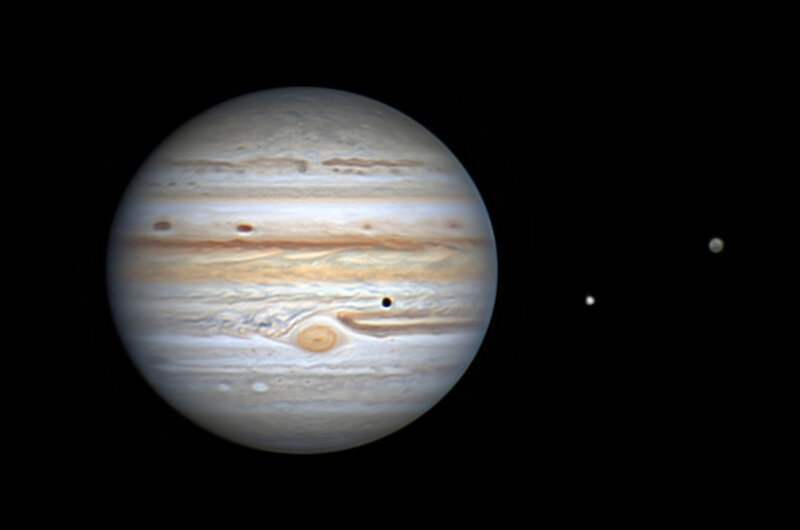

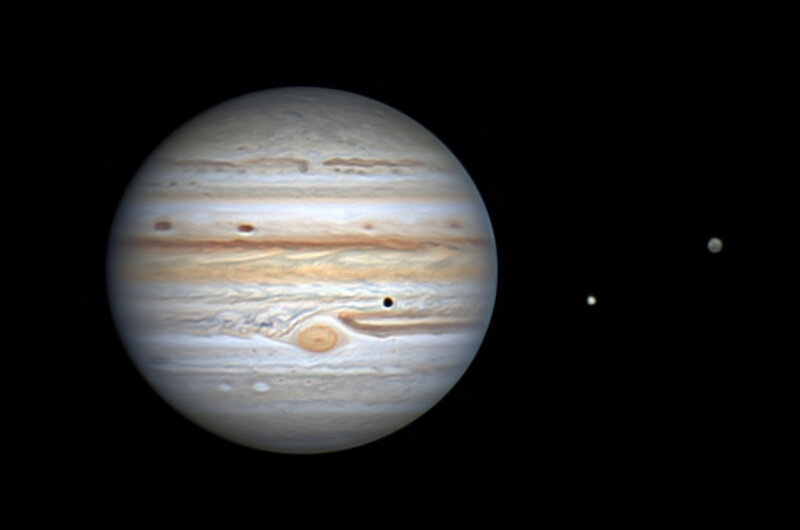

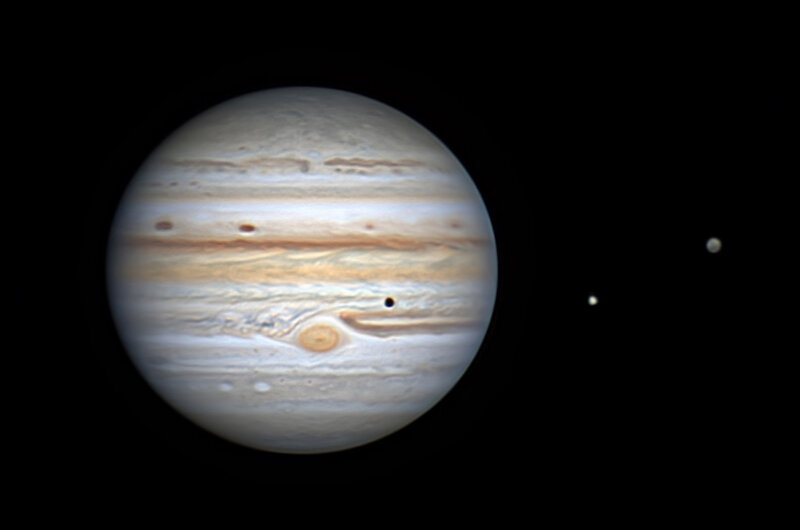

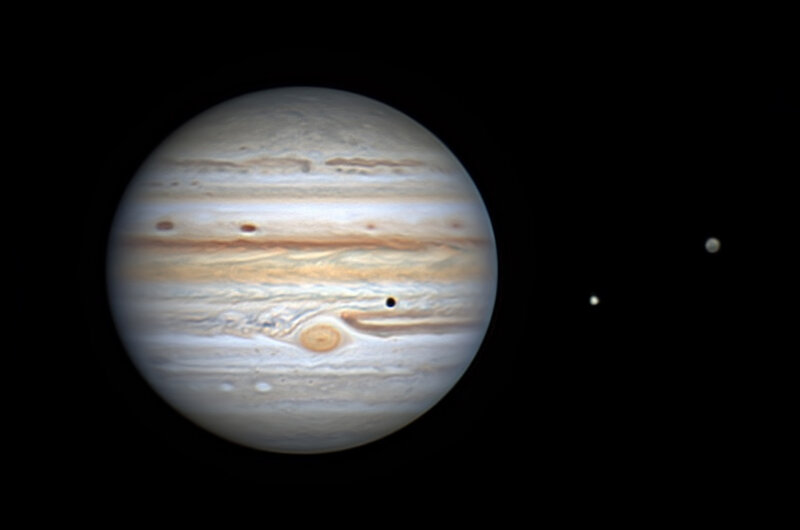

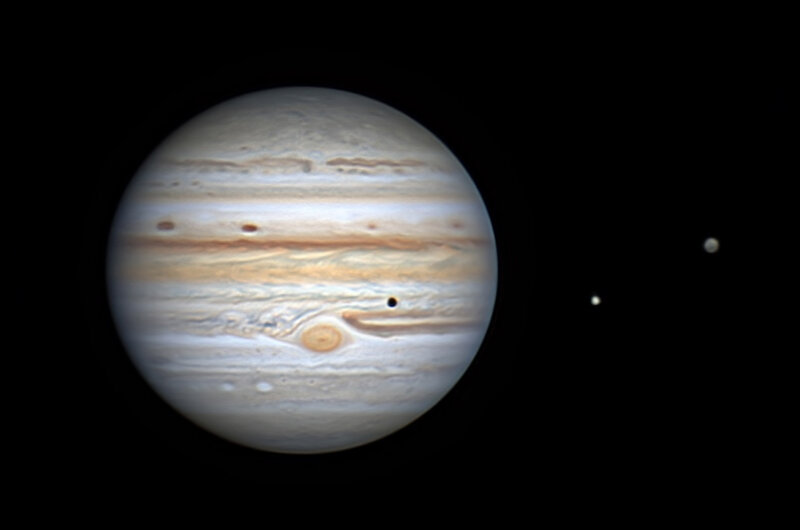

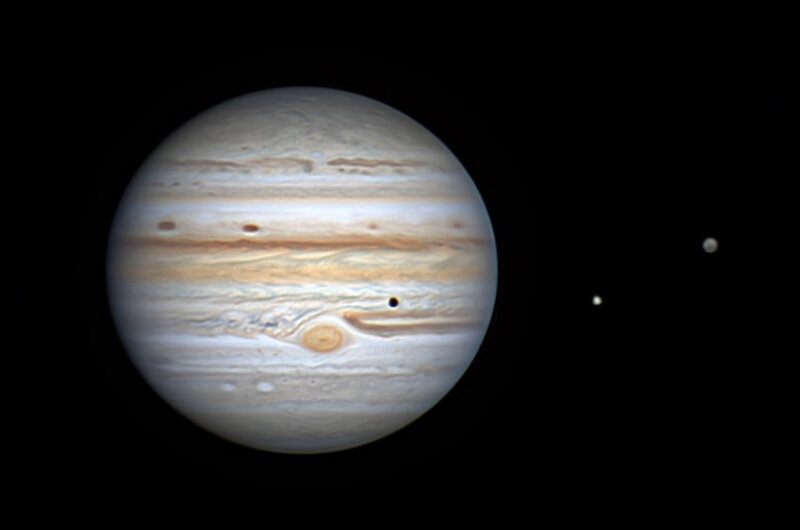

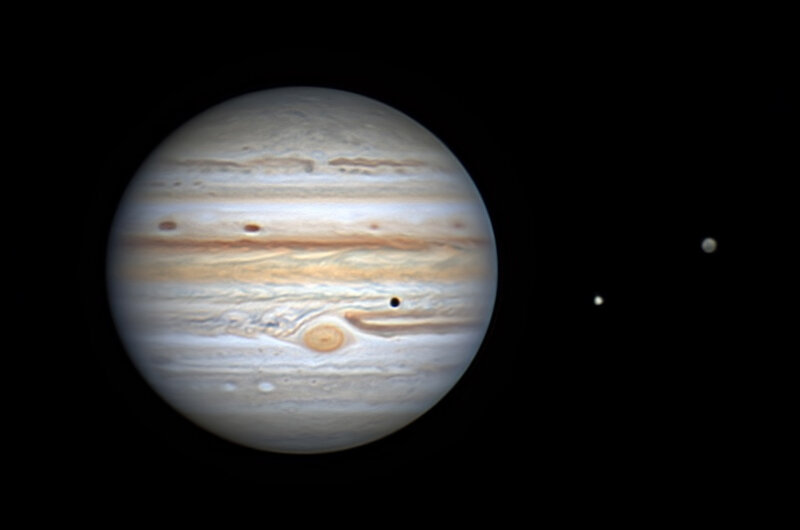

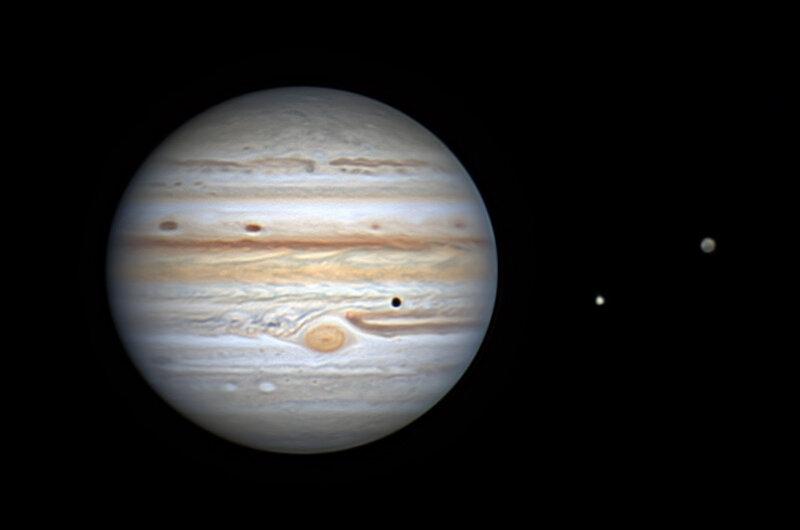

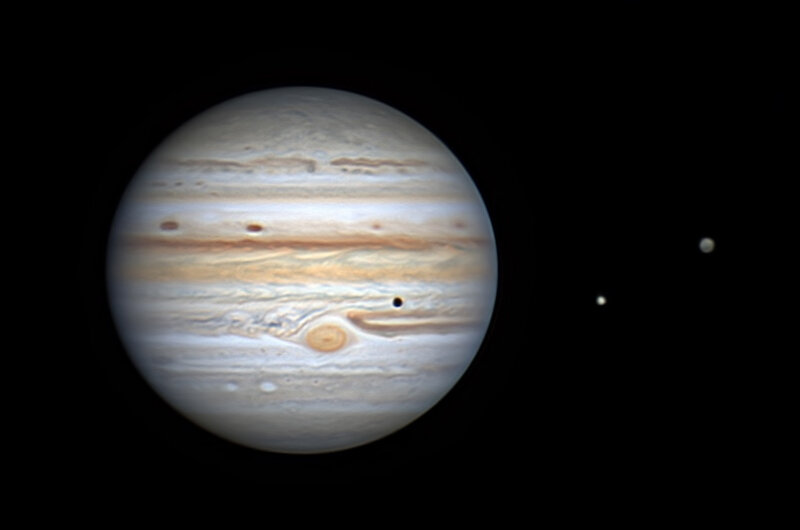

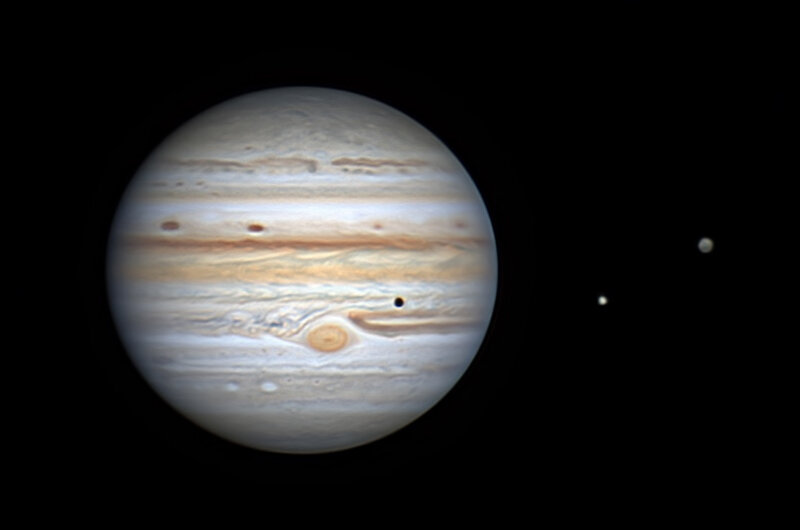

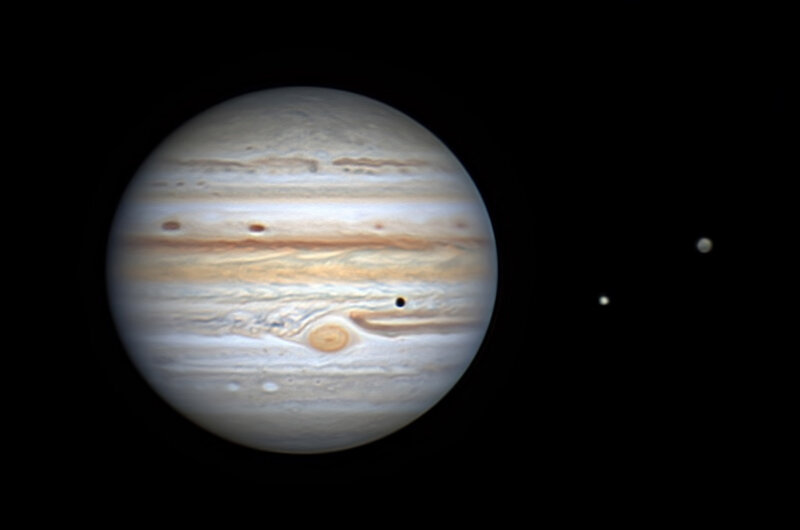

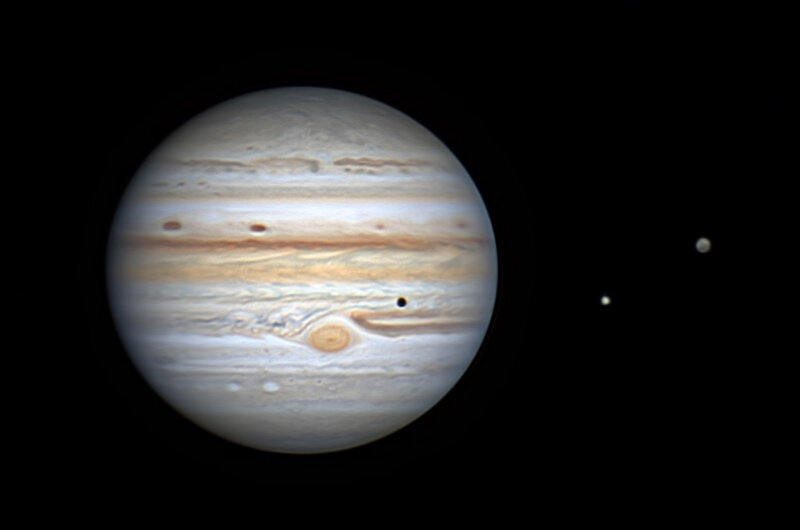

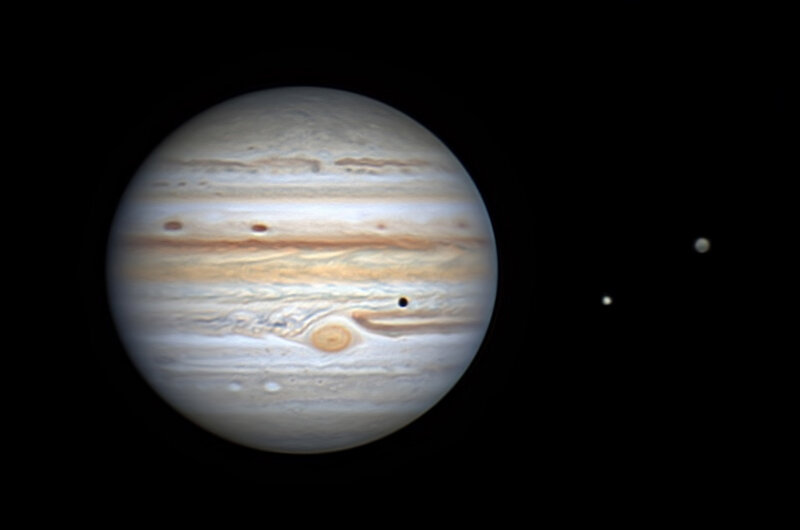

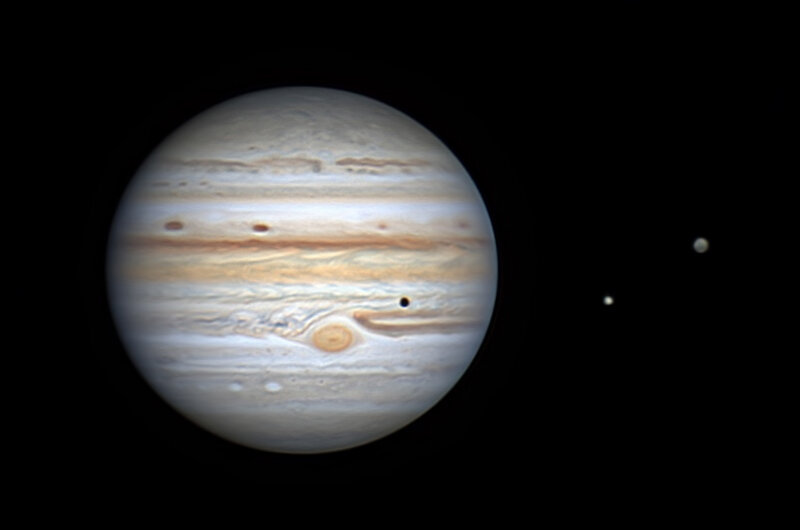

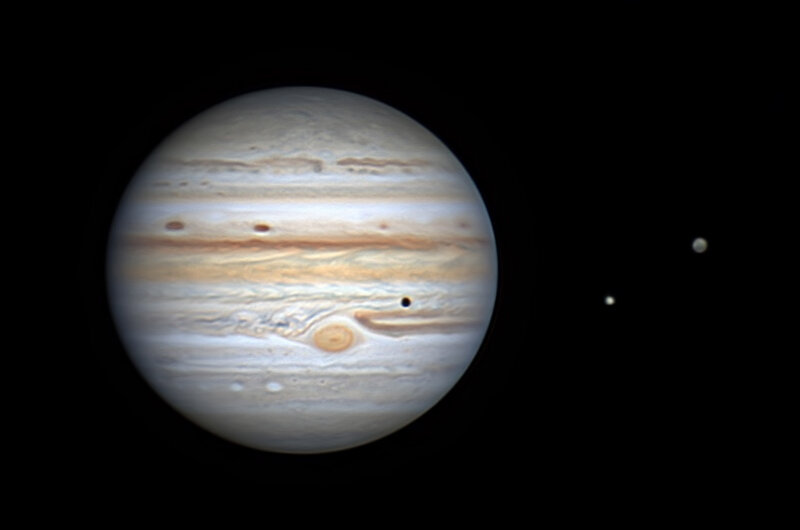

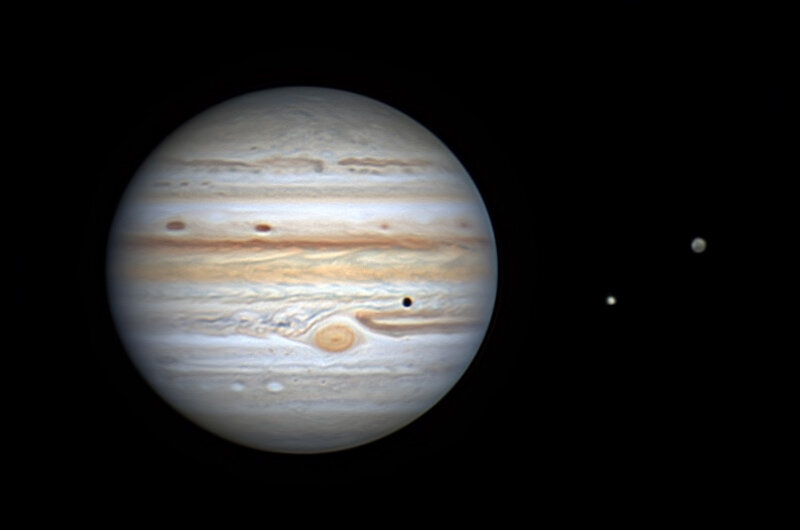

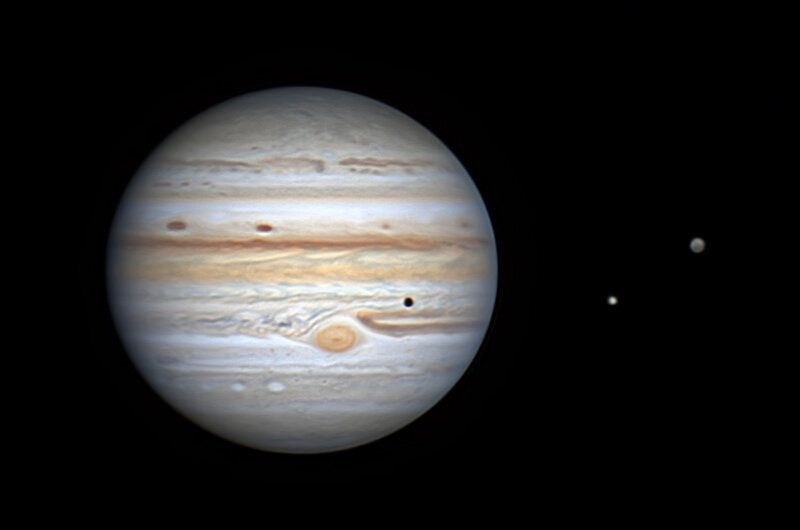

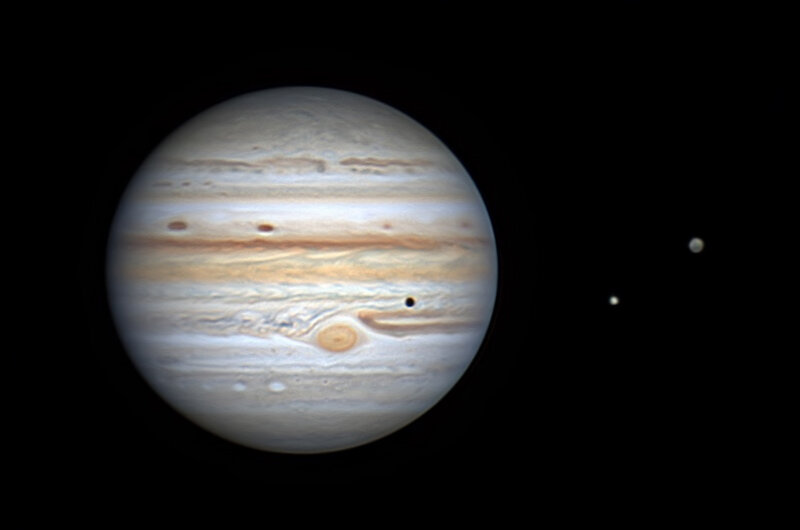

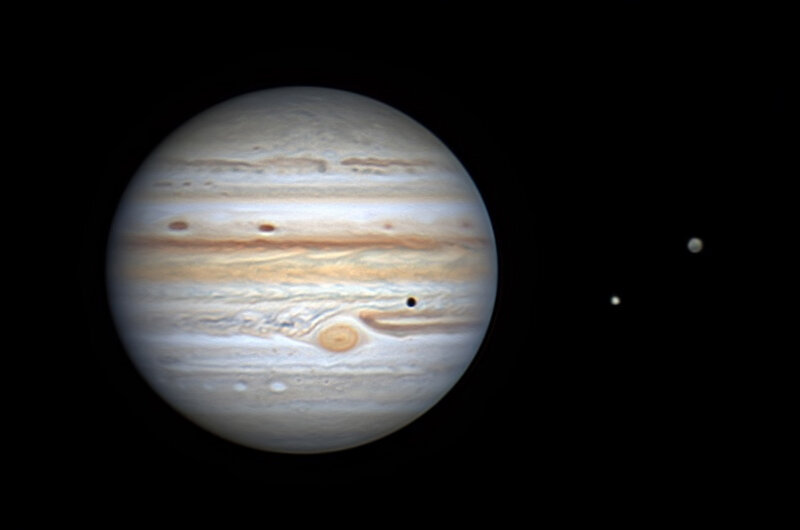

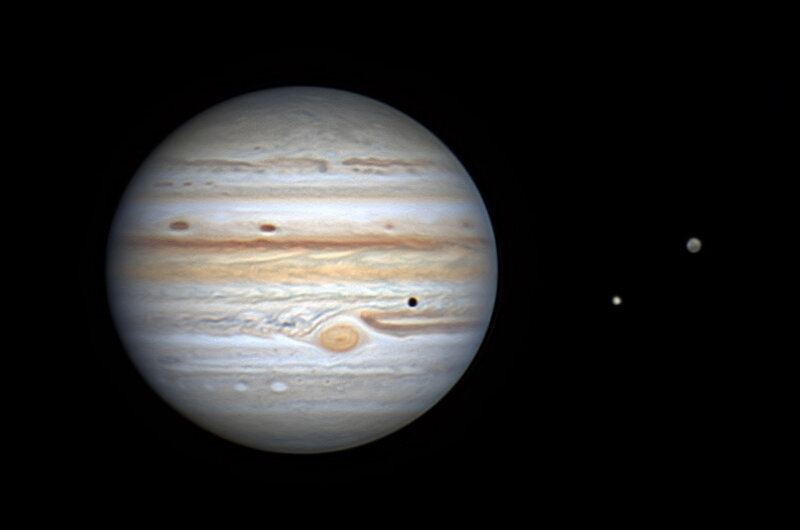

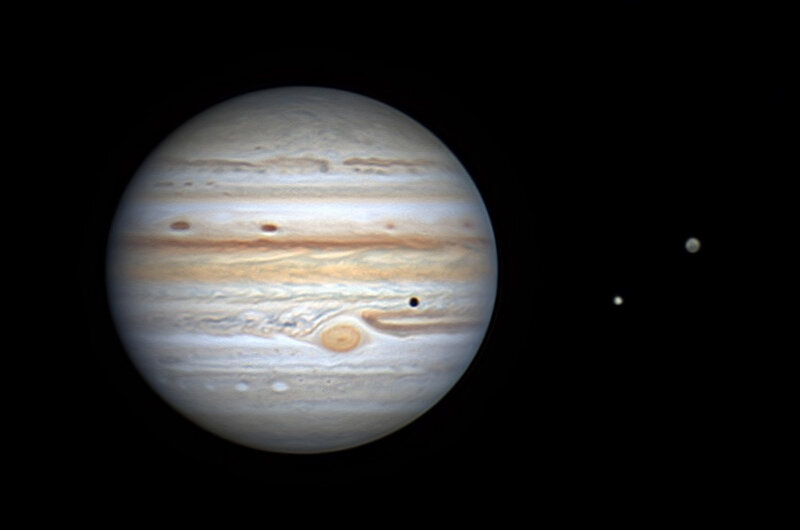

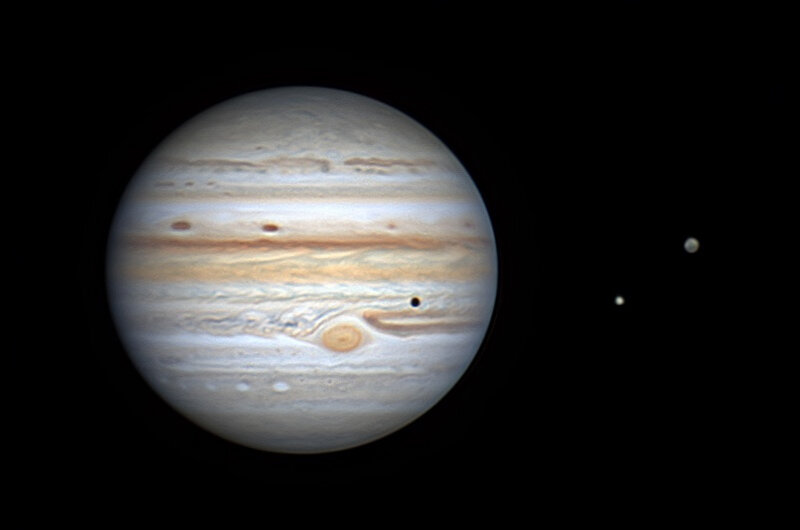

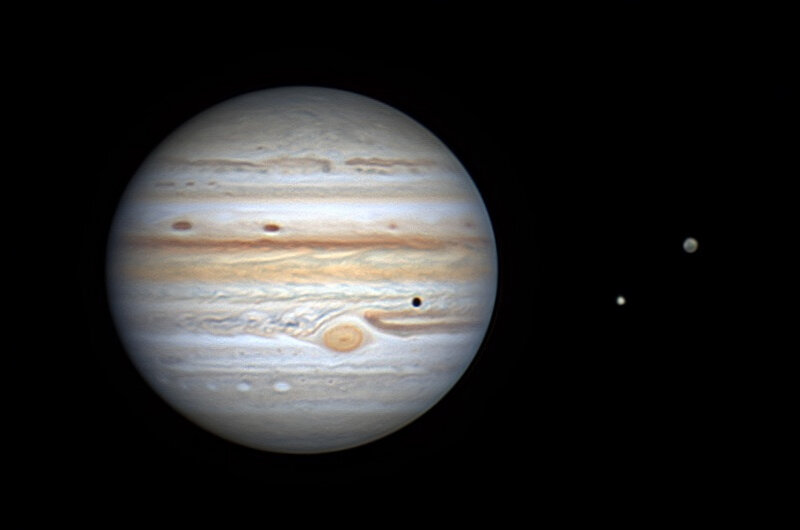

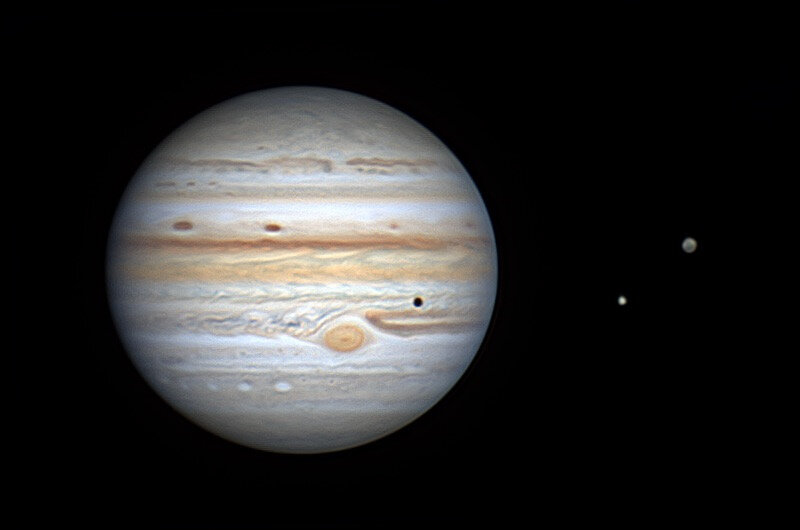

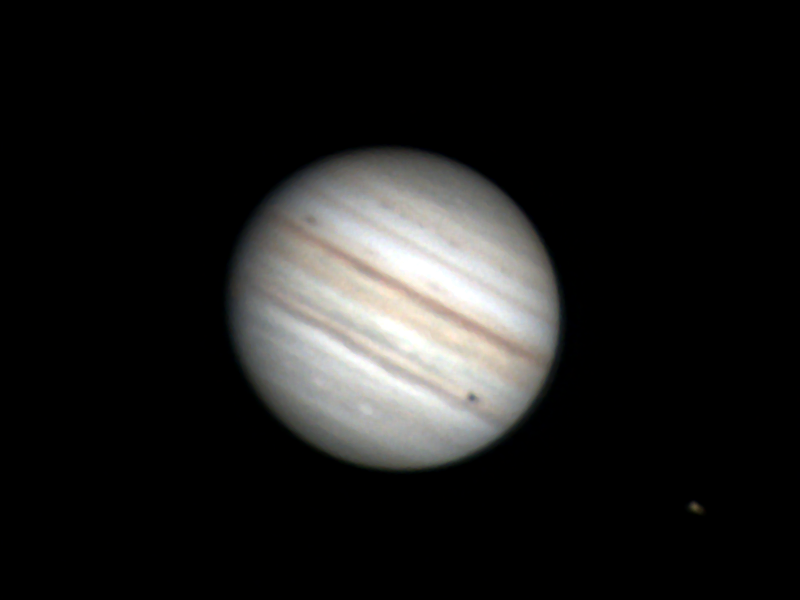

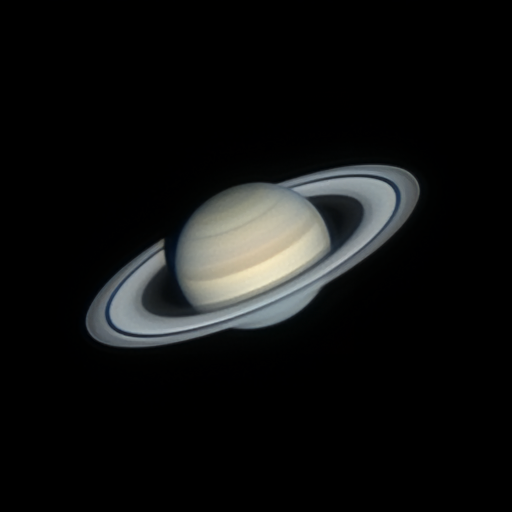

Je me demande si en France, un C11 n'est pas suffisant pour faire du planétaire. Avec un ciel qui se dégrade d'année en année, il serait plus raisonnable d'améliorer les logiciels d'acquisition que d'essayer de toujours monter en diamètre. Après Jupiter l'an passé, c'est Saturne qui démarre la saison. En utilisant la même approche que pour Jupiter, j'ai fait une première dé-rotation en ligne le 18 mai, elle devrait s'améliorer dans les prochains mois quand Saturne sera proche de l'opposition : Bien sûr ce n'est pas encore parfait parce qu'il manque les satellites, parce que l'hexagone est mal défini et qu'Encke n'est pas présente sur les anses mais c'est de la vidéo assistée c'est à dire du traitement en ligne sur une planète encore trop basse sur l'horizon. 😉

-

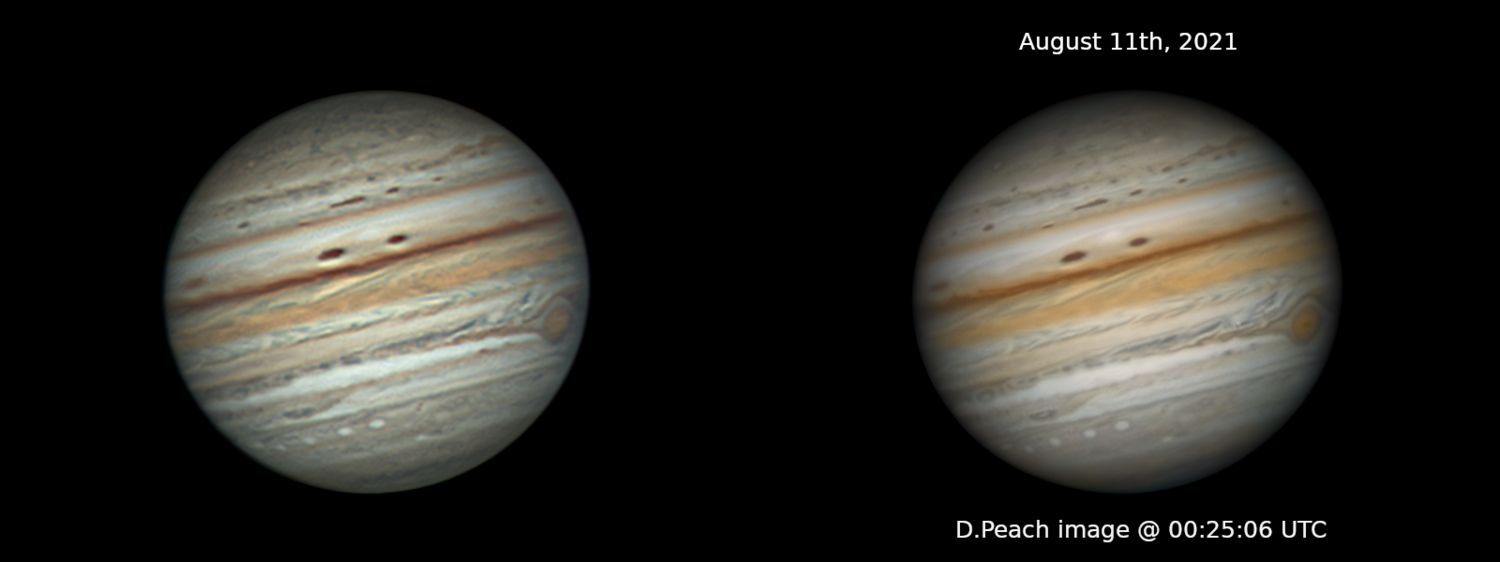

J'ai trouvé sur le site ALPO-Japan une image faite par D.Peach pratiquement au même moment que la n°85 (image de gauche) : Je pense qu'il ne devait pas avoir de bonnes conditions ce soir là mais ce qui m'intrigue c'est le lissage de son image qui fait disparaître certains détails. Est-ce lié au traitement du bruit résiduel avec les outils actuels ? Turbu est un logiciel qui apporte la simplicité et la rapidité du visuel assisté à la production de vidéos de qualité astrophoto. Reste encore à le tester sur Saturne (en cours), Mars (prochainement) et le Ciel Profond (en cours) avant de l'embarquer en 2023 sur une carte Jetson Nano Next ou Jetson Orin NX. Une version pour PC sous linux est téléchargeable sur le site : www.gpu-vision.fr , c'est la version qui a permis de faire des tests sur Jupiter en 2021.

-

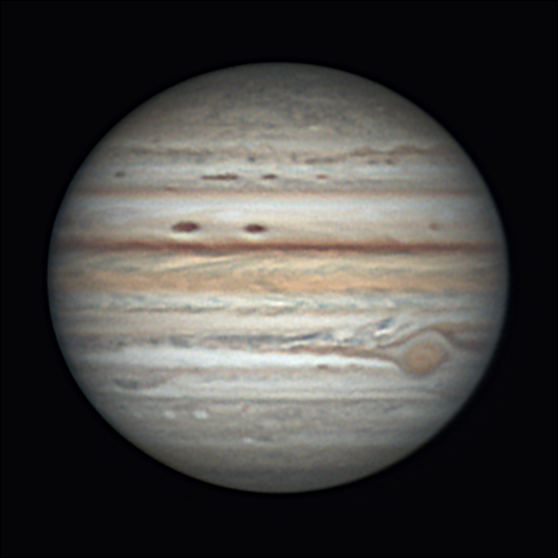

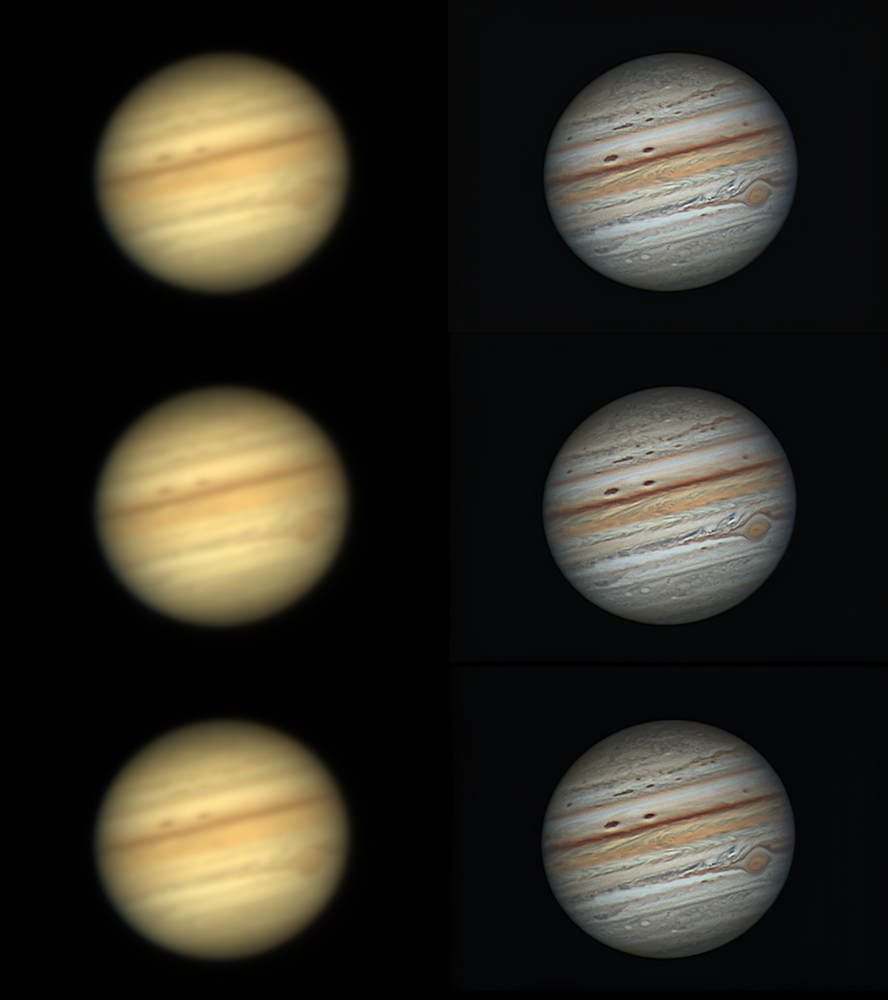

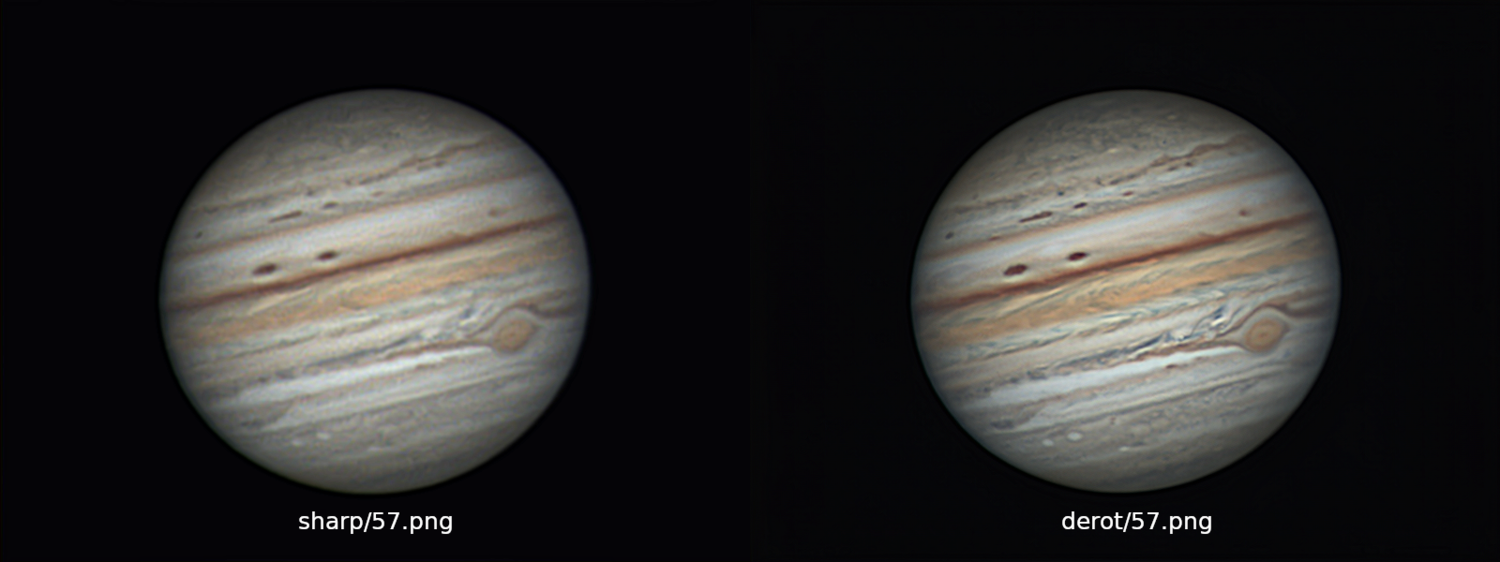

A partir des 8 images prétraitées ondelettes avec AstroSurface et dérotées avec WinJupos, zjpc obtient l'image suivante : Je vais essayer à partir de cette image qui contient les principaux détails, de me rapprocher de celle obtenue avec le logiciel "turbu". Dans un premier temps, j'obtiens celle-ci : Puis celle-là en utilisant un algorithme proche du "Multiscale Sharpen" d'Astra Image : Il ne reste plus qu'à comparer les 2 approches : Ce sont pratiquement les mêmes images. La différence c'est que "turbu" est capable de créer ce type d'image lors de l’acquisition qui se fait en live. C'est normal, puisque les passages nuageux entraînent un temps d'intégration des images brutes variable de 1 minute à 2,5 minutes pour Jupiter. Lors de cette soirée, les passages nuageux étaient nombreux mais cela n'empêche pas d'obtenir un résultat comme le montrent ces images. Pour Saturne et Mars, il y a un peu plus de marge.

-

Les outils "classiques" permettent de comparer les 2 approches : Il n'y a pas que la turbulence qui est gênante, il y a aussi les nuages d'altitude qui étaient bien présents lors de la soirée du 21 août 2021 . Le logiciel "turbu" s'adapte à la luminosité de l'objet et permet d'obtenir le meilleur empilement possible à un moment donné. Je ne crois pas que FireCapture fasse cela et pourtant avec le réchauffement climatique les conditions d'observation se dégraderont de plus en plus. Dans le cas présent, malgré les passages nuageux, les images n°35 à n°120 sont exploitables soit 86/145=60% de l'ensemble des images acquises lors de la soirée. Tout cela s'est confirmé lors d'autres observations et se confirmera certainement dans 2 mois avec l'arrivée de Saturne, puis Jupiter et puis Mars. La différence en 2022, c'est que la dé-rotation se fera en ligne, l'image de la vidéo assistée deviendra alors une image haute résolution comme l'image de droite. Le fossé entre le visuel assisté et l'astrophoto planétaire est en train de disparaître grâce à l'utilisation du calcul par le GPU.

-

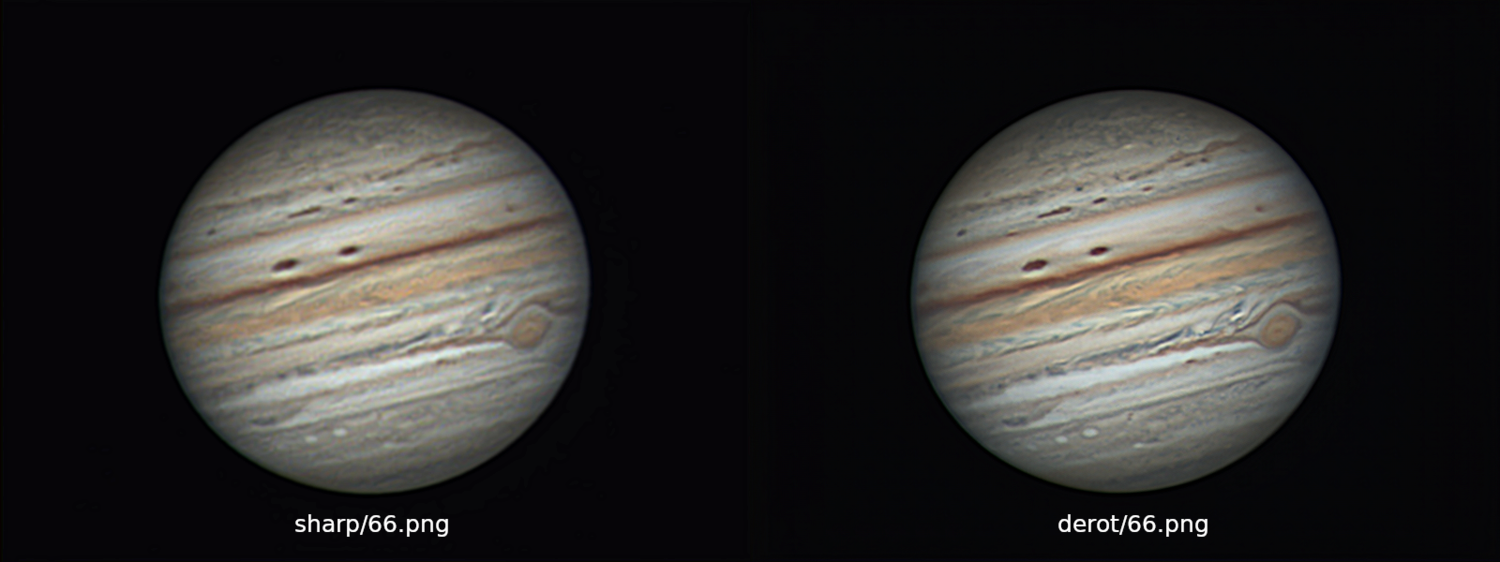

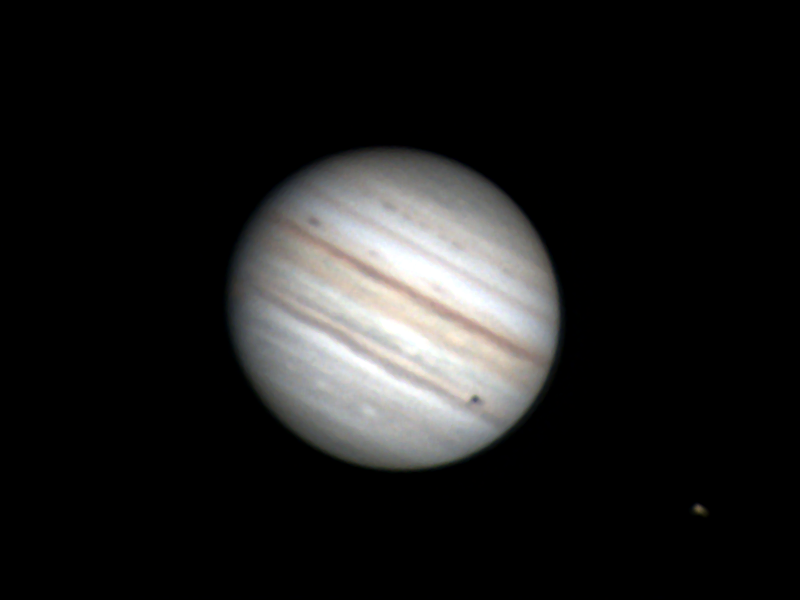

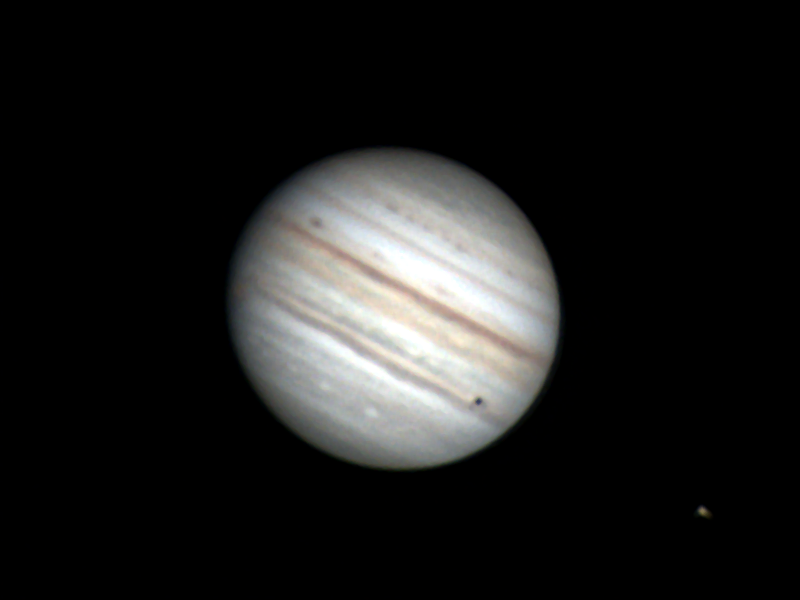

A partir des 9 images brutes données plus haut (n°59 à n°67), j'ai fait évoluer le module "planet" qui est maintenant capable de fournir en ligne de commande linux, les images haute résolution n°59 à n°67 suivantes : $ planet png/{59..67}.png derot/59.png $ planet png/{59..67}.png derot/60.png $ planet png/{59..67}.png derot/61.png $ planet png/{59..67}.png derot/62.png $ planet png/{59..67}.png derot/63.png $ planet png/{59..67}.png derot/64.png $ planet png/{59..67}.png derot/65.png $ planet png/{59..67}.png derot/66.png $ planet png/{59..67}.png derot/67.png Les paramètres sont calculés automatiquement grâce au spectre de puissance pour donner la meilleure image possible compte tenu de la rafale d'images fournie en entrée. Le module "planet" sera intégré cet été au logiciel "turbu" pour créer en ligne une vidéo assistée composée d'images quasi photographiques. Le nombre d'images en entrée peut varier en fonction de la force de la turbulence. Bien que ce ne soit pas son but, le module "planet" pourrait traiter des images empilées issues d'AS3 ou de tout autre logiciel faisant du stacking. Je reste curieux de voir ce que les astrams peuvent produire avec les logiciels existants (AstroSurface, Astra Image, SIRIL, WinJupos, ...) à partir des 9 images (brutes empilées) en entrée. 😉 Prochaine étape Saturne qui pointe le bout de son nez dans 2 mois.

-

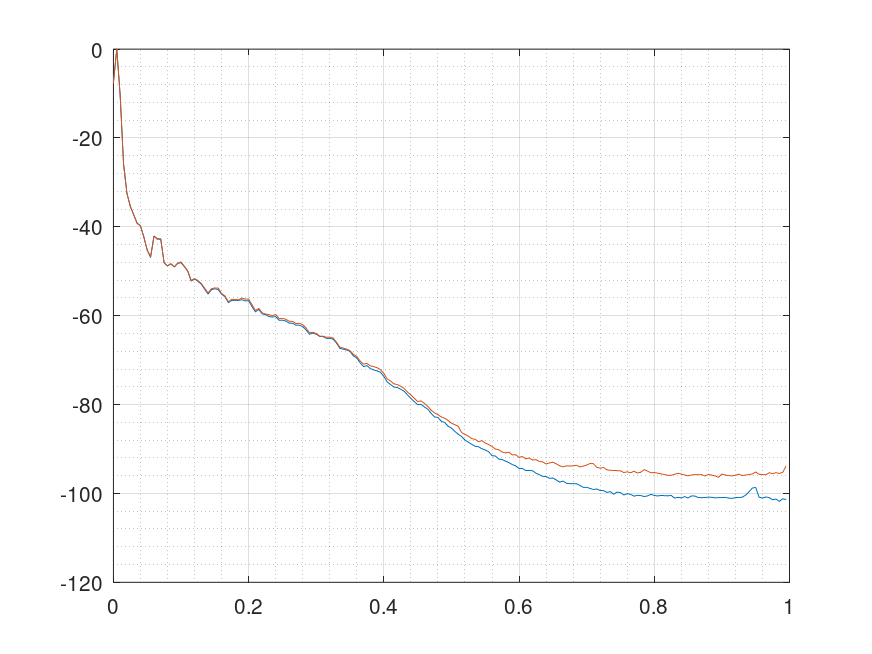

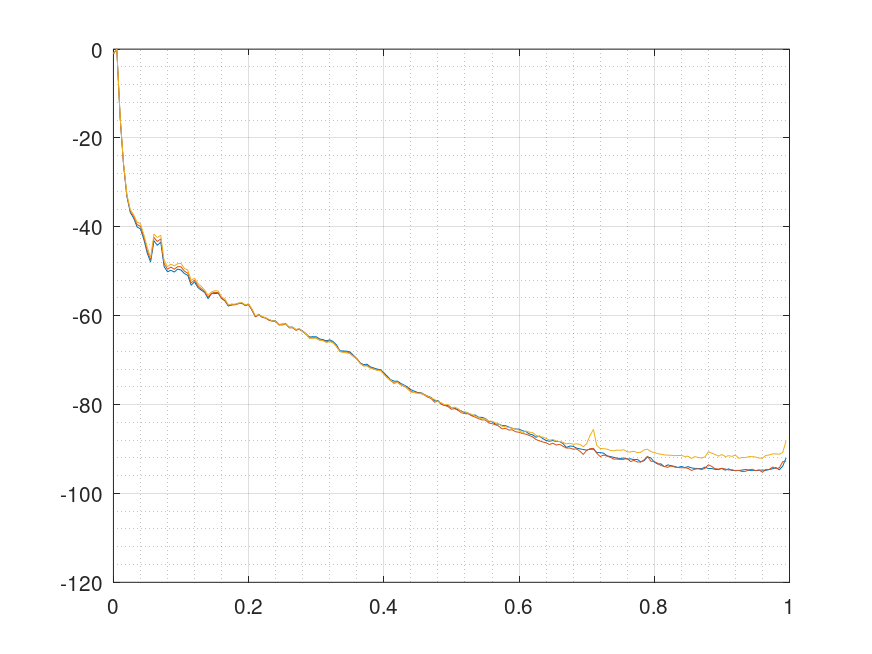

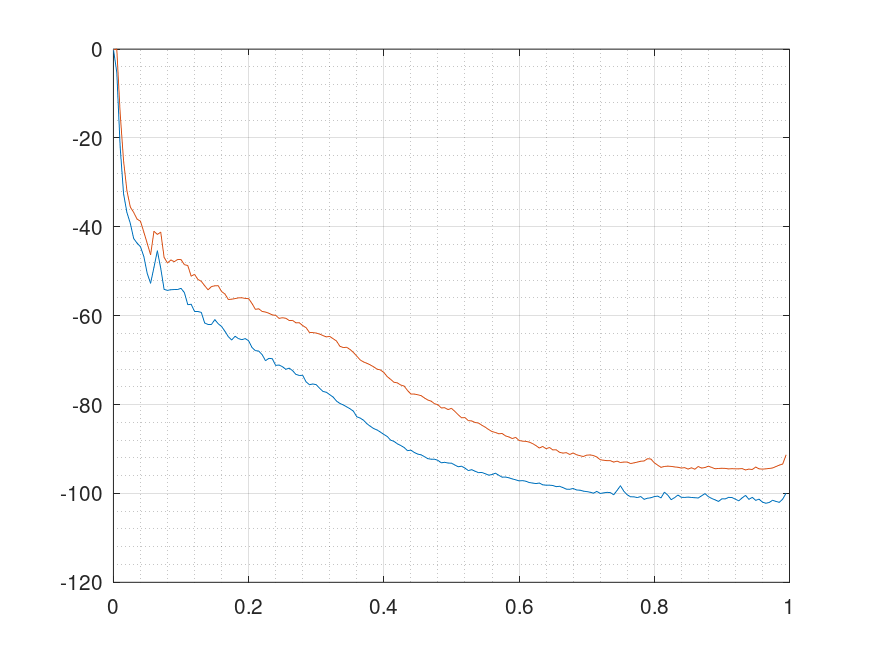

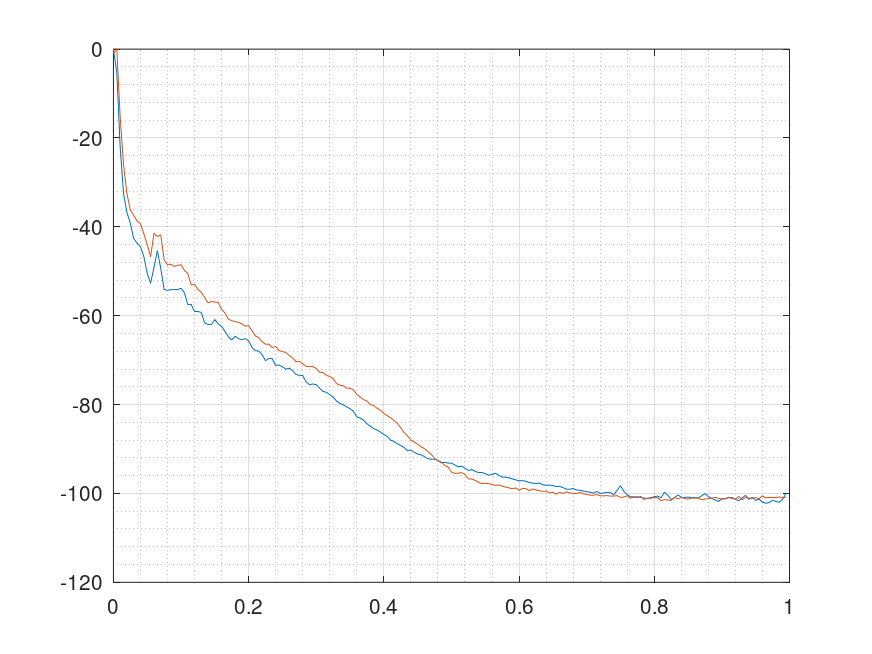

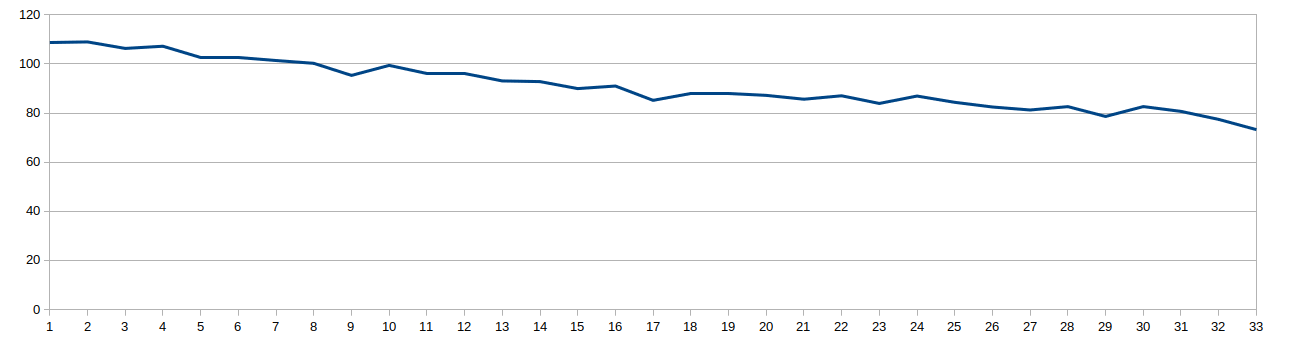

Sur 145 images de la vidéo assistée, 60% sont exploitables (n°35 à n°120) c'est à dire permettent de produire des images comme dans la série suivante (n°62 à n°64) : Les images de droite ont été obtenues par dé-rotation de 9 images centrées sur l'image de gauche. Je ne sais pas si les outils de traitement actuels permettent d'atteindre la même qualité, il faudrait faire un essai à partir des images n°59 à n°67 issues de l'empilement pour obtenir l'image n°63 : Les images issues de l'empilement : Si vous obtenez un résultat semblable, cela voudra dire que vos logiciels actuels permettent d'extraire autan d'information que le logiciel "turbu". La seule différence sera alors que "turbu" travaille en ligne et qu'il lui faut environ 30s entre chaque image finale (image de droite). Si vous n'obtenez pas un résultat semblable, cela voudra dire que les logiciels actuels ne permettent pas de tirer le maximum de vos images empilées sous AS3 ou similaire. Cela voudrait dire aussi que vous avez des tonnes d'images empilées qui ne sont pas exploitées à leur juste valeur. Je suis curieux de voir le résultat que vous allez obtenir pour l'image n°63. L'écart que j'obtiens pour les images n°62, 63 et 64 est le suivant :

-

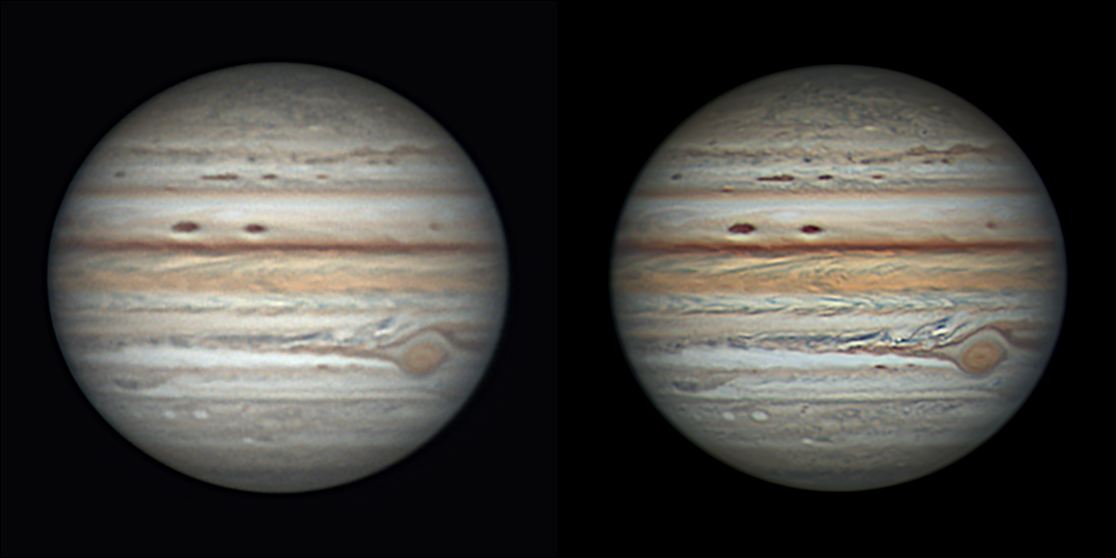

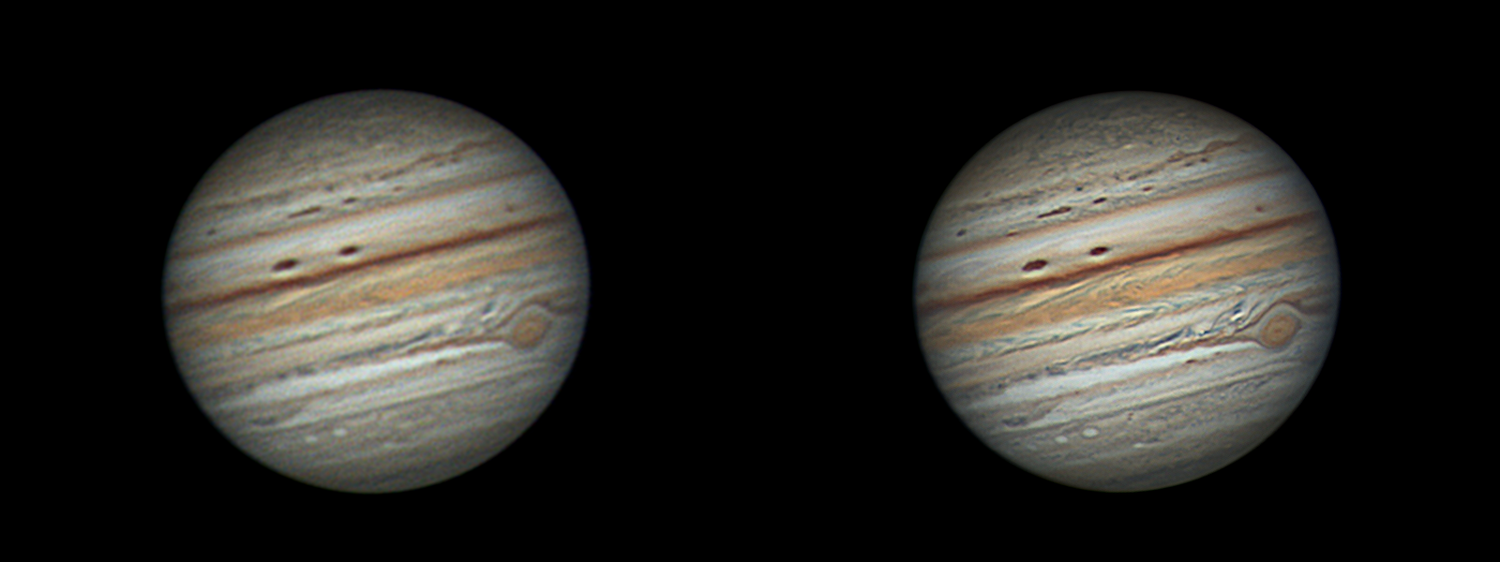

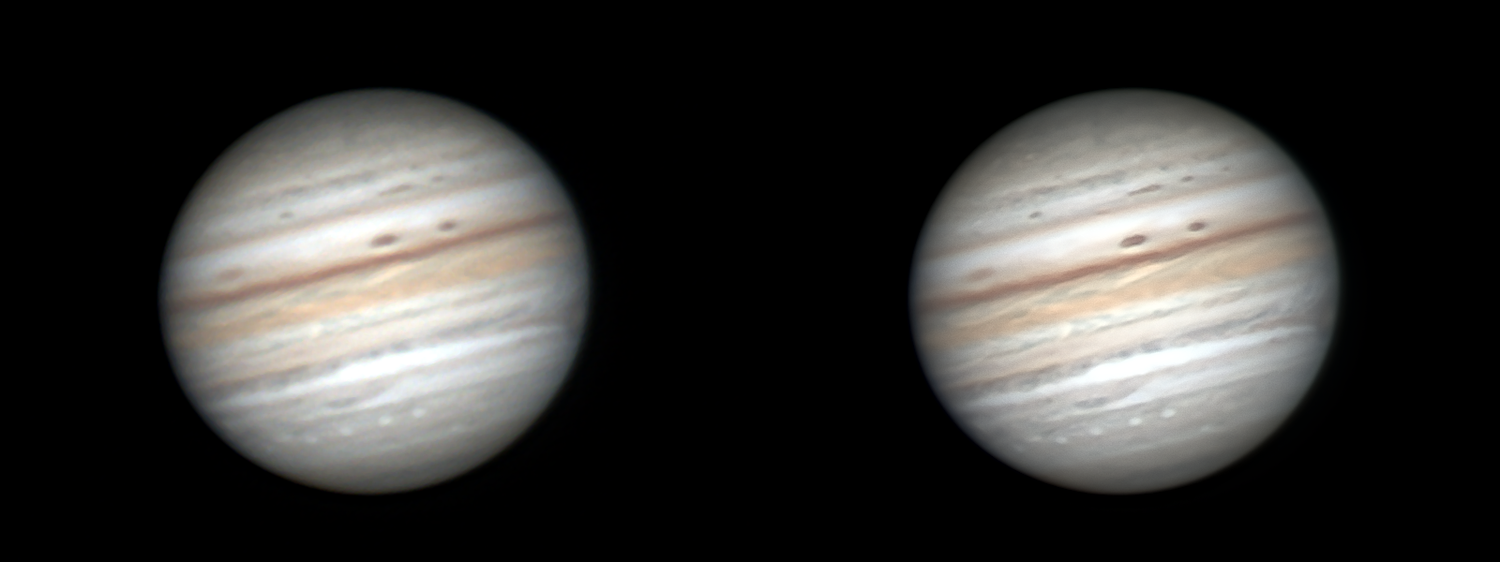

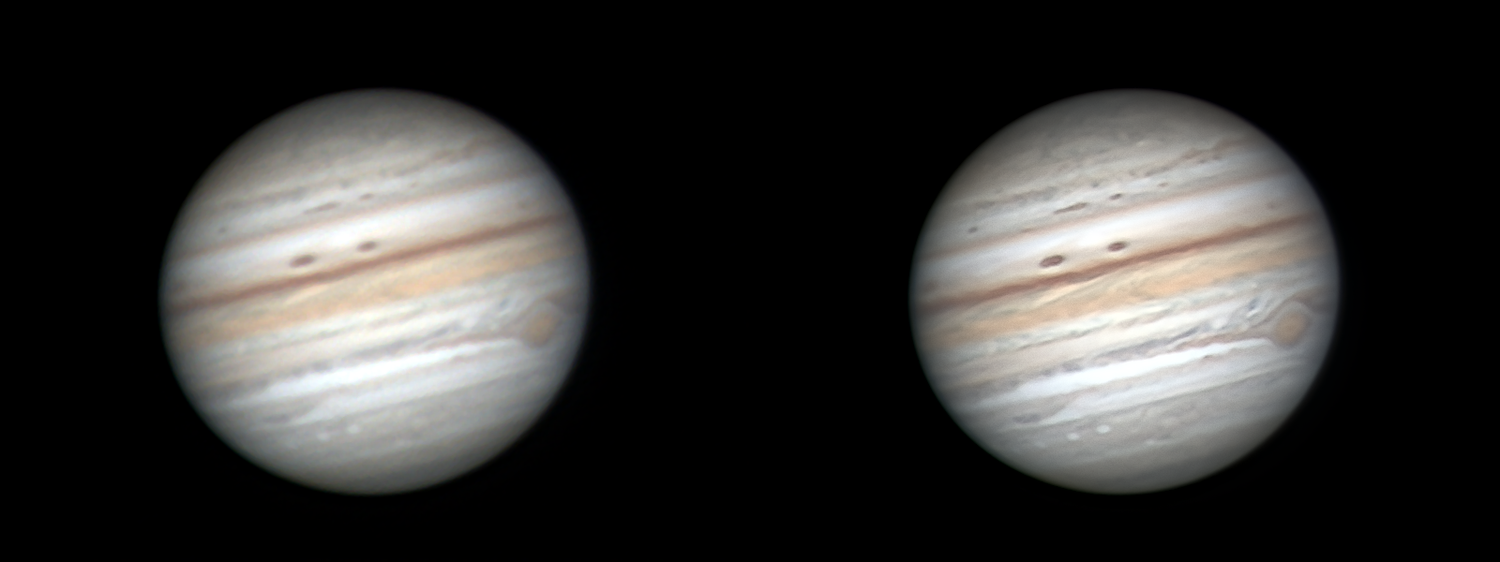

La dernière mouture du logiciel "turbu" que je testerai cet été verra l'arrivée du répertoire "derot". Au stade actuel du développement voici à quoi cela ressemble : A gauche la vidéo assistée, c'est à dire ce que voit l'utilisateur au bout de 30s sur son écran. A droite la dé-rotation, c'est à dire la combinaison d'images de la vidéo assistée qui se fait en tâche de fond.

-

Ces courbes représentent le spectre de puissance normalisé des images. Pour le détail, voir par exemple : https://fr.mathworks.com/matlabcentral/fileexchange/24227-powerspectrum-m Toute autre représentation est possible mais il semble que ce soit celle retenue par Fitswork que pas mal d'astrams utilisent. J'utilise le spectre de puissance au départ lors du choix de l'image de référence afin de déterminer automatiquement les bons paramètres. Par exemple pour générer l'image n°66 de la vidéo assistée à partir de l'empilement de 5400 images brutes 800x600 @ 180fps : a) l'empilement prend 5400/180 = 30s b) le calcul de l'image de la VA demande 2/100e de seconde avec ma carte graphique compte tenu des paramètres fournis par le spectre de puissance : $ planet png/66.png sharp/66.png 80000 0.27 1.4 1.6 6300 le logiciel "planet" simule ce que fait le logiciel "turbu" pour passer des images empilées (répertoire png) aux images du VA (répertoire sharp). Je mettrai prochainement cette manip sur le site afin que ceux qui ont installé linux puissent tester, après exécution du logiciel "planet" : En même temps cela permettra de vérifier que tous les modules sont bien installés.

-

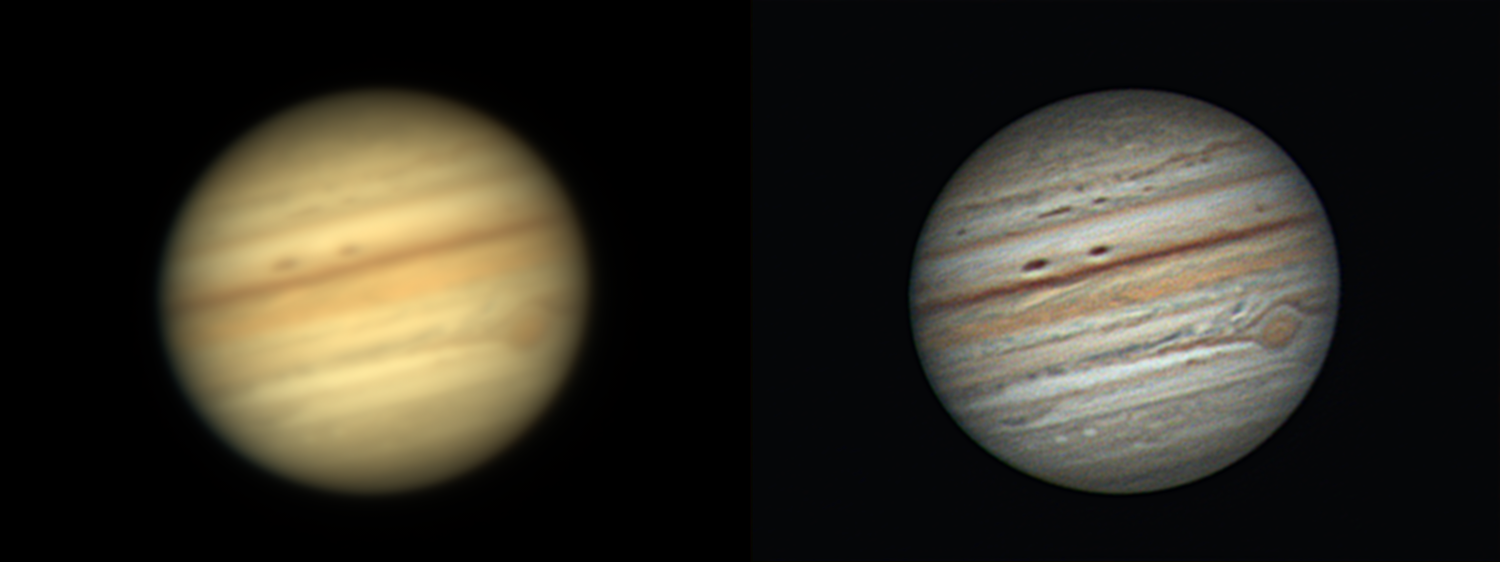

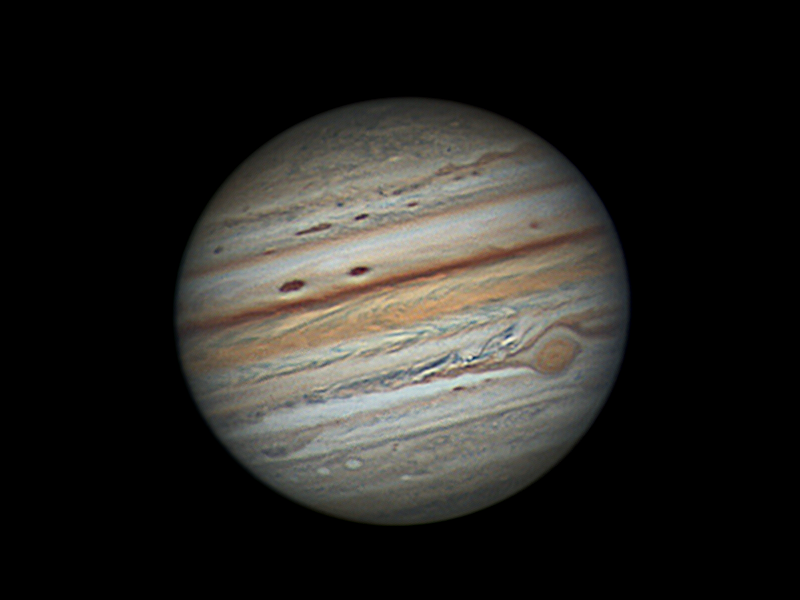

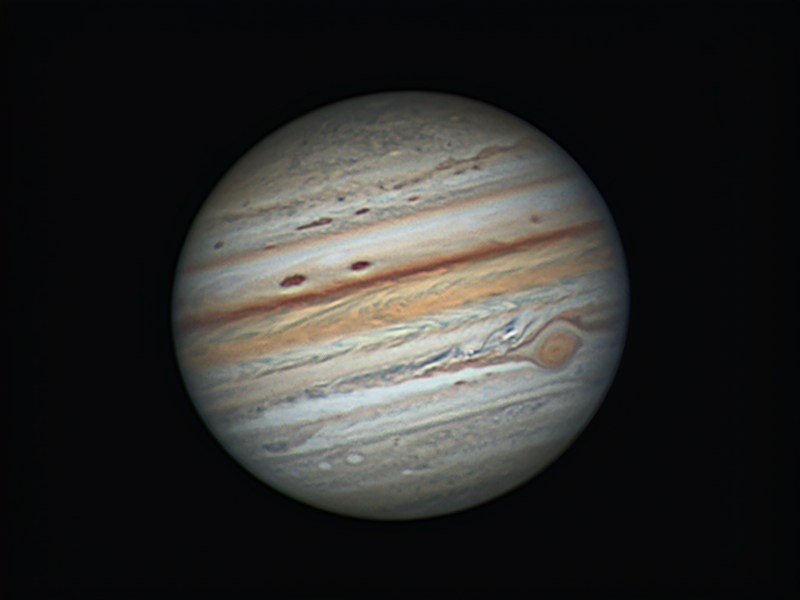

Il y a en effet un écart de netteté important entre les 2 images comme le montre la courbe suivante : La courbe correspondant à ton image passe par le point (0.30, -80dB) ce qui est assez éloigné du point (0.44, -80dB) . On retrouve bien les principaux détails mais l'image manque de netteté. La dernière méthode permet d'atteindre une qualité photo lors de la séance de vidéo astro, j'ai une image à l'écran issue de l'empilement au bout de 30s (image de gauche) de qualité analogue à la tienne et pendant ce temps la dé-rotation qui tourne en tâche de fond produit une image haute résolution (image de droite) : Je compare la courbe de mon image de la vidéo assistée (courbe rouge) avec la courbe de la tienne (courbe bleu) : Les courbes sont maintenant très proches mais la mienne résulte du traitement d'une seule image obtenue au bout de 30s d'acquisition (800x600 @180fps) sans dé-rotation et non de 7 avec dé-rotation comme dans ton cas, il y aurait donc déjà un écart au niveau des algorithmes utilisés. La version du logiciel turbu (sous linux uniquement) téléchargeable depuis janvier 2022 sur le site www.gpu-vision.com produit l'image de gauche dans le sous-répertoire "sharp". La version que je testerai cet été (sous linux uniquement) produira en plus l'image de droite dans le sous-répertoire "derot".

-

Ce qui serait intéressant c'est de comparer avec ce que font les outils actuels (AstroSurface, WinJupos, ...) à partir des images empilées contenues dans le répertoire png du lien suivant : http://gpu-vision.fr/site/file/source/jup-210811/png.zip Le traitement actuel (vidéo ci-dessus) donne par exemple pour l'image n°61 : ou pour l'image n° 66 : L'objectif du logiciel turbu est de réduire le fossé de qualité existant actuellement entre la vidéo assistée et l'astrophotographie en utilisant pour cela la puissance de calcul des cartes graphiques. Dans un premier temps, je m'intéresse à la Lune et aux planètes mais le Ciel Profond est en cours de développement.

-

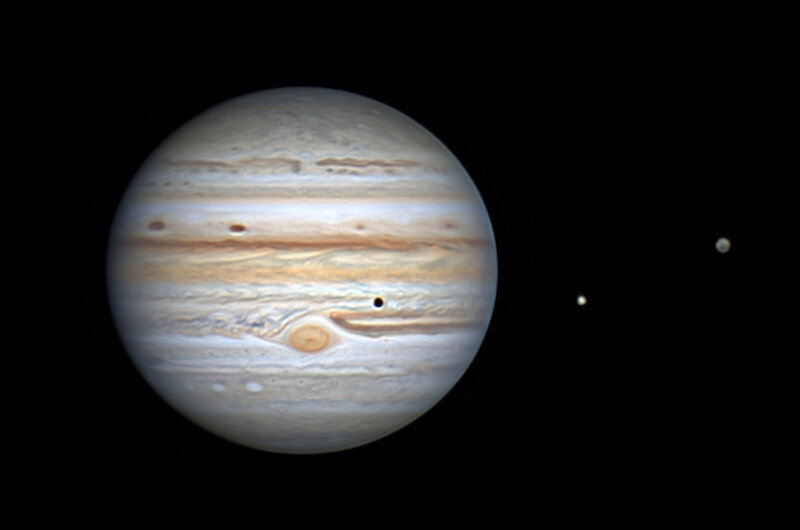

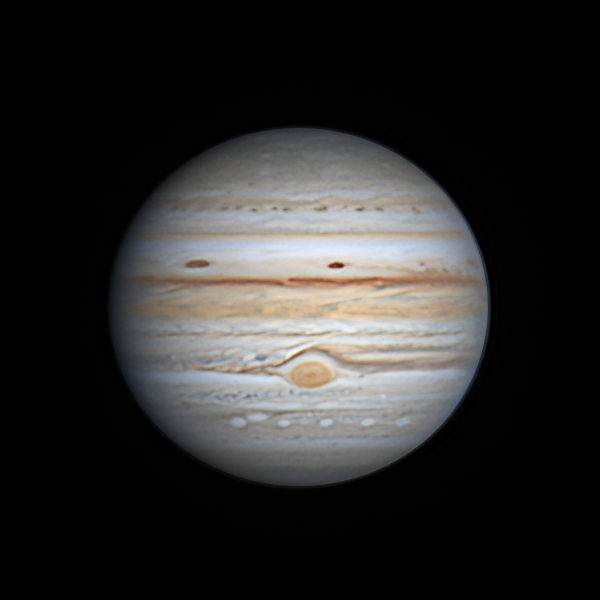

Avec une meilleure maîtrise de la dé-rotation voici le résultat final 8 mois plus tard : 😉 Avec quelques détails intéressants : La vidéo correspondante : Le changement de couleur en début de la vidéo correspond à un des passages nuageux signalé plus haut. Ce dernier traitement des images de la vidéo assistée sera appliqué cet été à Mars, Jupiter et Saturne pour être embarqué plus tard sur une carte Jetson Nano Next. Le traitement de dé-rotation est effectué en tâche de fond de la vidéo assistée (en live). En fin d'acquisition, il n'y a plus rien à traiter. 😉 PS : ce n'est pas la meilleure session de cet été (à cause des passages nuageux et de la collimation qui est perfectible) mais celle qui me sert à faire des essais en vu de la prochaine saison.

-

Animation de Jupiter à partir de 2 images séparées de 20 minutes

ms55 a répondu à un sujet de ms55 dans Astrophotographie

Bonsoir à tous, Le site http://www.GPU-Vision.fr est ouvert. Bonne soirée. ms55 -

Animation de Jupiter à partir de 2 images séparées de 20 minutes

ms55 a répondu à un sujet de ms55 dans Astrophotographie

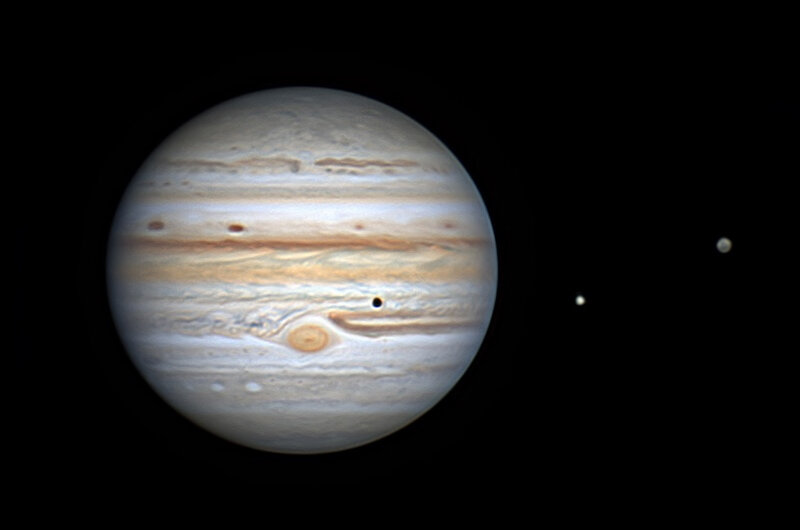

Retour sur une vidéo présentée fin août 2021 sur ce fil (à l'époque, je n'avais pas implémenté la dérotation) : Aujourd'hui, j'ai remplacé l'utilisation du deep-learning par l'utilisation d'un algorithme de dérotation (flot optique de précision gérant les occultations) dans le logiciel "turbu version 1.0" : - à gauche les images 59 à 115 issues de la vidéo assistée réalisée avec "turbu version 0.1" le 11 août 2021 entre 1h57 et 3h04 TL, - à droite les images obtenues avec l'option dérotation du logiciel "turbu version 0.1" sur 16 minutes (j'ai fait d'autres essais avec 10/12/14/16/18/20 minutes). Cette vidéo montre aussi la gestion des occultations (occlusions) lors du passage de la GTR au bord du globe : La GTR au bord du globe : La meilleure image dérotée de la vidéo : Voilà, je pense avoir fait une présentation assez complète de la dérotation avec "turbu version 0.1" : pas d'artefact, gestion des occultations, des satellites, des ombres de satellites. 😉 C'est le même algorithme de flot optique de précision qui est utilisé : - pour créer les images n°2 à n°32 à partir des images n°1 et n°33 de Kant (2 images espacées de 20 minutes en entrée donnent 31 images en sortie), - pour créer les images de droite de la vidéo ci-dessus à partir des images de la vidéo assistée du 11 août 2021 (une rafale de 15 images en entrée donne une image dérotée en sortie). Le but de la dérotation est de réduire le bruit et de montrer plus de détails, je pense que cet algorithme répond à cela. Le logiciel "turbu version 0.1" permet : - d'obtenir des images comme celles de gauche dans la vidéo ci-dessus, - d'améliorer, si besoin, ces images en faisant appel à la dérotation. La dérotation pouvant se faire en cours d'observation ou après coup, elle permet d'obtenir des images de meilleure qualité, c'est plus de l'astrophoto que de la vidéo assistée. La prochaine version de turbu intégrera un modèle de dégradation en entrée et une amélioration de l'algorithme de déconvolution aveugle. Cela devrait permettre d'obtenir de meilleurs résultats en conditions plus dégradées. Mes prochaines interventions se feront sur les sites gpu-vision ou sur le forum Nvidia Jetson à partir de janvier 2022. L'ouverture des sites gpu-vision est prévue mi-janvier 2022. -

Animation de Jupiter à partir de 2 images séparées de 20 minutes

ms55 a répondu à un sujet de ms55 dans Astrophotographie

Ça fait un traitement supplémentaire mais si les utilisateurs de WinJupos y trouvent leur compte, tant mieux. Un algorithme de flot optique devrait être robuste aux occlusions, il semble que ce ne soit pas le cas avec WinJupos. Comment faites vous avec WinJupos quand la GTR passe de l'autre coté du globe ? Oui c'est un problème qui devrait être résolu avec l'ouverture d'un site internet en janvier 2022, je voulais le terminer pour fin 2021 mais comme je veux faire du pas à pas ça prend du temps. Cela montre déjà qu'il y a une autre façon de faire et peut-être que cela servira un jour à ceux qui utiliseront le logiciel "turbu". Moi cela m'a servi de test pour l'algorithme qui calcule la qualité d'une image, les valeurs se répartissent linéairement entre l'image n°1 de meilleure qualité et l'image n°33 de qualité moindre, ce qui est bon signe. -

Animation de Jupiter à partir de 2 images séparées de 20 minutes

ms55 a répondu à un sujet de ms55 dans Astrophotographie

L'idée est de faire un logiciel embarqué qui tourne sur une carte de la famille Nvidia Jetson : Nano, TX2 NX, Xavier NX, ... et dont la consommation n’excède pas 20W. Sur Jetson Nano 4GB "turbu version 0.1" a une autonomie de 8h (2 batteries 5V3A pour le calculateur et l'écran tactile). La prochaine étape sera de monter en puissance avec les cartes TX2 NX et Xavier NX en attendant le modèle Nano Next prévu pour 2023. Ce système sera réellement intéressant s'il permet effectivement d'imager sous turbulence forte, j'ai fait quelques tests cet été mais c'est en 2022 que j'aurai la réponse avec Mars, Jupiter et Saturne. 😉 Pour ceux qui n'ont pas de carte Jetson, j'ai fait une version 0.1 qui tourne sur toute machine Ubuntu 18.04 ou Linux Mint 19.3 possédant au moins une carte GTX1050 Ti. Pour Windows et OSX que je n'utilise plus depuis au moins 10 ans, je ne ferais pas de version. : En 2023, il n'y aura plus qu'une seule version 1.0 sous Jetson Nano Next, elle sera gratuite pour tous ceux qui auront installé et utilisé "turbu version 0.1" avec succès. 😉 Concernant les 33 images JPEG obtenues à partir des images n°1 et n°33 de Kant, c'est plus facile d'analyser les fichiers originaux que ceux extraits d'un gif animé qui apporte son lot de bruit et d'artefact (20 minutes cela fait beaucoup, 10 minutes seraient plus raisonnable) : image n°1 (Kant) : image n°2 (algo ms55) : image n°32 (algo ms55) : image n°33 (Kant) : PS : le résultat serait nettement meilleur si les images n°1 et n°33 n'avaient pas été traitées avec WinJupos mais avec un algorithme gérant un flot optique de précision. Pour le vérifier, il suffirait d'avoir les quelques images ayant permis de produire les images n°1 et n°33. 😉 La vidéo : Qualité des images : La linéarité est presque parfaite. Je serais maintenant curieux de voir la même manip avec WinJupos parce que quand je vois les critiques sur le forum d'à coté, il y a de quoi tomber de sa chaise. 🤣🤣🤣 -

Animation de Jupiter à partir de 2 images séparées de 20 minutes

ms55 a répondu à un sujet de ms55 dans Astrophotographie

L'hébergeur Online.net a merdé et du coup la base de données a été vérolée. J'ai changé d'hébergeur et du coup j'en ai 2 pour le prix d'un : www.gpu-vision.fr www.gpu-vision.com j'ai choisi un outil sans base de données pour réaliser ces 2 sites, le premier en français et le second en anglais. L'idée c'est de mettre dans un premier temps toutes les infos nécessaires pour installer et lancer "turbu version 0.1" sur PC ou Jetson (Nano, TX2 NX, Xavier NX, Xavier, ...). La version 0.2 se poursuivra en 2022 avec ceux qui auront passé le cap de la version 0.1 -

Lune Lune du 21/12/21 avec ED80 + Raspberry Pi 4 + caméra PI HQ

ms55 a répondu à un sujet de sebseacteam dans Astrophotographie

Il est possible d'installer Vulkan sur RPi4 pour accéder au calcul par le GPU. Ce sera sans doute plus facile avec le futur RPi5 qui devrait offrir plus de puissance. Cette camera ferait alors un bon oculaire électronique. 😉 -

Animation de Jupiter à partir de 2 images séparées de 20 minutes

ms55 a répondu à un sujet de ms55 dans Astrophotographie

C'est un algorithme qui utilise des primitives d'ArrayFire 3.9 pour mettre en œuvre un flot optique de précision. Il est intégré au logiciel "turbu" au même titre que les algorithmes permettant : - de créer une image de référence, - d'aligner les images brutes sur cette image de référence, - de fusionner les "lucky regions", - de réaliser une déconvolution aveugle adaptée à la turbulence atmosphérique (faible, normale ou forte). Le modèle de 2019 a été complété par l'ajout d'objets dynamiques (détection d'impacts sur Jupiter par exemple) comme dans la publication suivante qui n'est pas "temps réel" (voir figure 1 et table 1) : https://arxiv.org/pdf/2009.00071.pdf Sur 2 minutes, Jupiter peut être considéré comme une scène statique qui peut être traversée par des objets dynamiques (ombre d'un satellite ayant une vitesse de rotation supérieure, impact sur la planète, ...), le modèle retenu permet de traiter ces 2 aspects. Il est aussi utilisé dans le cas de la turbulence à longue distance avec des objets qui peuvent traverser la scène comme dans la publication ci-dessus. La différence avec les modèles existants c'est sa vitesse de traitement due à l'utilisation d'autres algorithmes dans un environnement GPU. Il me reste encore à peaufiner la déconvolution aveugle et à intégrer l'algorithme qui applique un modèle de dégradation aux images brutes en entrée. La fin est prévue pour la prochaine saison et cela devrait me permettre de sortir des images de Mars, Jupiter et Saturne en conditions de turbulence faible, normale et forte. Le logiciel "turbu" est actuellement en version 0.1, il est public sous Ubuntu 18.04 mais je n'ai pas vu beaucoup de vidéos produites avec lui (à part la douzaine que j'ai réalisé cet été), pour l'instant j'ai surtout lu des critiques qui ne font pas avancer le schmilblick. 😉 En 2022, il évoluera en version 0.2 qui intégrera un modèle de dégradation en entrée et ceux qui auront réussi à utiliser la version 0.1 pourront profiter de cette nouvelle version, les autres seront spectateurs. 😉 Tout cela sera expliqué sur le site "gpu-vision" qui est en cours de rédaction. Les 2 images fournies en entrée par Kant ont subit les inconvénients de WinJupos (artefact "ring" au niveau du bord et "œil de merlan" au niveau de l'ombre du satellite). L'autre inconvénient de WinJupos c'est qu'il ne gère pas les occultations (par exemple le passage de la GTR au bord de la planète). Je ferais à l'occasion un test 5 minutes avant le passage au bord de la planète (image1) et 5 minutes après (image 2). WinJupos ovalise aussi les satellites, ce qui gâche le résultat final. 🥲 -

Animation de Jupiter à partir de 2 images séparées de 20 minutes

ms55 a répondu à un sujet de ms55 dans Astrophotographie

Pas de soucis. 😉 -

Animation de Jupiter à partir de 2 images séparées de 20 minutes

ms55 a répondu à un sujet de ms55 dans Astrophotographie

Je lui ai envoyé hier l'animation en messagerie privée et s'il n'est pas d'accord, j'efface le sujet. 😉 -

Animation de Jupiter à partir de 2 images séparées de 20 minutes

un sujet a posté ms55 dans Astrophotographie

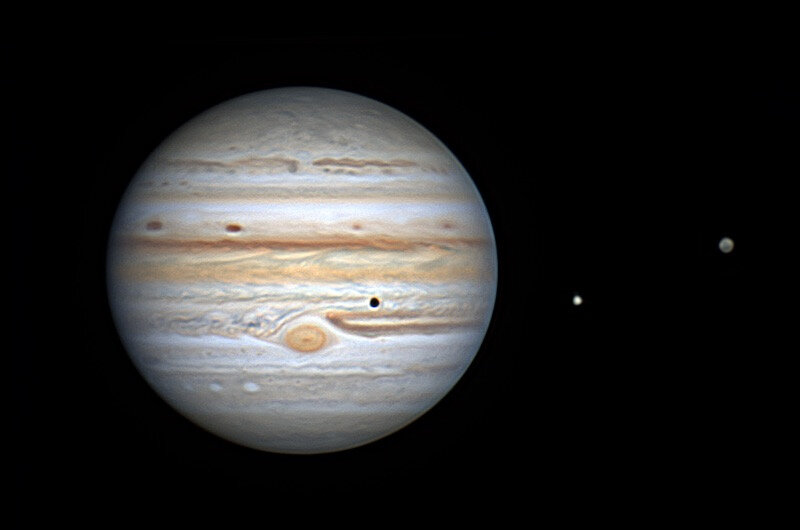

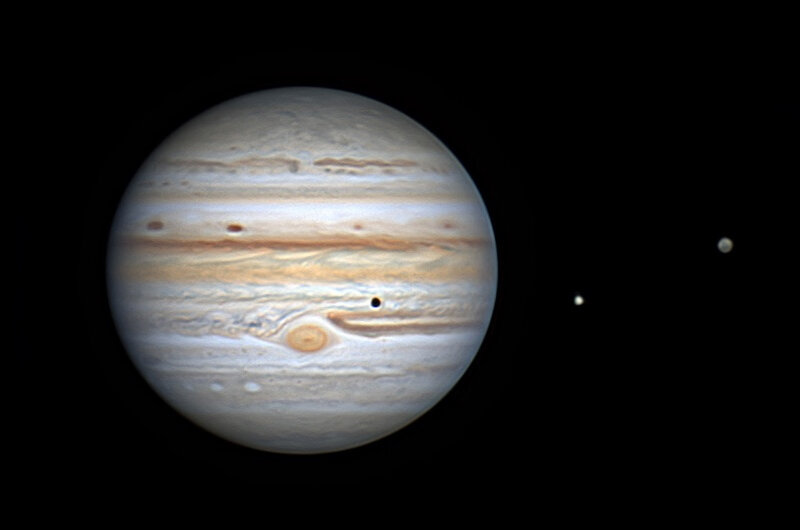

J'ai vu sur le forum d'à coté une animation obtenue à partir de 2 images de Jupiter prises par Kant à 20 minutes d'intervalles. J'ai refait le même genre de manip avec 2 images de Jupiter que j'avais pris le 11 août 2021 entre 2h04 et 2h24 TL : En fait pour faire une rotation complète de Jupiter avec la méthode présentée, il suffit de disposer d'une bonne image prise toute les 10 minutes (20 minutes c'est trop long) soit 6 images par heure ou 60 images en 10 heures. L'image prise toutes les 10 minutes peut elle aussi être une image créée avec le même algorithme qui ne donne pas d'artefact et/ou de satellite ovalisé comme Winjupos. A essayer lors de la saison 2022 avec Jupiter un peu plus haut en métropole. Enfin, le temps pour calculer les images intermédiaires est de l'ordre de quelques secondes avec une GTX 1050 Ti et il doit être encore possible d'optimiser. La version avec 3 images de Jupiter prises à 10 minutes d'intervalle et avec 3 images de même qualité (la déconvolution aveugle permet d'homogénéiser les 3 images) : PS : les images issues de Winjupos ne sont pas un bon choix en entrée car elles contiennent des artefacts sur le limbe et sur l'ombre des satellites. Ce qui n'est pas le cas avec l'algorithme utilisé ici. 😉 -

Jupiter le 21 décembre 2021 de 17h à 17h30 TL

ms55 a répondu à un sujet de ms55 dans Astrophotographie

J'ai l'impression que la dérotation basée sur un flot optique de précision fonctionne plutôt bien (le satellite ne s'ovalise pas et l'artefact "ring" n’apparaît pas sur le limbe) et vite (c'est quasiment en temps réel avec le GPU) : 😉 L'image obtenue en sortie de la dérotation (pas d'artefact et d'ovalisation du satellite) : En appliquant la dérotation à une fenêtre glissante de 3, 4, 5 (comme ici), 6, 7, 8 ou 9 images cela devrait permettre d'avoir une vidéo moins bruitée et mieux résolue. Dommage que le brouillard n'ait pas permis de faire cela, ce sera pour la prochaine fois. 😉 Et sur 8 (entre 17h09 et 17h25) en mixant avec 2 images de la Jetson Nano plus une image intermédiaire : -

Avant l'arrivée du brouillard à 17h30, un premier essai avec carte Jetson Nano 4GB (1 image à 17h10) et un deuxième essai avec GTX 1050 Ti (5 images à 17h15 + dérotation). C11@f/20+ASI462MC+EQ6-R Pro + logiciel "turbu version 0.1" 1) Jetson Nano 4GB : 2) PC portable avec GTX 1050 Ti : Dérotation des 5 images précédentes et léger renforcement : Ces tests ont été réalisés avec les versions sous linux pour Jetson (Nano et +) et PC (GTX 1050 Ti et +) du logiciel "turbu version 0.1". Je suis curieux de voir ce que d'autres astrams peuvent faire avec ce logiciel qui fonctionne avec des caméras ZWO ASI couleur (le monochrome n'est pas géré dans cette version). La soirée a tourné court au bout d'une 1/2 heure car le brouillard s'est brusquement levé.

-

Le 20 novembre 2021 au Taka "sortie de sa malle"

ms55 a répondu à un sujet de Ryo dans Astrophotographie

Impressionnant en effet avec de beaux détails dans la GTR. Je me suis permis un petit essai sur la première et sur la dernière qui est pas mal vu la hauteur :