Cyrille Thieullet

Membre-

Compteur de contenus

135 -

Inscription

-

Dernière visite

-

Jours gagnés

3

Visiteurs récents du profil

Le bloc de visiteurs récents est désactivé et il n’est pas visible pour les autres utilisateurs.

Cyrille Thieullet's Achievements

-

Connaitre son échantillonnage...ça sert à quoi ??

Cyrille Thieullet a répondu à un sujet de pyrou61 dans Astrophotographie

Bonjour, Il y aura deux types de dégradations possibles. La première : Une augmentation de la FWHM apparente. Ca se calcul avec la formule approchée suivante en ajoutant les dégradations de manière quadratique : FHWM finale= sqrt(seeing^2 + (FWHM suivi)^2 ) Et en considérant le RMS comme la déviation standard du suivi de la monture (moyenne des erreurs Ra et Dec égale 0) la formule est la suivante : FWHM suivi = 2.355 * RMS total Full width at half maximum - Wikipedia Cette personne a pris cette formule pour donner des équivalences FWHM et RMS: Guiding accuracy - Getting Started With Imaging - Stargazers Lounge La formule calcule une erreur maximale si la monture oscille parfaitement (osc = 0.5). Attention : si ce n'est pas le cas, le rms pourrait être plus élevé pour un impact moindre ou équivalent sur la FWHM ! Avec un RMS de 0.9 total en suivi c'est "équivalent" à une FWHM de 2.1''. Avec un seeing de 3 ca donnerait un seeing résultant de de 3.7. Avec un seeing de 2.5 ca donnerait un seeing final de à 3.3 Comme le souligne @Colmicplus le rms de la monture sera petit mieux ca sera 🙂 Question : entre un seeing de3.7 et un seeing de 3 en ciel profond et des poses longues, que va t'il rester une fois les empilements / sigma passés, les réductions d'étoile faites ou autres déconvolutions, les masques starless et autres ? Et puis c'est sans compter la mise au point, si mon instrument a un spot diagram un peu pâteux, de l'obstruction centrale, une collimation un peu à l'ouest, du tilt au niveau du capteur, de la courbure de champ visible sur le capteur, la buée, etc... ? La deuxième : une élongation des étoiles Ce qui compte c'est le ratio entre le rms RA et rms Dec. En visuel les étoiles restent "rondes" si leur rondeur est > à 90% de celle d'un cercle parfait. Un lien pour tester: Ellipse (desmos.com) Prendre la forme h,k et mettre 16 et 16*0.9, puis 16 et 16*0.85 pour comparer. Ca donne une idée de la valeur à mettre dans Siril par exemple pour faire un tri sur la rondeur. Sous PixInsight les étoiles sont considérées comme rondes avec un ratio d'excentricité de 0.42 je crois. C'est je pense calculé de la sorte : 1 - rmsMax(Ra,Dec)^2 / rmsMax(Ra,Dec)^2. Dans ton cas : ca ferait par exemple 0.7 rms ra et 0.53 rms dec pour un rms total de 0.9 environ ( racine(0.7^2 + 0.53^2) ) C'est sans compter le backslash en Dec, le mise en station approximative, les vibrations, les rafales de vent, les imperfections de l'entrainement, les flexions diverses, les câbles qui bougent, le chat qui se frotte à la monture, la buée sur la lunette guide, etc... Cyrille -

Bonsoir, Oui le réglement est important, le redire aussi, faire la police. Mais ca ne suffit pas apparement. En quoi donner accès à des prises electriques est d'une certaine manière un pousse au crime ? En quoi avoir accès à des prises electrique est d'ailleurs une nécessité en astro photo ? Pour faire comme à la maison ? Avec les même habitudes qu'à la maison ? A savoir : de la lumière plein pot quitte à péter une durite s'il me faut réduire l'impact de mon écran ? Ca a éte le pb de jeudi soir géré par François et Patricia. Et d'une certaine manière, la personne qui est sortie des clous a bénéficié de tout ce qu'il fallait pour sortir des clous aussi. Les RAP on est en famille ok. Mais c'est pas comme à la maison en termes de comportements , ni de commodités. Rien que la douche le matin me le rapelle. Il y a un risque de surcharge ou de départ de feu accru avec des rallonges utilisées en cascades ou étoiles avec N trucs branchées dessus (comme dans la tente d'entrée). J'ai vu un membre de l'orga EAP vouloir mettre les multiprises basiques qui trainaient par terre dans des sacs plastiques pour "éviter" les courcuits dans l'espace EAP. Sérieux les gars : au niveau sécurité vous auriez été malin si vous avez eu un pb de courcuits avec l'humidité ou une électrocution : J'avais mis le sac plastique, et c'était écrit dans le réglèment de pas trop brancher de truc. En plus on l'avait redis et fait la police ? C'est pas de ma faute M'sieur l'agent ! Cette année ca a été cool les RAP y a pas eu d'humidité. Et celle qui est arrivé jeudi soir a été ridicule. Pas de pluie non plus, ni de neige ou de chutes de grenouilles comme parfois. En quoi les contrôles sécurité que vous avez vous fait sur l' EAP vous couvraient au niveau assurance ou tout du moins vous assurez que votre assurance marcherait en cas de pépins ? Avec des enfants sur le terrains ? Ou du public néophyte le samedi soir qui déambule ? Réfléchissez y dans le cadre de ce que vous allez reprendre ou non pour l'année prochaine ;-) Y a du pénal derrière. Pour permettre d'allumer tranquillement une loupiote rouge sous un carton et risquer finir en cabane ? C'est un comble. Les RAP c'est bon enfant, tout le monde le sait. J'aime ce rassemblement pour cela. Sauf qu'en cas de pépins qui prend et assume ? Qui est prêt dans ceux qui "gèrait" l'EAP à "payer" pour ce genre dommages ? Normalement dans une asso c'est le président qui trinque en premier. C'est cool c'est pour François et c'est pas lui qui "gère" l'EAP. Il est possible que sans changement de cadre (prise electrique à disposition? Regroupement/Concentration?), rien ne limite réellement la puissance de ce que l'on branche, ni de ce que l'on utilise alors que la caméra fait ses poses car je n'ai pas de pb de batterie. Je peux rester sur mon écran, faire d'autres trucs en utilisant internet avec mon téléphone branché lui aussi, faire du traitement d'image, bref continuer à utiliser mon écran et ordinateur plein pot toute la nuit comme à la maison. C'est vrai, c'est super confort. De mon coté si c'est vraiment ce dont j'ai besoin pour faire de l'astrophoto c'est ok chez moi. C'est ma responsabilité. C'est de mon point de vue beaucoup moins compatible avec un rassemblement astro type RAP sur le terrain où nous sommes. Ouvert au public un soir. Vouloir l'offrir est un signe de générosité certe et en même temps l'asso en à elle les moyens techniques et logistiques ? Aussi si je ne peux pas gérer la frustration que cela m'engendre je peux choisir de rester à la maison pour faire cela ou de venir dans un autre mode aux RAP : Pour des raisons de vie commune, de sécurité tout simplement et parce que j'ai envie que les RAP durent encore 20 ans sans pépins électrique, sans avoir des copains et copines qui transpirent à l'idée d'aller en cabane pour m'offrir une concentration d'illuminations, à l'ascension, à Crapone autour de mon telescope. Plus de jus ? pas de jus ? en bas ? en haut ? carton ? bâche ? couete ? Tente ? Derrière la palissade ? batterie obligatoire ? Garde champêtre ? Gendarmettes ? Autres ? Je vous invite aussi à y réflechir. Bougez peut être aussi vos lignes, dites vous que c'est pour vote bien d'abord avant le notre ;-) Cyrille

-

Bonsoir, Alexandre : ta photo est je trouve exceptionnelle et je suis heureux que ces papillons soient encore là dans le biotope autour de Craponne :-). Chez moi j'ai parfois le bombyx de la ronce mais malheureusement plus grand chose qui vole la nuit en dépit d'une extinction à 22h. Merci à de gros spots LED d'une entreprise de BPT allumés toutes les nuits et des années de lampadaires... J'ai été heureux de retrouver de nombreux copains après 2 ans d'absence et très heureux aussi de me faire de nouveaux copains :-) Beaucoup de nouveaux/nouvelles, de débutant.e.s, de personnes qui ont découverts l'observation astro, d'enfants. Top ! J'ai eu aussi l'impression que pour certains c'était leur premier rassemblement et qu'ils ont découvert les richesses et contraintes communautaires d'un atroupement de ce type :-) J'espère que l'espace EAP dédié à la photo va évoluer l'année prochaine. J'y ai retrouvé des copains qui en ont bien profité. Habituellement, c'était plus mélangé ; ce qui obligeait ceux qui font de la photo à faire hyper gaffe à la lumière et prendre de grosse batteries. Pas toujours simple. Là je comprends la logique et en même temps faire une sorte deuxième rassemblement dans le rassemblement c'est aussi s'éloigner de l'esprit RAP. Et question lumière parasite, le premier soir ca a été la mega teuf dans cette zone. Et une grosse teuf les deux autres soir. En photo on se fout de la lampe rouge ou de l'écran de PC portable. Si ca avait un impact, ceux qui font de l'astro photo ils feraient gaffe. En visuel, un flash rouge et c'est 10 à 20mn pour récupérer après. Par exemple le 915 de Raphaël s'est retrouvé avec devant lui une forêt d'écrans bleu, de leds rouge qui s'agitent toute la nuit. Pas idéal pour garder sa vision nocture. Et ballot vu le potentiel de ce dobson. Si ce type de regroupement EAP est maintenu, personnellement je demanderais aux personnes : d'orienter leur écrans vers l'est, de réduire la luminosité, de placer un filtre rouge sur l'écran ou une couverture quand la sessions est lancée, de se regrouper vers le bas du terrain. Ou de venir se mélanger avec les autres histoire d'assouplir les oppositions éventuelles photo/visuel et favoriser le vivre ensemble. L'autre difficulté c'est que si je fais de l'astro photo avec "plein" de lumière écran, quand je vais déambuler ensuite pour aller faire de l'observation visuelle, ou rentrer à ma tente qui n'est pas dans la zone EAP, je vais mettre ma frontale rouge car je ne vois rien et je vais aller gaiement ruiner la vision nocturne des autres simplement en passant dans une allée libre ou mieux quand je vais aller leur demander si je peux regader dans leur télescope avec ma frontale que j'éteints à 2m pour pas me casser la gueule car je ne vois plus mes pieds sans lumière. Aux RAPs la nuit il n'y a normalement pas besoin de lumière pour se déplacer. Sauf si on est un peu "paf" ou si on a joué au papilon de nuit avec son smartphone, écran ou sa frontale pour pointer un NGC... Aussi y a eu beaucoup de gros papillons de nuit sur le terrain EAP cette année. J'aurais du prendre des photos comme Alexandre. Mais j'avais pas de flash avec moi ! Et puis il y en a aussi eu un ou deux qui pour se balader ou changer un oculaire ont préféré utiliser un feu de brouillard arrière de voiture sur leur tête en guise de lumière rouge. C'est vrai, on est jamais trop prudent, aux RAP c'est déjà arrivé le brouillard à la tombée de la nuit :-) J'ai eu aussi une personne venue regarder dans le clavius, avec son power tank Celestron à led bleu qui clignotait dans sa poche à 50cm de mon oeil quand j'ajustais la cible pour lui. Et son copain qui a allumé son smartphone grand écran, fond blanc, pour voir la photo de ce que nous allions observer juste avant. Bah, ca partait je pense d'une bonne intention :-) J'espère que tout cela va se caler tranquillement l'année prochaine avec un peu plus d'expériences partagées. En tous les cas un grand bravo à l'équipe d'organisation. Je vous admire pour votre engagement à nous offrir ce rassemblement depuis au moins 20 ans pour certain.e.s Perso j'en profite depuis 2004. Ca parait tellement simple tellement la mécanique est rodée. MERCI ! Cyrille

-

collimation du primaire par déplacement de la cage du secondaire

Cyrille Thieullet a répondu à un sujet de Fred13115 dans Les bricoleurs

Image 13 et 74 du diaporama les vis sont en extrêmité. Et ici pour l'arrière https://www.dietermartini.de/gittertuben.html C'est le même principe. Je crois que c'est du CP bouleau multiplis de 24mm. Pour se faire une idée pour la collimation, il suffit de passer aux RAP. C'est très efficace. Après y a pas besoin de grand chose sa construction étant bien faite. -

collimation du primaire par déplacement de la cage du secondaire

Cyrille Thieullet a répondu à un sujet de Fred13115 dans Les bricoleurs

Bonjour, Le lien vers le site du "Hollandais" qui s'appelle André ;-) http://www.astrosurf.com/aheijkoop/Equipment/24 inch Dobson/24 inch Dobson.html Les info quand il a ajouté la motorisation http://www.astrosurf.com/aheijkoop/Equipment/24 inch Dobson/24 inch f3.7 Encased GoTo Dobson.htm Le principe est d'utiliser 6 tubes avec des vis à pas droite et à pas gauche en haut et en bas. Comme cela en tournant les tubes cela fait reduire ou alonger la longuer des tubes et tilter la cage secandaire et cela permet la fin de la collimation. Dans son cas, le barillet 18 point en bois ( Dieter Martini ) supporte son 600m de 30kg avec 3 vis à l'arrière de collimation. Et il n'y a aucun astigmatisme et n'y touche jamais c'est stable (enfin je l'ai jamais vu ajuster à l'arrière après avoir fait ses 900km de voiture). https://www.dietermartini.de/gittertuben.html Aussi au passage cela démontre que faire des barillets en en acier c'est pas obligatoire pour un 600... Cyrille -

Montage Support encodeur Dobson

Cyrille Thieullet a répondu à un sujet de snake382 dans Les bricoleurs

Bonjour, Les encodeurs sont de dernière générationschez US digital et offrent 40000 pas de résolution (10000x4). Ca doit être la valeur indiquée en Alt et Az dans le nexus dans la section setup. Les fixations sont faites avec des coupleurs flexibles ce qui evite des torsions fortes au niveau de l'encodeur et permet aussi de rattraper une petite erreur de centrage. C'est idéal. Ca peut être utilisé aussi car la section des encodeurs est 1/4'' (indication 250) c'est pas du métrique. En plus car il n'y a pas de roulement dans les encodeur ( D ) ca veut dire tourner l'axe AZ à une vitesse raisonnable et pas brusquement ce qui pourrait faire perdre des pas. Pour l'axe Az, il faut s'assurer que l'encodeur est parallèle au plat alu traversant. Lui doit être percé au centre. Il faut juste placer l'encodeur au dessus. Quitte à mettre quelquess cales à l'endroit du sérrage où à desserer / resserer le coupleur pour assurer le paralèlisme. Maintenant, l'encodeur a peut être était placé un peu surbaissé pour permettre le passage de la cage du primaire. A tester si ca gêne au niveau précision. Normalement avec le coupleur flexible c'est ok d'avoir un peu de tilt. si ca gêne, mais je serais surpris, dans ce cas il faudrait prendre un plat et faire un support avec un angle au niveau de la fixation pour descendre de l'épaisseur du bois et aller au dessus du centre. Cyrille -

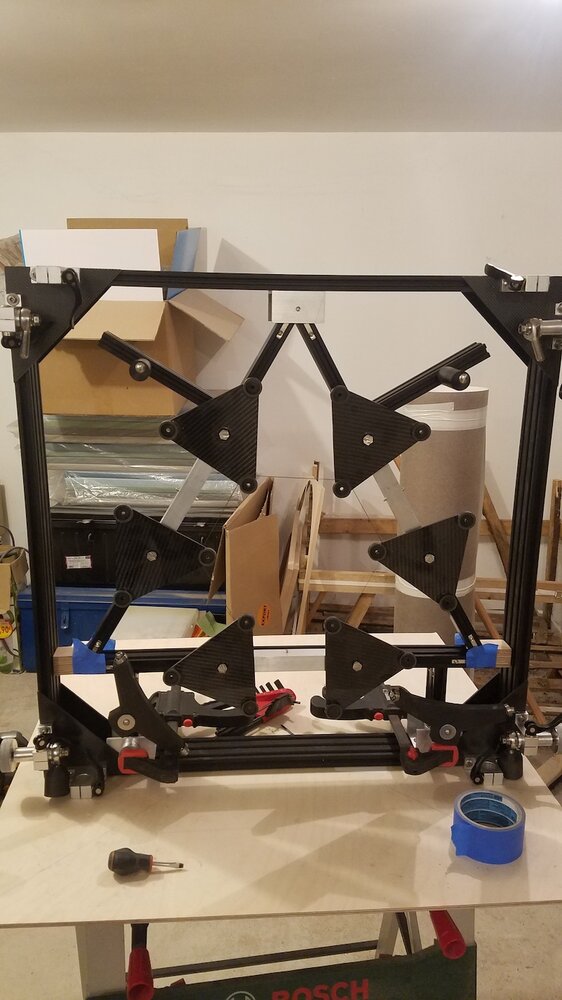

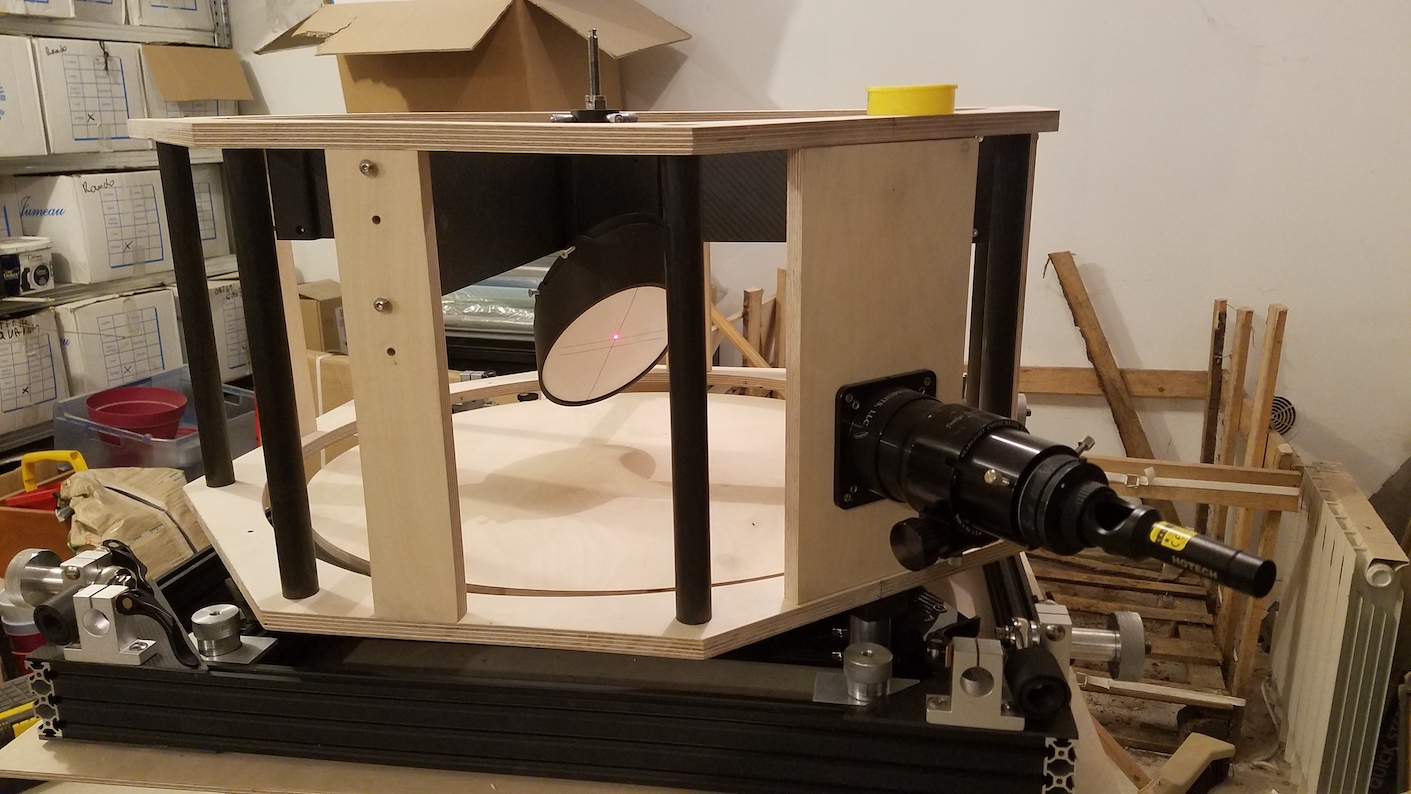

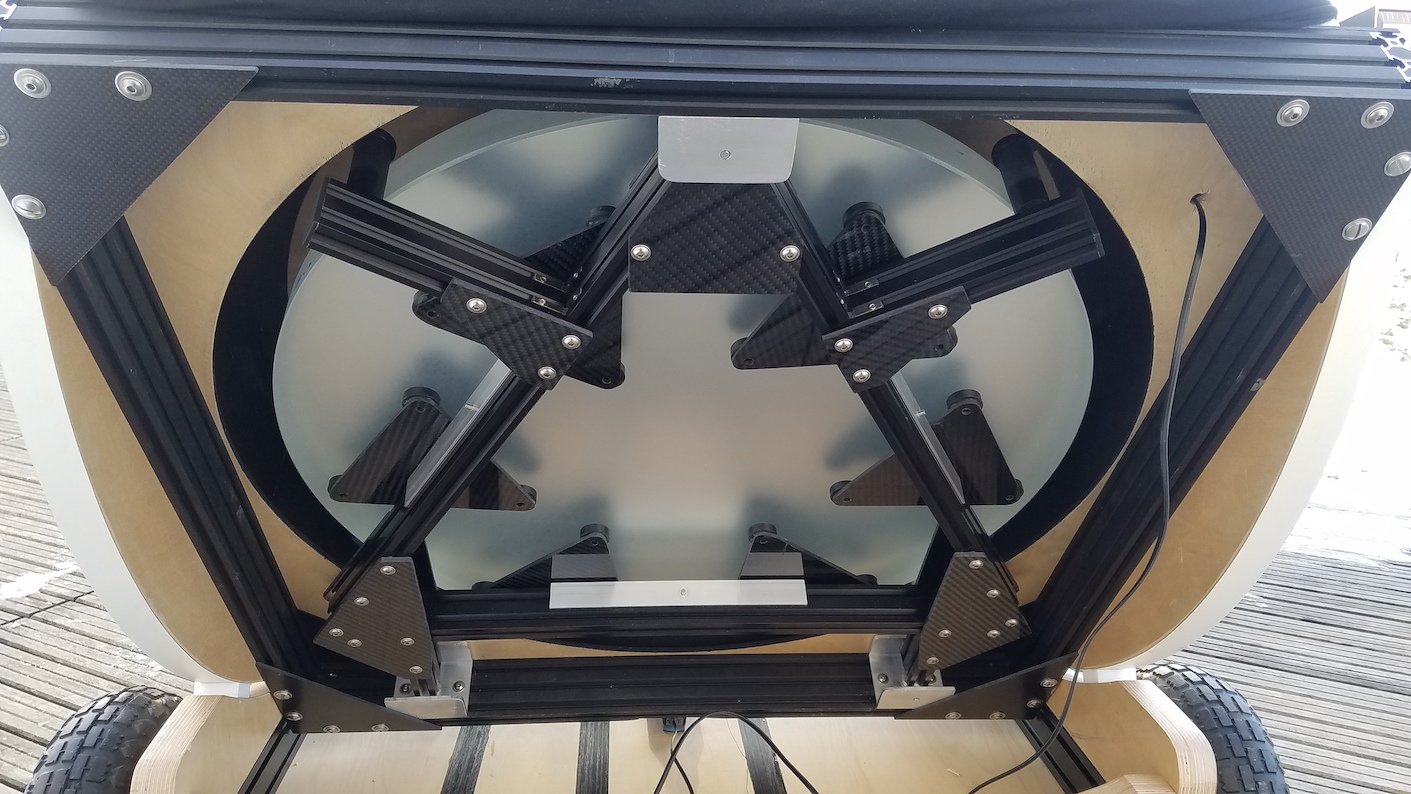

Bonjour, Pour partager la réalisation mon dernier dobson 🙂 J'ai profité d'une "solde" chez M. Lockwood sur un mirroir de 24 pouce F3.3 "léger" de 21kg avec le secondaire. J'ai démarré la construction fin octobre. J'ai choisi d'utiliser des profilés Alu VSlot. Avant j'avais fait des dobsons en peuplier découpé au laser. Là c'était trop grand pour demander à mon artisan préféré de faire les découpes. Je voulais éviter les découpes au maximum et surtout pouvoir positionner comme je voulais les différentes pièces car j'avais fait des plans très généraux et pas vraiment précis pour les inserts. La réception des pièces découpées : J'ai acheté le bois chez Auprotec. Le gros avantage c'est qu'il peuvent découper des disques et qu'ils les envoient dans la chute de découpe. Aussi pour les tourillons et la base c'est parfaitement circulaire à l'extérieur. Et j'ai pu utiliser la chute de découpe des tourillons pour faire les coté du rocker ! J'ai aussi utlisé des pièces imprimées pour le support du secondaire et les cales lattéralles du primaire. J'ai utilisé du PTEG+Carbone. J'ai eu beaucoup de déchets avant d'y arriver. Et à la fin j'ai du acheter une autre imprimante : une creality CR 10 S Pro. Elle est parfaite. Il faut une buze de 0.6 et chauffer à 250. J'ai imprimé aussi un secondaire à la bonne taille pour faire tout le système de support du secondaire. Ca m'a permit aussi de centrer le PO au secondaire à une erreur pronfeur près qui m'a obligé de décoller les supports lattéraux une fois vernis et collés... Le barillet est un 18 points. Il a été renforcé avec des triangles de carbone aux jonctions. La collimation se fait par le bas avec une une rotule en bout J'ai usiné au tour les cones des tubes et les diverses vis moletées. J'ai utilisé une tige filetée aux deux bouts en titane (utilisé pour les roues de moto) comme axe pour le secondaire pour réduire le poids. Elle est vissée/collé dans le support du secondaire et bloqué par le dessus par une vis molettée creuse. J'ai piquée l'idée à Franck Grière. C'est pas parfait car le secondaire est lourd et tourne un peu à la collimation. Mais une fois les 4 vis micrométriques callées ca bouge plus. Une fois bien avancé avec les encoders. J'ai fait au plus simple avec les tourillons : un demi cercle. C'est bien trop grand, plus lourd mais ca permet d'utiliser un profilé U alu qui étant en appuis sur les V des tubes carbone du coté rigidifie les tourillons en lattéral : Aucun flex. Et pour placer l'encoder Alt c'est simplissime. en plus les cables se cachent dans le U. L'arrière et le devant J'ai suivi les conseils de M. Lockwood pour le correcteur de Coma et j'ai pris un SIP que j'ai trouvé d"occasion. Ca m'a permit de viser une roue à filtre en sortie. Je trouve que c'est esthétique et très pratique. Le dobson doit peser autour de 55kg en ordre de marche et sans les roues. il doit bien y avoir 5kg de vis et boulons.... Sur le ciel ca fait un vraiment gros changement....Le mirroir est nickel. Et il n'y a aucun astigmatisme. Reste maintenant les finitions 🙂 Cyrille

- 36 réponses

-

- 29

-

-