-

Compteur de contenus

959 -

Inscription

-

Dernière visite

-

Jours gagnés

4

Type de contenu

Profils

Forums

Téléchargements

Blogs

Boutique

Calendrier

Noctua

Tout ce qui a été posté par keymlinux

-

SIRILIC 2.0.0

keymlinux a répondu à un sujet de m27trognondepomme dans Logiciel SIRILIC de Siril et Sirilic

Bonjour, Dans ton pdf il apparaît un critère de conservation de 90% des images en manuel, mais ce paramètre n’est pas utilisé avec sirilic. La différence est peut être là ( sachant que 64 c’est environ 90% de 72) -

Tech Bug à l'installation de SiRiL 1.4.1 sous Linux Mint 22.2 (Zara)

keymlinux a répondu à un sujet de kinlougha dans Logiciel SIRIL de Siril et Sirilic

Bonjour, A ce jour il y a toujours une incompatibilité de librairies entre Siril et Kstars , et le problème est du côté de Kstars avec une librairie propriétaire qui vient poser des problèmes de dépendances avec la librairie de la distribution linux (qui elle est utilisée par Siril) Donc pour le moment c’est Siril ou Kstars sur une distribution basée sur une Ubuntu note: je n’ai pas testé avec des versions packagées de Siril type app image ou flatpak pour voir si cela permet de faire abstraction des dépendances (dans ce type de paquet on a l’appli et les librairies nécessaires, pour ne pas dépendre de celles installées sur l’OS Je teste dès que je rentre de Norvège 🌈(pas trouvé de smiley pour les aurores boréales) @rmor51 a peiori toi aussi tu avais le problème avec cette librairie Cordialement -

Panneau a flat et temps de poses avec filtres SHO

keymlinux a répondu à un sujet de bemo dans Matériel général

Bonjour, @bemo Cela est certainement dû au fait que ton écran flat n'a pas une emission homogène dans toutes les longuers d'ondes, et c'est un peu normal en fonction de la techno utilisée Par exemple, avec des LEDs on a souvent une dominante dans le bleu, et très peu de luminosité dans le rouge, hors le filtre Ha, en plus d'être selectif l'est dans le rouge profond (vers 656nm de mémoire), donc là où les LEDs blanches ne sont pas à la fête Avec un filtre L tu prend tout le spectre visible donc c'est là que tu aura le plus de flux donc le temps de pose le plus court Avec les filtres RGB, tu aura moins de flux mais ce sont des filtres larges (plusieurs centaines de nm) donc des temps de poser acceptables Avec les filtres Ha, Oiii et Sii, ils sont très sélectif donc le flux sera faible et le temp de pose plus important. Le Oiii s'en sortira mieux car il est positionné sur le bleu/vert où les LEDs génèrent quand même pas mal de flux, mais le Ha et le Sii, positionnés sur le rouge seront à la rue Voir le sujet suivant où je parle de ce soucis avec mon écran à flat bricolé Cordialement -

Sirilic 2.0.0 Release Candidate 1

keymlinux a répondu à un sujet de m27trognondepomme dans Logiciel SIRILIC de Siril et Sirilic

Je pense qu'il faudrait aussi l'ajouter dans la boite de dialogue pour la configuration des options de la session, pratique pour ceux qui font le choix d'avoir des options différente pour chaque session (à toi de voir si tu veux conditionner l'affichage du nom de session à l'état booléen de l'option en question) -

Sirilic 2.0.0 Release Candidate 1

keymlinux a répondu à un sujet de m27trognondepomme dans Logiciel SIRILIC de Siril et Sirilic

Mais c'est bien le cas on a l'avertissement à l'ouverture d'un ancien projet et pas systématiquement à chaque ouverture du soft. Par contre lorsque l'on lance Sirilic il recharge le dernier projet ouvert. Si tu a eu l'avertissement lors du lancement c'est que le dernier fichier projet chargé était en v1, cela va disparaitre une fois que tu aura converti le projet et ouvert le v2 --> au prochain lancement il ouvrira le projet v2 et tu n'aura plus le message. En tout cas c'est le comportement que j'observe. Si de ton coté tu est questionné sur le conversion à chaque lancement je comprend que c'est un peu galère. EDIT: je viens de vérifier, et si le fichier de config de sirilic contient dans son entrée 'last_project': le nom d'un fichier qui est au format v1 alors tu est questionné sur la conversion. Une fois que le fichier qui est indiqué dans cette entrée est au format v2 tu n'est plus questionné (tu ne le seras qu'a la prochaine tentative d'ouverture d'un autre fichier v1) note: sur macOS ce fichier de config est nommé ".sirilic_rc", dans le répertoire racine de l'utilisateur. Cordialement -

Sirilic 2.0.0 Release Candidate 1

keymlinux a répondu à un sujet de m27trognondepomme dans Logiciel SIRILIC de Siril et Sirilic

Ben non, le but c'est bien d'être prévenu que le projet que l'on charge n'est plus compatible et de proposer une conversion. Ce que tu souhaites c'est que cela fasse la conversion automatiquement sans prévenir ? je pense que cela n'est pas souhaitable C'est mon avis perso, vous avez le droit de ne pas être d'accord 😉 Cordialement -

Sirilic 2.0.0 Release Candidate 1

keymlinux a répondu à un sujet de m27trognondepomme dans Logiciel SIRILIC de Siril et Sirilic

Bonjour, J'ai un comportement bizarre suite à la conversion d'un projet avec la RC5 La manip: - je lance Sirilic en mode expert - je créé un nouveau projet pour l'objet M1 (pour être sur d'être en projet v2.0) - les boites de dialogues "add files" et "configure" peuvent être ouvertes normalement - j'ouvre un projet pour IC_1848 qui est ancien, cela me propose la conversion, que j'accepte, et j'enregistre le nouveau fichier généré - mais par contre je constate que le projet affiché est toujours le précédent pour M1 (il y a eu conversion mais pas chargement du projet converti) - mais surtout, si je tente d'ouvrir les dialogues "and files" ou "configure" pour le projet M1 toujours chargé j'ai un message d'erreur (alors que ce projet est un projet v2) note: j'ai testé la re-exécution de mon projet avec Ha+Oiii et Sii+Oii avec drizzle x2 et composition HOO et SOO, cela fonctionne parfaitement 17:09:03: Exception in Tkinter callback 17:09:03: Traceback (most recent call last): 17:09:03: File "/Applications/Siril.app/Contents/Frameworks/Python.framework/Versions/3.12/lib/python3.12/tkinter/__init__.py", line 1968, in __call__ 17:09:03: return self.func(*args) 17:09:03: ^^^^^^^^^^^^^^^^ 17:09:03: File "/Users/stephane/Downloads/App/sirilic/Expert.py", line 197, in cbConfigure 17:09:03: dlg=CPropertiesDlg(parent=self,imagedb=imagedb, prjprop=prop, icon_path=ICON_PATH) 17:09:03: ^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^ 17:09:03: File "/Users/stephane/Downloads/App/sirilic/gui/DlgProperties.py", line 1047, in __init__ 17:09:03: iodf = self.imagedb['Images'][IMAGE] 17:09:03: ~~~~~~~~~~~~^^^^^^^^^^ 17:09:03: TypeError: 'NoneType' object is not subscriptable 17:09:06: Exception in Tkinter callback 17:09:06: Traceback (most recent call last): 17:09:06: File "/Applications/Siril.app/Contents/Frameworks/Python.framework/Versions/3.12/lib/python3.12/tkinter/__init__.py", line 1968, in __call__ 17:09:06: return self.func(*args) 17:09:06: ^^^^^^^^^^^^^^^^ 17:09:06: File "/Users/stephane/Downloads/App/sirilic/Expert.py", line 225, in cbAddImages 17:09:06: files = shdata.idb.Files(keystr) 17:09:06: ^^^^^^^^^^^^^^^^^^^^^^^^ 17:09:06: File "/Users/stephane/Downloads/App/sirilic/lib/database.py", line 224, in Files 17:09:06: return self.db[keystr].Files(files) 17:09:06: ~~~~~~~^^^^^^^^ 17:09:06: KeyError: 'M1/L/S-01' EDIT: dans l'ancienne version de Sirilic, il y avait une synthèse générée dans la low à la fin, c'était bien pratique, mais cela a disparu avec la version 2.0. C'est voulu, lié a une contrainte technique ou bien c'est un oubli ? ################################################################################ Synthèse: [1] NGC_2244/RGB/20240111a: offset ... * Rejet des pixels dans le canal #0 : 0.413% - 0.690% * Estimation du bruit (canal : #0) : 0.872 (1.331e-05) [2] NGC_2244/RGB/20240111a: offset, dark ... * Rejet des pixels dans le canal #0 : 0.467% - 0.813% * Estimation du bruit (canal : #0) : 0.559 (8.529e-06) [3] NGC_2244/RGB/20240111a: offset, dark, flat ... * Rejet des pixels dans le canal #0 : 0.272% - 0.274% * Estimation du bruit (canal : #0) : 13939.593 (2.127e-01) [4] NGC_2244/RGB/20240111a: offset, dark, flat, image ... [5] NGC_2244/RGB/20240111a: offset, dark, flat, image, register ... * Total : 0 en échec, 120 alignées. * Total : 0 en échec, 120 exportées. [6] NGC_2244/RGB/20240111a: offset, dark, flat, image, register, stack ... * Rejet des pixels dans le canal #0 : 0.142% - 0.729% * Rejet des pixels dans le canal #1 : 0.110% - 0.690% * Rejet des pixels dans le canal #2 : 0.187% - 0.879% * Estimation du bruit (canal : #0) : 2.853 (4.354e-05) * Estimation du bruit (canal : #1) : 3.340 (5.097e-05) * Estimation du bruit (canal : #2) : 2.296 (3.504e-05) ################################################################################ Cordialement -

Sirilic 2.0.0 Release Candidate 1

keymlinux a répondu à un sujet de m27trognondepomme dans Logiciel SIRILIC de Siril et Sirilic

Bonjour, et tout mes voeux pour cette nouvelle année, Je viens de tester, pas de soucis rencontré idée jetée en l'air: - ne serait il pas judicieux d'ajouter dans le fichier projet une balise de version ("version=2.0" par exemple), et lors de l'ouverture d'un fichier projet, si la balise de version est manquante ou indiquant une version inférieure à celle souhaitée (pour les évolutions futures) d'émettre un message d'avertissement pour les utilisateurs les invitant à convertir leur fichier projet au préalable - un peu comme le paramètre "requires" de siril, qui permet d'avoir une erreur si on utilise un script trop vieux Cordialement -

Bonjour Pierre, Le site est souvent cité (et affilié) par les blogueurs spécialisés en photographie et semble jouir d'une bonne répuation, ils expédient quasiment dans le monde entier. Par contre c'est une boutique aux US, donc il faut ajouter le frais de ports (DHL ou FEDEX au choix), et les taxes d'importation en France. Tu peux avoir une simulation du coût avec transport et taxes en mettant un produit dans le panier. De plus, même si le site te permet d'afficher une estimation du prix en euros, la facturation et la transaction se font en dollars US, donc quelques frais de change en plus seront appliqués par ta banque. Cordialement, Stéphane

-

Sirilic 2.0.0 Release Candidate 1

keymlinux a répondu à un sujet de m27trognondepomme dans Logiciel SIRILIC de Siril et Sirilic

Cela fonctionne parfaitement Thème clair Thème sombre precision: - la gestion du thème n'est pas traitée dynamiquement (c'est e cas sur certains softs) , mais cela ne pose pas de problème car les 2 cas sont bien lisibles (noir sur gris clair ou blanc sur gris foncé) - par dynamiquement j'entend par là que certains softs s'adaptent immédiatement si un utilisateur change le thème dans les options du Mac (cela peut aussi arriver hors du contrôle de l'utilisateur si il a choisir l'option "auto", alors cela s'adapte à des conditions horaires). Par non dynamiquement j'entend qu'il faut relancer le script de Sirilic pour s'adapter au nouveau thème. Tout cela pour dire que ce n'est pas important mais pour que tu saches dès fois qu'un utilisateur de Mac te fasse la remarque EDIT: et n'oublie pas de lâcher le clavier pour le réveillon 😉 -

Sirilic 2.0.0 Release Candidate 1

keymlinux a répondu à un sujet de m27trognondepomme dans Logiciel SIRILIC de Siril et Sirilic

Je viens de télécharger et tester le build 46f25906 Toujours le même soucis d'aide contextuelle en blanc sur gris clair avec le thème sombre -

Sirilic 2.0.0 Release Candidate 1

keymlinux a répondu à un sujet de m27trognondepomme dans Logiciel SIRILIC de Siril et Sirilic

Pas d’effet visible -

Sirilic 2.0.0 Release Candidate 1

keymlinux a répondu à un sujet de m27trognondepomme dans Logiciel SIRILIC de Siril et Sirilic

@bou-fon Il faut désactiver la compression côté sirilic via le bouton « global préférence » dans l’interface « expert » -

Sirilic 2.0.0 Release Candidate 1

keymlinux a répondu à un sujet de m27trognondepomme dans Logiciel SIRILIC de Siril et Sirilic

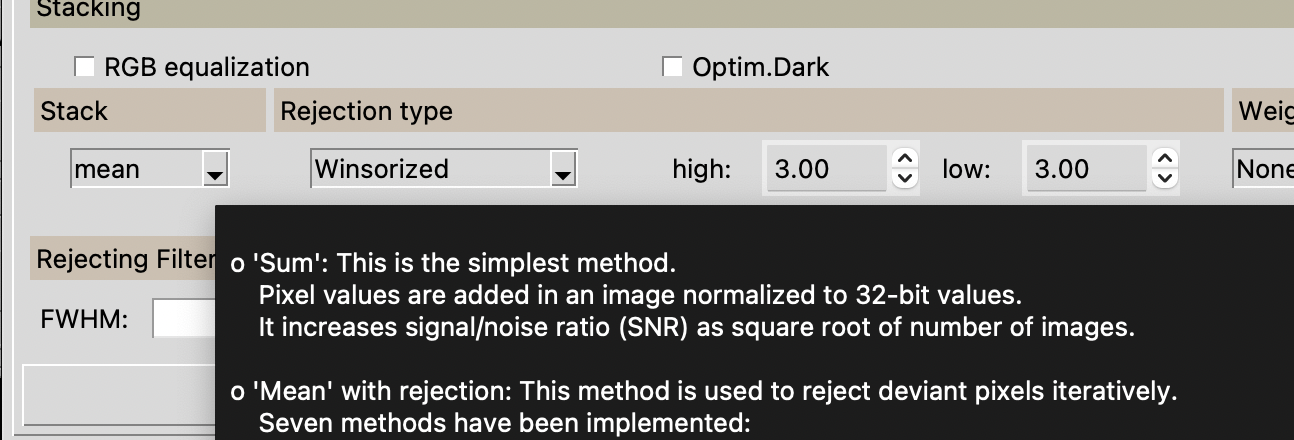

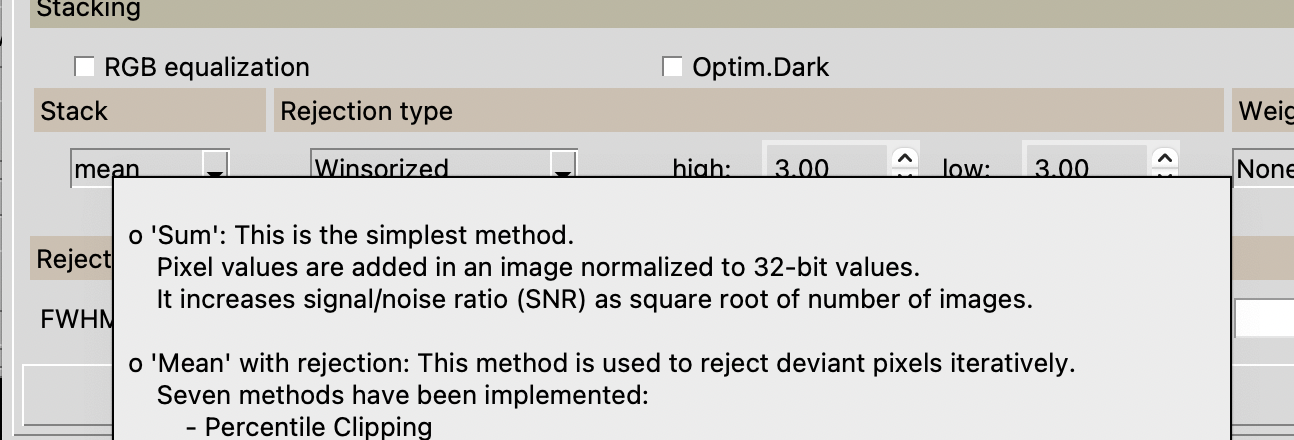

J'utilise le thème "default". Mais avec les autres thèmes j'ai le même soucis sur le aides contextuelles. En plus avec certains themes c'est aussi écrit en blanc sur fond gris sur le contenu de champ de saisie exemple, thème default (seule l'aide pose problème) exemple thème élégance (ici même les champs a saisir sont en blanc sur gris, mais comme le gris est plus foncé cela passe) EDIT: surf le Mac il y a un affichage au choix avec ton clair ou sombre avec le ton clair l'aide contextuelle est écrit en noir su gris clair avec le ton sombre j'ai du blanc sur gris clair, au lieu d'avoir du blanc sur gris foncé version ton clair -

Sirilic 2.0.0 Release Candidate 1

keymlinux a répondu à un sujet de m27trognondepomme dans Logiciel SIRILIC de Siril et Sirilic

Bonjour, C'est faisable. En fait c'est nécessaire, car si l'on ne spécifie pas ces options (scale=2 et pixfrac=0.5) avec l'option drizzle alors on a pas une image doublée en résolution A ce propos, il y a un effet de bord: - sur mon traitement de couches HaOiii et SiiOiii - si (comme moi) on a forcé la focale et le pixel size pour le findstar, alors c'est enregistré dans les options du setfindstar - si l'on utilise un drizzle scale=2 lors du register des images sources, le findstar fonctionne bien, et en sortie les images sont doublées en résolution - le problème c'est à la fin du script, après le compositions HOO et SOO, le script généré tente un register sur la sequence C- (les couches Ha, Sii et Oiii, cette dernière étant en double) --> cette séquence est constituée d'images doublées en résolution, donc le register échoue car la detection d'étoiles n'est pas correcte avec les paramètres focale/pixelsize courants (qui permettent de calculer l'échantillonnage) --> si je fais un "setfindstar reset" (pour supprimer le forçage de la focale/pixel size) avant le register de cette sequence C- alors cela fonctionne. Peut être faudrait il générer un reset des paramètres du findstar dans le script juste avant le register de la séquence C- --> en fait comme on veut juste supprimer les paramètres qui dependent de la résolution, comme "radius", "focale" et "pixel size", il faudrait faire un reset mais aussi redéfinir les autres options qui ont été forcées (dans les options de la section "star finding") et qui restent valables Tu n'est pas tout seul, personnellement je garde toutes mes images (lights et DOF) et les fichiers projets Sirilic, pour tenter de nouveaux pré-traitements et traitements avec les évolutions de Siril. Et effectivement c'est aussi utile si on reviens imager une cible pour ajouter du signal en multisession EDIT: petit soucis aussi, les aides contextuelles (qui s'affichent lorsque l'on passe le curseur de la souris sur certaines options), l'aide s'affiche systématiquement (quelquesoit le theme choisi) écrit en blanc sur fond gris clair, très peu lisible. Cordialement -

Sirilic 2.0.0 Release Candidate 1

keymlinux a répondu à un sujet de m27trognondepomme dans Logiciel SIRILIC de Siril et Sirilic

Effectivement, je n'ai le problème qu'avec les anciens fichiers projets. D'ailleurs en créant un nouveau projet et en tentant d'ajouter des fichiers j'ai eu un nouveau soucis, voir mon post précedent que j'ai édité (pile au moment où tu postait une réponse..) EDIT: j'ai fait un nouveau projet avec 2 couchers HaOiii et SiiOiii Lors du traitement de la couche HaOiii cela génère au final une image composition HOO via la commande suivante: # HOO compositing rgbcomp ../cHaO3_Ha ../cHaO3_O3 ../cHaO3_O3 -out=../../../final_HaO3_O3_HOO Mais lors du traitement de la couche SiiOiii, la composition est notée HOO au lieu de SOO Si on sait que l'on traite la couche cS2O3 ne serait il pas plus judicieux de nommer cela composition SOO et de générer un fichier nommé SOO ? # HOO compositing rgbcomp ../cS2O3_S2 ../cS2O3_O3 ../cS2O3_O3 -out=../../../final_S2O3_O3_HOO Cordialement -

Sirilic 2.0.0 Release Candidate 1

keymlinux a répondu à un sujet de m27trognondepomme dans Logiciel SIRILIC de Siril et Sirilic

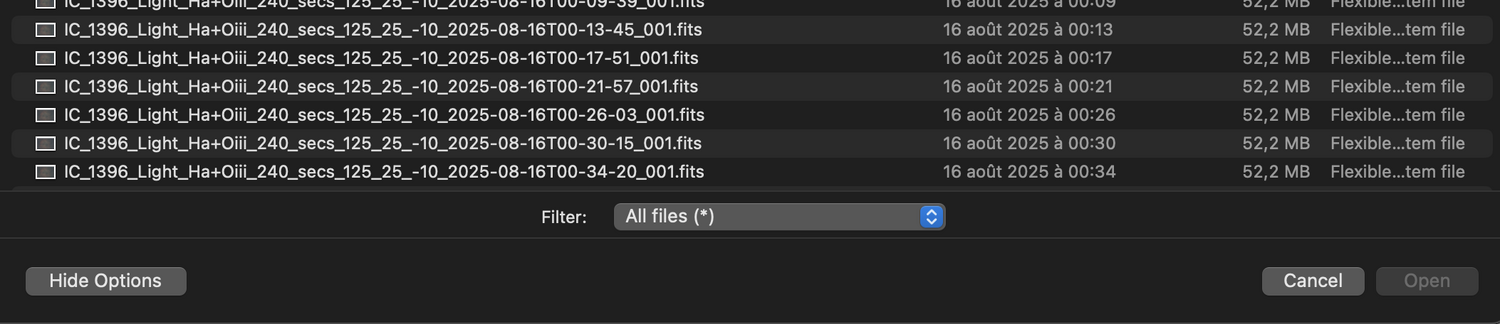

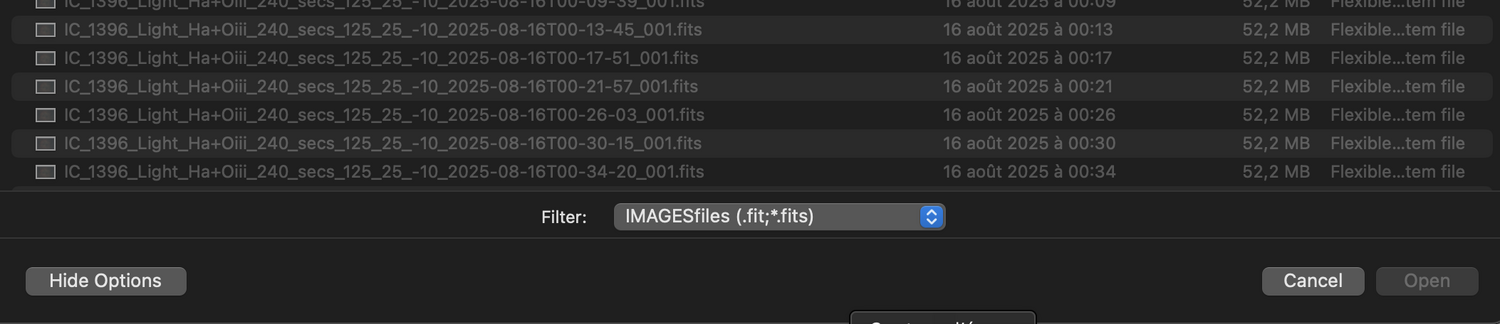

J'ai testé la RC3 - j'ai toujours le soucis dans la fenêtre de mise à jour de la session (bouton update), le champ session name reste vide et le nom de la session apparait dans le champ session number (voir copie d'écran dans mon poste précédent) - pour ls autres soucis c'est OK Par contre quelques autres soucis détectés: - la fenêtre du débugueur pas à pas n'est pas redimensionnable (à moins que cela ne soit par par choix) - dans l'éditeur de script, les numéros de ligne ne sont pas liés au texte (je peux faire defiler (avec l'equivalent de la molette de la souris) la colonne des numéros de lignes séparément à la colonne qui contient le code. Si on utilise l'ascenseur à droite cela fait defiler le code seulement. - dans le même éditeur de script, la fonction "go" pour aller à un numéro de ligne semble ne pas fonctionner EDIT: autre soucis lors de l'ajout de fichier à une session, aucun problème si on fait du drag&drop par contre si on "browse" des repertoires pour sélectionner des fichiers, avec la paternité de recherche par défaut "*.fit;*.fits" cela ne permet pas la selection des fichiers concernés (les fichiers .fits sont grisés), je doit sélectionner le pattern "*.*" pour les dégriser et les selectionner Ci dessous fichiers non sélectionnables et sélectionnables avec le paternel *.* Cordialement -

Sirilic 2.0.0 Release Candidate 1

keymlinux a répondu à un sujet de m27trognondepomme dans Logiciel SIRILIC de Siril et Sirilic

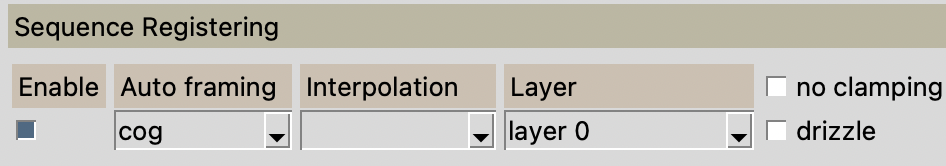

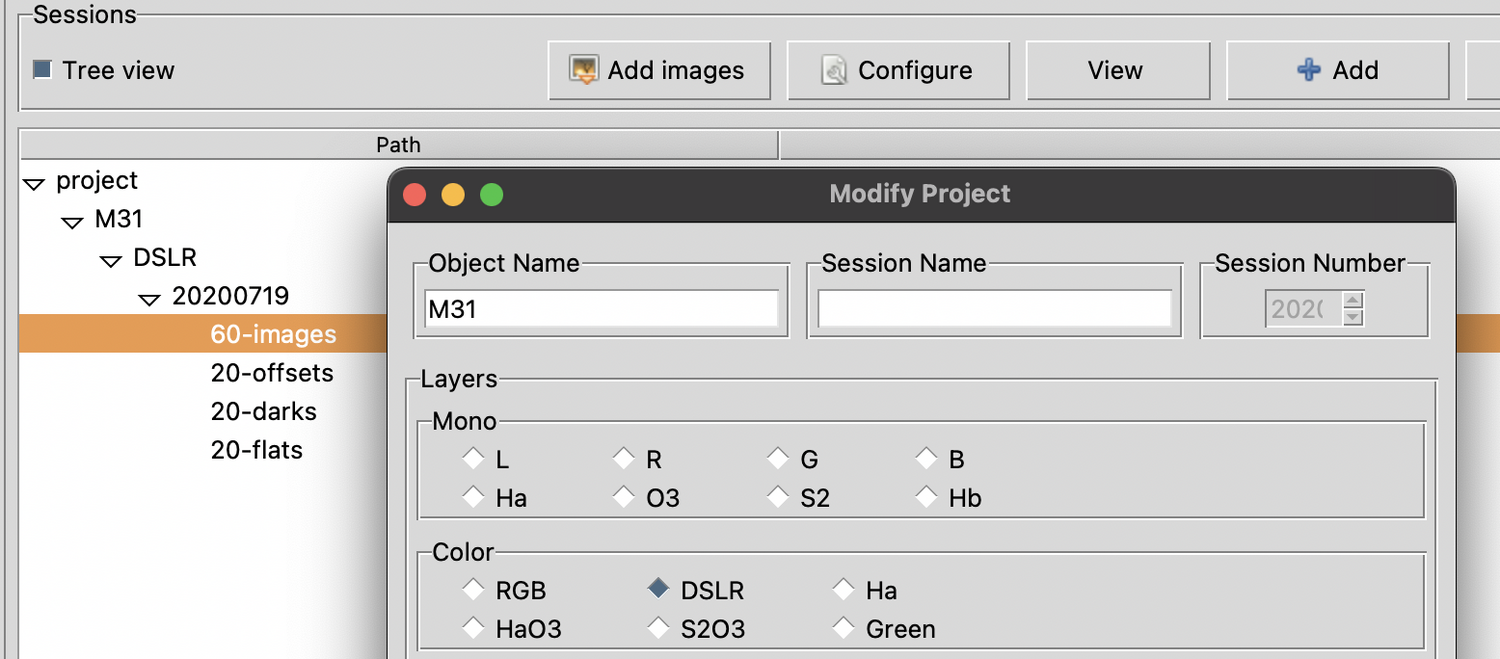

Joyeux Noël 🎁 Bon OK, ce n'est pas le jour pour debuguer des scripts, mais bon, on s'occupe un peu... J'ai testé la nouvelle version. Merci pour la correction des soucis précédents. J'ai noté 3 (nouveaux) soucis (script expert) 1) dans la configuration de la session, partie "more properties", si on enable l'option "sequence registering", même si on ne coche pas l'option drizzle celle ci est ajoutée en paramètre dans le script ce qui est généré dans le script: seqapplyreg bkg_pp_images -drizzle -framing=cog -layer=0 d'où une erreur lors de l'execution du script (je peux fournir tout le script si besoin et le fichier projet) 9:54:54: seqapplyreg bkg_pp_images -drizzle -framing=cog -layer=0 19:54:54: Exécution de la commande : seqapplyreg 19:54:54: Cette séquence n'est pas monochrome / CFA, Drizzle impossible. 19:54:54: L'exécution de la commande a échoué : arguments non valide. 19:54:54: Abort : Command 'seqapplyreg bkg_pp_images -drizzle -framing=cog -layer=0' failed: Argument error 19:54:54: seqapplyreg bkg_pp_images -drizzle -framing=cog -layer=0 2) si j'affiche les sessions en mode "treeview" lorsque je sélectionne le bouton "update" pour modifier une session, le nom actuel de la session n'apparait pas dans le champ "nom" mais dans le champ "sequence number" Si par contre je ne suis pas en mode "Treeview", lorsque je sélectionne la session et que j'utilise le bouton "Update", j'ai le message d'erreur suivant (je pense que ici aussi c'est du au fait que mon nom de session ne contient que des chiffres et est identifié comme étant un "int" et pas un "str") 0:10:45: Exception in Tkinter callback 20:10:45: Traceback (most recent call last): 20:10:45: File "/Applications/Siril.app/Contents/Frameworks/Python.framework/Versions/3.12/lib/python3.12/tkinter/__init__.py", line 1968, in __call__ 20:10:45: return self.func(*args) 20:10:45: ^^^^^^^^^^^^^^^^ 20:10:45: File "/Users/stephane/Downloads/App/sirilic/Expert.py", line 114, in cbUpdate 20:10:45: if re.search(r'\d+$',session_no) : 20:10:45: ^^^^^^^^^^^^^^^^^^^^^^^^^^^^^ 20:10:45: File "/Applications/Siril.app/Contents/Frameworks/Python.framework/Versions/3.12/lib/python3.12/re/__init__.py", line 177, in search 20:10:45: return _compile(pattern, flags).search(string) 20:10:45: ^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^ 20:10:45: TypeError: expected string or bytes-like object, got 'int' 3) J'ai testé le mode pas à pas pour le lancement du script. A priori sur MacOs le click droit pour changer le statut d'une ligne n'est pas détecté (sachant qu'avec le trackpad d'un macbook le click gauche se fait en tapant avec 1 doigt et le click droit avec 2 doigts) Je pense que le problème ici est plus lié au code du module "Tkinter" qui gère l'interface graphique qu'à ton propre code. Cordialement, Stéphane -

Sirilic 2.0.0 Release Candidate 1

keymlinux a répondu à un sujet de m27trognondepomme dans Logiciel SIRILIC de Siril et Sirilic

A priori value est une chaîne de caractère vide, pourtant en mode "treeview" je sélectionne bien le nom de session avant de cliquer sur un bouton Configure/View 8:01:04: Begin: Sirilic() 18:01:05: wd: /Users/stephane/Pictures/Demo Siril 18:01:05: configdir: /Users/stephane/Library/Application Support/org.siril.Siril/siril 18:01:05: get_siril_userdatadir: /Users/stephane/Library/Application Support/org.siril.Siril/siril 18:01:05: get_siril_systemdatadir: /Applications/Siril.app/Contents/Resources/share/siril 18:01:16: type: <class 'str'> , value= 18:01:16: Exception in Tkinter callback 18:01:16: Traceback (most recent call last): 18:01:16: File "/Applications/Siril.app/Contents/Frameworks/Python.framework/Versions/3.12/lib/python3.12/tkinter/__init__.py", line 1968, in __call__ 18:01:16: return self.func(*args) 18:01:16: ^^^^^^^^^^^^^^^^ 18:01:16: File "/Users/stephane/Downloads/App/sirilic/sirilic.py", line 188, in cbView 18:01:16: (object,layer,session) = shdata.root.fs.GetSelection() 18:01:16: ^^^^^^^^^^^^^^^^^^^^^^ 18:01:16: ValueError: not enough values to unpack (expected 3, got 0) -

Sirilic 2.0.0 Release Candidate 1

keymlinux a répondu à un sujet de m27trognondepomme dans Logiciel SIRILIC de Siril et Sirilic

même message d'erreur -

Sirilic 2.0.0 Release Candidate 1

keymlinux a répondu à un sujet de m27trognondepomme dans Logiciel SIRILIC de Siril et Sirilic

J'obtiens alors le message suivant (valable avec View et avec Configure) 5:27:47: Exception in Tkinter callback 15:27:47: Traceback (most recent call last): 15:27:47: File "/Applications/Siril.app/Contents/Frameworks/Python.framework/Versions/3.12/lib/python3.12/tkinter/__init__.py", line 1968, in __call__ 15:27:47: return self.func(*args) 15:27:47: ^^^^^^^^^^^^^^^^ 15:27:47: File "/Users/stephane/Downloads/App/sirilic/sirilic.py", line 188, in cbView 15:27:47: (object,layer,session) = shdata.root.fs.GetSelection() 15:27:47: ^^^^^^^^^^^^^^^^^^^^^^ 15:27:47: ValueError: not enough values to unpack (expected 3, got 0) -

Sirilic 2.0.0 Release Candidate 1

keymlinux a répondu à un sujet de m27trognondepomme dans Logiciel SIRILIC de Siril et Sirilic

3 autres soucis 1) dans les options (bouton configure) lorsque je coche l'option pour soustraire les biases au flats, cela ne génère pas l'option voulue dans le script et cela ne modifie rien dans la vue graphique (bouton view), les biases sont empilés mais non utilisés EDIT: Correction: l'option est bien prise en charge pour le script, mais j'avais oublié de faire "rebuild". Seule la fenêtre de "vue graphique" du process est affectée 2) pour utiliser les boutons configure et view, il faut avoir sélectionné une session, mais cela ne fonctionne pas is on a coché l'option de vue arborescente (tree view), on a alors l'erreur suivante: 5:05:30: Exception in Tkinter callback 15:05:30: Traceback (most recent call last): 15:05:30: File "/Applications/Siril.app/Contents/Frameworks/Python.framework/Versions/3.12/lib/python3.12/tkinter/__init__.py", line 1968, in __call__ 15:05:30: return self.func(*args) 15:05:30: ^^^^^^^^^^^^^^^^ 15:05:30: File "/Users/stephane/Downloads/App/sirilic/sirilic.py", line 188, in cbView 15:05:30: (object,layer,session) = shdata.root.fs.GetSelection() 15:05:30: ^^^^^^^^^^^^^^^^^^^^^^^^^^^^^ 15:05:30: File "/Users/stephane/Downloads/App/sirilic/sirilic.py", line 268, in GetSelection 15:05:30: value = value[0].split("/") 15:05:30: ~~~~~^^^ 15:05:30: IndexError: string index out of range EDIT: 3) lors de l'utilisation du bouton "update" pour mettre a jour la session, ici aussi je pense que cal est du au fait que le nom de session que j'utilise ne contient que des chiffres et est interprété comme un entier et pas une chaîne 5:14:31: Exception in Tkinter callback 15:14:31: Traceback (most recent call last): 15:14:31: File "/Applications/Siril.app/Contents/Frameworks/Python.framework/Versions/3.12/lib/python3.12/tkinter/__init__.py", line 1968, in __call__ 15:14:31: return self.func(*args) 15:14:31: ^^^^^^^^^^^^^^^^ 15:14:31: File "/Users/stephane/Downloads/App/sirilic/sirilic.py", line 106, in cbUpdate 15:14:31: if re.search(r'\d+$',session_no) : 15:14:31: ^^^^^^^^^^^^^^^^^^^^^^^^^^^^^ 15:14:31: File "/Applications/Siril.app/Contents/Frameworks/Python.framework/Versions/3.12/lib/python3.12/re/__init__.py", line 177, in search 15:14:31: return _compile(pattern, flags).search(string) 15:14:31: ^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^ 15:14:31: TypeError: expected string or bytes-like object, got 'int' -

Sirilic 2.0.0 Release Candidate 1

keymlinux a répondu à un sujet de m27trognondepomme dans Logiciel SIRILIC de Siril et Sirilic

Salut, Je viens de faire quelques test sur MacOS Pas de problème de déploiement, 1er lancement avec chargement des paquets de dépendance OK L'interface s'affiche sans soucis graphiques. La génération de script et l'éditeur de script sont OK note: je precise cela car ce sont des éléments où nous avions rencontré des problèmes spécifiques à l'environnement MacOS par le passé. Les soucis: Lors de la creation d'un nouveau projet, lorsque je souhaite ajouter des images j'ai le message suivant (lors du click bouton Add images) 10:44:40: Exception in Tkinter callback 10:44:40: Traceback (most recent call last): 10:44:40: File "/Applications/Siril-1.4.app/Contents/Frameworks/Python.framework/Versions/3.12/lib/python3.12/tkinter/__init__.py", line 1968, in __call__ 10:44:40: return self.func(*args) 10:44:40: ^^^^^^^^^^^^^^^^ 10:44:40: File "/Users/stephane/Downloads/App/sirilic/sirilic.py", line 233, in cbAddImages 10:44:40: keystr = shdata.idb.KeyStr(object,layer,session) 10:44:40: ^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^ 10:44:40: File "/Users/stephane/Downloads/App/sirilic/lib/database.py", line 140, in KeyStr 10:44:40: return ObjectName + KwKeyStr + LayerName + KwKeyStr + SessionName 10:44:40: ~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~^~~~~~~~~~~~~ 10:44:40: TypeError: can only concatenate str (not "int") to str Si je charge un projet existant (avec des images déjà déclarées), j'ai un message similaire lorsque je clique sur le bouton "configure" 10:42:36: Exception in Tkinter callback 10:42:36: Traceback (most recent call last): 10:42:36: File "/Applications/Siril-1.4.app/Contents/Frameworks/Python.framework/Versions/3.12/lib/python3.12/tkinter/__init__.py", line 1968, in __call__ 10:42:36: return self.func(*args) 10:42:36: ^^^^^^^^^^^^^^^^ 10:42:36: File "/Users/stephane/Downloads/App/sirilic/sirilic.py", line 203, in cbConfigure 10:42:36: keystr = shdata.idb.KeyStr(object,layer,session) 10:42:36: ^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^ 10:42:36: File "/Users/stephane/Downloads/App/sirilic/lib/database.py", line 140, in KeyStr 10:42:36: return ObjectName + KwKeyStr + LayerName + KwKeyStr + SessionName 10:42:36: ~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~^~~~~~~~~~~~~ 10:42:36: TypeError: can only concatenate str (not "int") to str EDIT: comme mon nom de session est "20200719" et ne contient que des chiffres et pas de lettre, je pense qu'il traite cela comme un entier et pas comme une chaîne, d'où l'erreur lors de la concatenation de chaîne EDIT2: du coup en remplaçant (dans database.py) return ObjectName + KwKeyStr + LayerName + KwKeyStr + SessionName par return ObjectName + KwKeyStr + LayerName + KwKeyStr + str(SessionName) cela fonctionne Cordialement -

EAF : marques ? Avis ? Conseils ?

keymlinux a répondu à un sujet de lionthom dans Matériel astrophotographique

Oui, le port a un format usb-C mais en terme de protocole/débit cela sera de l'USB 2.0 EDIT: d'ailleurs dans la boite P.O a aussi mis 2 petits cables USB 2.0 de 50cm, un usb-c/usb-c et un usb-c/usb-b qui sont justement fait pour brancher un autre périphérique en mode chainé sur le port "device" de la camera -

EAF : marques ? Avis ? Conseils ?

keymlinux a répondu à un sujet de lionthom dans Matériel astrophotographique

Bonjour, Sur la caméra poseidon-c il y a un ports usb pour brancher un autre périphérique. Certes il est en usb-c, mais l’eaf-n aussi, et pour un focuser conçurent avec prise usb-a, avec un adaptateur usb-c mâle vers usb-a femelle tu dois pouvoir connecter. note: j’ai un eaf gen1 avec alim12v, donc non concerné par ton problème pour alimenter en usb. l’eaf a certes du backslash mais cela ne ma jamais posé problème, la plupart des softs de mise au point gèrent bien cela (kstars/ekos/indi en ce qui me concerne) Sinon tu peux aussi migrer vers un hub usb alimenté, comme cela cela ne vas pas tirer sur le port usb de la tablette Cordialement