astrojh

Membre-

Compteur de contenus

498 -

Inscription

Type de contenu

Profils

Forums

Téléchargements

Blogs

Boutique

Calendrier

Noctua

Tout ce qui a été posté par astrojh

-

Tech Pb ALS (Astro Live Stacker) sur AstroArch...

astrojh a répondu à un sujet de pti-jean dans Raspberry, Tinkerboard, etc... de Linux et astronomie

D'où provient l'archive que tu as dézippée ? Il est probable qu'elle ne soit pas adaptée à Arch Linux et qu'il faille faire une installation à partir des sources. Pour ma part, je ne fais pas de VA, je ne saurais donc te conseiller. A+ -

Tech Pb ALS (Astro Live Stacker) sur AstroArch...

astrojh a répondu à un sujet de pti-jean dans Raspberry, Tinkerboard, etc... de Linux et astronomie

Bonjour, Ça peut venir de plein de choses différentes (pb de chemin, de droit d'exécution, de version 32/64 bits...). Pourrais-tu préciser comment tu as fait l'installation ? A+ -

Tech Pb AstroArch, pas d'option "Sélectionner les télescopes" ???

astrojh a répondu à un sujet de pti-jean dans Raspberry, Tinkerboard, etc... de Linux et astronomie

Bonjour, La gestion des configurations optiques a changé depuis la version 3.6.1 d'Ekos, elle passe maintenant par les trains optiques. Plus d'infos ici : https://knro.blogspot.com/2022/10/kstars-v361-released.html?m=1 A+ -

La dernière version d'Easy Astro Box date de février 2023, peut-être que les drivers Player One ont été mis à jour depuis. Ça vaudrait le coup de mettre à jour Kstars/EKOS (tu as quelle version installée) ou de tester une distribution astro plus récente et à jour (par exemple Astroarch : https://github.com/devDucks/astroarch). A+

-

Bonjour, Kstars/EKOS est installé dans Easy Astro Box, as-tu essayé de l'utiliser pour tes acquisitions en ciel profond (plutôt que Firecapture) ? A+

-

Observations près de Lavelanet (09)

astrojh a répondu à un sujet de IIIIIKK dans Les rencontres astro

Bonjour à tous, Un petit up pour ceux qui sont intéressés A+ -

Tech PB Astroberry v10 et non v12...

astrojh a répondu à un sujet de pti-jean dans Raspberry, Tinkerboard, etc... de Linux et astronomie

Bonjour, La dernière mise à jour d'Astroberry date d'octobre 2021 (https://github.com/rkaczorek/astroberry-server), donc ceci explique peut-être cela. Le projet ne semble plus trop actif... Alternativement tu peux tester Astroarch, qui vient de passer en version 1.8 : https://github.com/devDucks/astroarch Ça marche très bien A+ -

Observations près de Lavelanet (09)

astrojh a répondu à un sujet de IIIIIKK dans Les rencontres astro

Bonjour @jps81 Et re-bienvenu J'ai bien récupéré tes informations, je t'invite à éditer ton message ci-dessus pour les supprimer (on ne sait jamais...). Pour ceux qui sont intéressés, envoyez-moi vos infos par MP uniquement. A+ -

Observations près de Lavelanet (09)

astrojh a répondu à un sujet de IIIIIKK dans Les rencontres astro

Bonjour à tous, Le printemps est de retour, la saison 2024 de Beille pointe le bout de son nez Si vous souhaitez une autorisation pour circuler sur le Plateau et pouvoir rejoindre le stade de biathlon où on observe l'été, n'hésitez pas à m'envoyer par MP vos informations : Prénom, Nom, Véhicule (marque, modèle, couleur), Immatriculation. J'enverrai l'ensemble de nos demandes à la mairie de Luzenac vers mi-avril. [Par contre on peut oublier le weekend du 14/7, le Tour de France passe par le plateau cette année...] A bientôt ! -

SIRIL : traitement lrvb. Comment aligner la luminance

astrojh a répondu à un sujet de buysschaert dans Logiciels

Bonjour, Désolé pour la réponse tardive, tu as peut-être trouvé une solution entre temps Il faut en effet avoir aligné les 4 images avant de faire la composition LRGB. Pour cela, il faut créer une séquence à partir des 4 images en les renommant, par exemple : image_L.fits --> compo_1.fits image_R.fits --> compo_2.fits image_G.fits --> compo_3.fits image_B.fits --> compo_4.fits Ensuite, aller dans la fenêtre "séquence" et cliquer "chercher séquences" pour que Siril trouve la séquence compo_ (si besoin changer le répertoire de travail pour pointer au bon endroit). Une fois la séquence chargée, aller dans la fenêtre "alignement", lancer l'alignement. Siril va créer les images r_compo_1, r_compo_2, r_compo_3 et r_compo_4. Et maintenant tu peux ouvrir l'outil de composition RVB et sélectionner l'image r_compo qui correspond à chaque canal. Un lien qui peut être utile : https://siril.org/fr/tutorials/rgb_composition/ A+ -

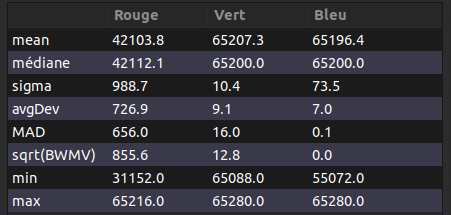

Bonjour, Le fichier master flat que tu as joint montre clairement une saturation, cf les stats ci-dessous calculées par Siril où on voit des valeurs moyennes au-dessus de 65000 pour les canaux vert et bleu. Il faut en effet que tu indiques dans EKOS la valeur max à ne pas dépasser et EKOS ajustera le temps d'exposition pour satisfaire ton critère. La valeur à indiquer doit l'être par rapport à une dynamique de 16 bits (même si ton ADC est en 12 bits). Je pense que le problème vient de la valeur que tu utilises (45000), qui est trop élevée. Pour une 1600, c'est plutôt autour de 20000-25000 (cf https://indilib.org/forum/ekos/8188-ekos-autoamted-flat-and-adu.html#63046). A+

-

L'image est téléchargeable dans la section 'Download' du repo git (lien direct: https://drive.google.com/file/d/1vzjsdnsjHVAxAyEpe2_x1QqqdAXlll5u/view) J'ai fait l'installation de la v1.8 en quelques minutes, aucun problème. C'est vrai que cela aurait plus pratique de pouvoir faire la mise à jour depuis la v1.7 mais avec l'outil astromonitor (inclus dans la distribution) il est possible de faire un backup de sa configuration et de la réinstaller ensuite sur la nouvelle version. A+

-

Bonsoir, Merci pour l'info J'utilise depuis quelque temps la version 1.7 sur un RPI4, je confirme que c'est une très bonne distribution, réactive et stable. Cette nouvelle version 1.8 apporte des améliorations au niveau performances et de nouvelles fonctionnalités, je pense que je vais faire la migration très rapidement A+

-

Astrophoto : comment compléter mon Samyang 135mm f2 ?

astrojh a répondu à un sujet de jjs dans Matériel astrophotographique

Bonjour, Te voilà très bien équipé avec le 6D Pour le microfocuser, j'ai pris le modèle avec microfocuser manuel d'Astrokraken, depuis je me suis fait un système DIY avec un arduino + moteur + courroie, que je pilote depuis EKOS, c'est pas indispensable mais bien plus confortable J'ai un Bahtinov simple, j'ai jamais testé la version 'tri'. Je l'ai d'ailleurs fixé à un servomoteur accroché au pare-buée et je le pilote aussi à distance avec EKOS, ce qui fait que je ne sors que pour la mise en station, tout le reste je le fais au chaud Il n'y a plus qu'à avoir un bout de ciel clair maintenant ! -

Astrophoto : comment compléter mon Samyang 135mm f2 ?

astrojh a répondu à un sujet de jjs dans Matériel astrophotographique

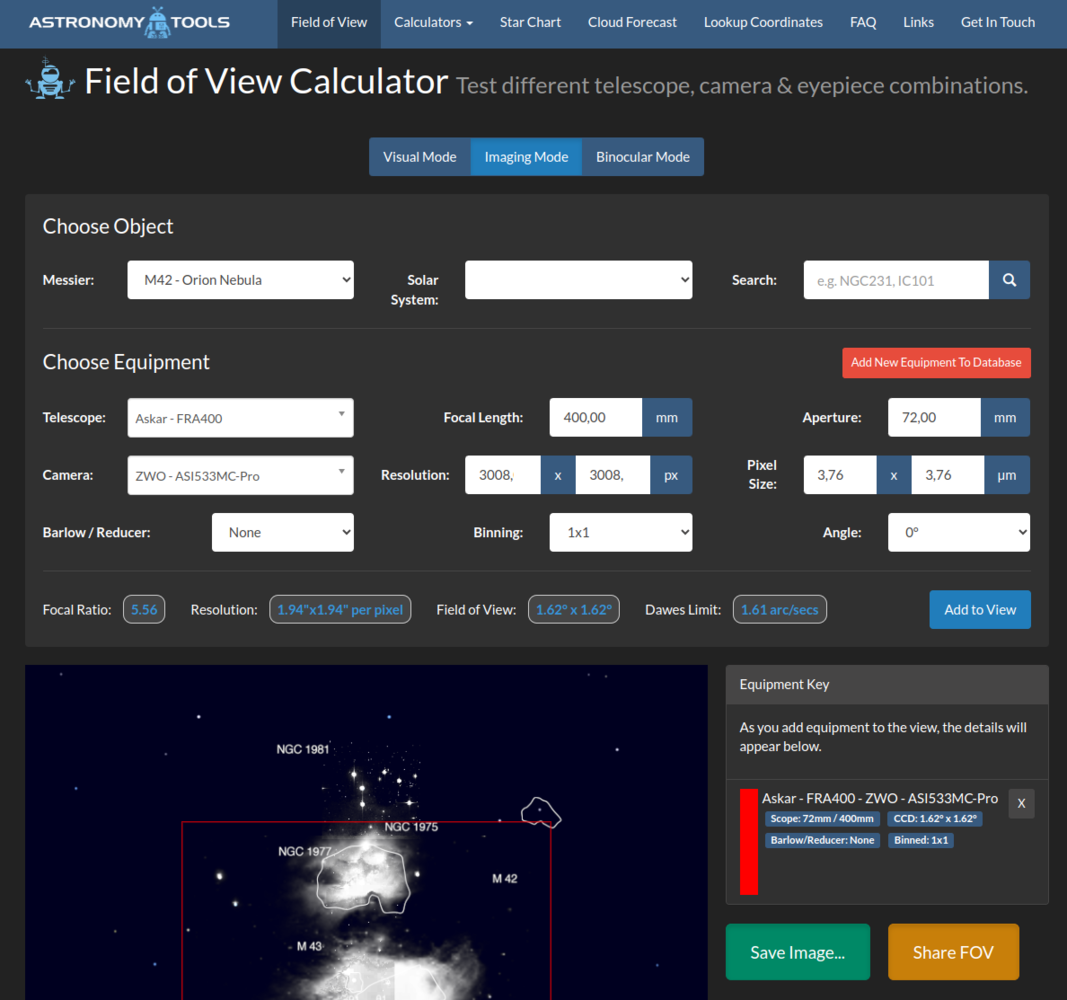

Bonjour, Félicitations pour ces acquisitions J'ai également un Samyang voici quelques éléments de réponse : pour le choix caméra / APN et le format : difficile à dire, cela dépend des cibles que tu veux faire (très grands champs, échantillonnage plus fin, RVB ou bande étroite...), du temps que tu veux passer au traitement (plus long de traiter des images monochromes multi-bandes que des images couleurs) et du budget que tu veux y mettre. J'ai commencé avec un Canon 1000D (format APS-C), j'ai actuellement une ASI183 monochrome et une roue à filtres. Le capteur est moins grand que l'APS-C mais les pixels sont petits ce qui permet d'avoir davantage de détails sur les objets. Il y a des capteurs plus performants et plus grands que la 183 (533, 2600...), tu peux simuler le champ couvert par ces différents capteurs sur les objets qui t'intéressent sur ce site : https://astronomy.tools/calculators/field_of_view/ (il faut choisir la rubrique "imaging mode"). côté pilotage, j'utilise un raspberry pi4 avec une distribution AstroArch, qui intègre Kstars/EKOS. En nomade le rpi4 crée un point d'accès wifi, on s'y connecte avec une tablette ou un PC et on contrôle l'ensemble du matériel à travers le navigateur internet, c'est très fluide. Il y a plein d'autres solutions : ASIAIR, Stellarmate, mini-PC... pour le guidage : pas forcément nécessaire vu l'échantillonnage et les temps de pose relativement courts grâce au rapport F/D. Ça peut de toute façon s'ajouter plus tard si tu en as besoin. A voir aussi en fonction de la précision de suivi de la Star Adventurer. J'ajoute quelques accessoires qui peuvent être utiles : à F/D 2, la mise au point est sensible, un masque de Bahtinov facilite grandement la tâche pour voir si on est au point ou pas. un support équipé avec un microfocuser aide aussi à obtenir une bonne mise au point (par exemple https://azur3dprintshop.com/92-1080-support-samyang-pro.html#/84-choix_queue_d_aronde-format_vixen/92-choix_porte_accessoire-aucun/94-kit_eaf-non/96-bague_de_mise_au_point-oui ou http://www.astrokraken.fr/samyang-135mm-f-2-bracket-micro-focuser-a145773756). pour avoir des étoiles un peu plus piquées (notamment en bande large), je diaphragme à 2.8. Je me suis fait pour cela une bague en impression 3D que je place sur le pare-buée, Cela évite d'utiliser la bague de diaphragme (qui crée des aigrettes sur les étoiles brillantes). A+ -

Bonjour, Une petite piste à explorer à partir du code de AllSky (je suppose que c'est celui-ci : https://github.com/AllskyTeam/allsky/tree/master) : La qualité du timelapse est fixée par le bit rate de la vidéo, ça se passe ligne 251 du fichier https://github.com/AllskyTeam/allsky/blob/master/scripts/timelapse.sh où la variable TIMELAPSE_BITRATE est utilisée. Cette variable est définie dans le fichier https://github.com/AllskyTeam/allsky/blob/master/config_repo/config.sh.repo à la ligne 63 : TIMELAPSE_BITRATE="5000k" Il suffit de tester avec une valeur plus élevée pour voir si ça améliore le rendu. Je pense qu'il est possible de tester sans tout réinstaller. De mémoire (plus très fraîche...), il doit y avoir un fichier config.sh qui est créé à partir du fichier config.sh.repo lors de l'installation de AllSky. Il suffit de modifier ce fichier plutôt que cofig.sh.repo pour voir ce que ça donne. A+

-

Bonsoir, Pour le driver il faut peut-être le désinstaller / réinstaller, à tester. Concernant les softs, généralement il est possible de délimiter une région d'intérêt (ROI, region of interest) pour éviter de capturer trop de noir autour de l'objet et de consommer de la bande passante pour rien (ce qui réduit le débit image). Est-ce ça dont tu parles ? Je ne suis plus trop au fait des softs pour le planétaire mais tu peux regarder du côté de firecapture (https://www.youtube.com/watch?v=DJ1SpbCmM9U&ab_channel=FireCapture) ou sharpcap par exemple (https://docs.sharpcap.co.uk/4.1/#Region Of Interest Selection (Pan%2FTilt)) pour voir comment c'est fait. A+

-

Bonjour, Les deux dimensions sont nécessaires car les tailles et le rapport largeur/hauteur dépendent des normes (24x36, APS-C, 4/3", etc.), voir par exemple le tableau au milieu de cette page : https://fr.wikipedia.org/wiki/Capteur_photographique Un site intéressant pour voir si un objet entre dans le champ d'un capteur est https://astronomy.tools/calculators/field_of_view/ Il faut choisir le mode 'Imaging mode' et entrer les valeurs pour l'optique (focale) et les dimensions du capteur (nombre de pixels et taille des pixels). Des valeurs sont prédéfinies pour les instruments et caméras classiques du marché (ça évite chercher les infos). On choisit ensuite l'objet et ça représente le champ couvert. Par exemple :

-

Quelle est la procédure pour exporter une photo de darktable vers Gimp ?

astrojh a répondu à un sujet de Glloq dans Astrophotographie

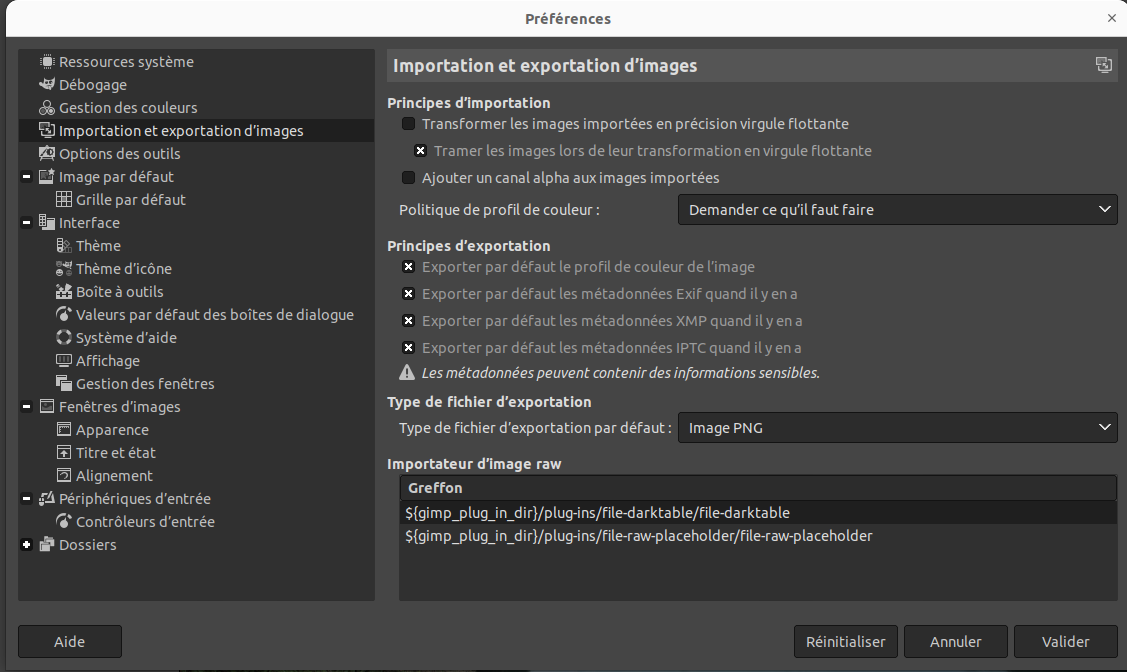

Bonsoir, Pourrais-tu aussi préciser l'OS et la version de Gimp ? Il faut vérifier dans Gimp que le chemin d'échange avec Darktable est bien indiqué dans les préférences, comme on peut le voir sur la capture d'écran dans le cadre "Importateur d'images raw" en bas à droite. Attention ce chemin peut être absent dans la version Ubuntu packagée en SNAP (et donc ça ne marche pas) alors qu'il y est dans la version PPA (et là ça marche très bien ). Donc le pb peut venir de là, si ton OS est Ubuntu. A+ -

Bonjour, Autre solution 64 bits qui marche très bien sur un RPI4 : AstroArch ( https://github.com/devDucks/astroarch) L'utilisation se fait dans un navigateur web à l'aide de noVNC, c'est très fluide. On s'y connecte grâce au hotspot wifi créé par AstroArch ou alors directement à partir de l'adresse IP du RPI4 si celui-ci est relié à la box de la maison avec un câble ethernet. La seule restriction est l'absence de support HDMI mais ce n'est pas vraiment limitant pour notre usage. A+

-

Comète-Astéroide 12P/Pons besoin de conseils

astrojh a répondu à un sujet de le greolois dans Astrophotographie

Bonjour, Pourrais-tu nous partager la sortie de ta console Siril pour comprendre à quel moment ça plante et pourquoi ? Au fait si tu fais le recadrage comme on te l'a indiqué, fais-le après le prétraitement car si tu le fais avant, tu vas te retrouver avec des brutes qui ont une taille plus petite que les DOF, ça peut poser souci (j'ai pas vérifié mais c'est probable que ça plante ou que ça donne des résultats pas cohérents). A+ -

Comète-Astéroide 12P/Pons besoin de conseils

astrojh a répondu à un sujet de le greolois dans Astrophotographie

Bonjour, Pour le recadrage des fits, c'est possible en traçant sur une brute la zone à garder puis clic-droit et 'recadrer la séquence'. Pour l'alignement, comment as-tu fait ? Tu passes par le mode 'Astéroïde/Comète' ou un autre ? A+ -

Merci @Ryo

-

Merci @nico1038 pour ta remarque, voici une version légèrement retravaillée avec un peu plus de saturation

-

Bonjour à tous, Le beau temps est revenu sur le sud-ouest, j'en ai profité hier soir pour shooter M33 au Samyang. Côté matériel : Samyang 135 fermé à F2.8, ASI183MM pro, filtres RGB, HEQ5 Rowan, guidage au chercheur 30/120. Côté poses: 120 poses de 30 secondes par couche, soit 3h en tout. Pilotage au chaud avec KStars/EKOS (Raspberry Pi avec distribution AstroArch). Pretraitement Siril, finition sous Gimp (niveaux, légère réduction d'étoiles, crop) et Darktable (réduction bruit astrophoto). Je vous la présente à l’échantillonnage natif, j'ai juste fait un crop des bords pour ne garder que la partie centrale de l'image. N'hésitez pas si vous avez des remarques pour m'améliorer